Annotation

- Introducción

- El Costo Ambiental Oculto de la IA Moderna

- Consumo de Recursos Insostenible

- Escalado Cuadrático: El Cuello de Botella Arquitectónico

- Aprendiendo de la Computadora Maestra de la Naturaleza

- El Plano de Eficiencia del Cerebro Humano

- Pseudo-Spiking: Conectando Biología y Tecnología

- Técnicas Avanzadas de Codificación por Pulsos

- SpikingBrain: Demostración Práctica de Eficiencia

- Implicaciones Económicas y de Accesibilidad

- Pros y Contras

- Aplicaciones Amplias en Diversas Industrias

- Conclusión

- Preguntas frecuentes

IA Inspirada en el Cerebro: Revolución de la Computación Sostenible para la Eficiencia Energética

Los modelos de IA inspirados en el cerebro emulan la eficiencia del cerebro humano para reducir el uso de energía hasta en un 97% con redes neuronales de picos, permitiendo una computación sostenible y

Introducción

La inteligencia artificial ha logrado capacidades notables, desde la generación de contenido creativo hasta la resolución de problemas complejos, sin embargo, estos avances conllevan un costo ambiental insostenible. Los sistemas actuales de IA consumen cantidades asombrosas de energía, amenazando con detener el progreso tecnológico. Esta exploración revela cómo la computación inspirada en el cerebro ofrece un camino sostenible hacia adelante, extrayendo del modelo computacional más eficiente de la naturaleza para crear una IA que sea tanto poderosa como ambientalmente responsable.

El Costo Ambiental Oculto de la IA Moderna

Consumo de Recursos Insostenible

Aunque los modelos de IA demuestran capacidades impresionantes en codificación, creación artística y diálogo sofisticado, estos logros ocultan una crisis de sostenibilidad crítica. La arquitectura transformadora, que permitió la actual revolución de la IA, contiene defectos de diseño fundamentales que la hacen excepcionalmente intensiva en recursos. Entrenar modelos de lenguaje grandes como GPT-3 consume energía equivalente al uso anual de múltiples hogares, planteando serias preocupaciones ambientales sobre la escalabilidad continua de modelos.

Las demandas de recursos se extienden más allá de la energía para incluir poder computacional, requisitos de refrigeración y hardware especializado. A medida que los modelos se vuelven más grandes y complejos, estos requisitos escalan exponencialmente, creando barreras de entrada para organizaciones más pequeñas e investigadores. Esta concentración de capacidad de IA amenaza la diversidad de innovación y la accesibilidad en el panorama tecnológico, haciendo que las plataformas de automatización de IA eficientes sean cada vez más valiosas.

Escalado Cuadrático: El Cuello de Botella Arquitectónico

La limitación fundamental de la arquitectura transformadora reside en el escalado cuadrático, donde los costos computacionales aumentan cuadráticamente con la longitud de la secuencia de entrada. Al procesar un documento, duplicar su longitud cuadruplica los requisitos computacionales en lugar de simplemente duplicarlos. Este crecimiento exponencial de costos crea barreras significativas para aplicaciones que requieren comprensión de contexto largo, como el análisis de documentos legales, el procesamiento de registros médicos o el análisis literario.

La explicación técnica implica el requisito del mecanismo de atención de comparar cada palabra con todas las demás en una secuencia. A medida que la longitud de la secuencia aumenta, el número de comparaciones crece a un ritmo insostenible. Esta restricción arquitectónica requiere aceptar limitaciones de rendimiento o invertir en infraestructura computacional cada vez más poderosa, aumentando tanto los costos económicos como ambientales para las organizaciones que implementan APIs y SDKs de IA.

Aprendiendo de la Computadora Maestra de la Naturaleza

El Plano de Eficiencia del Cerebro Humano

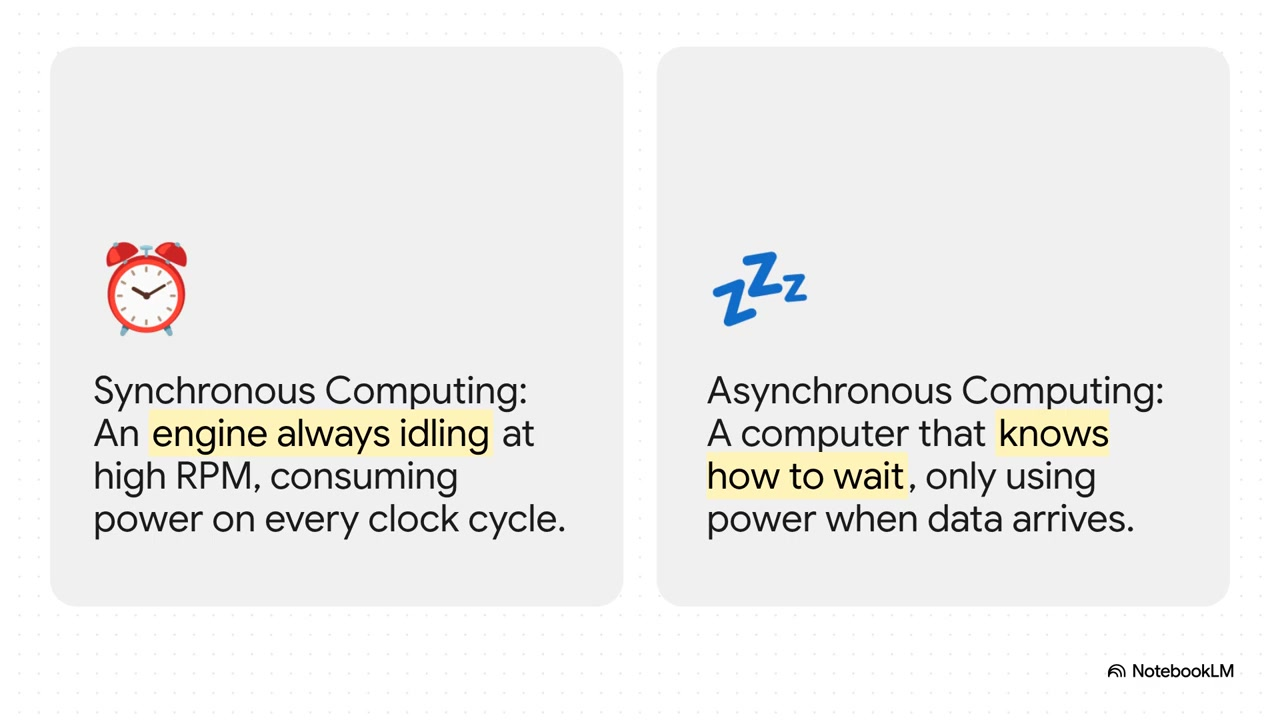

El cerebro humano representa el estándar de oro para la eficiencia computacional, realizando tareas cognitivas complejas mientras consume solo alrededor de 20 vatios de potencia – menos que una bombilla estándar. Esta notable eficiencia resulta de millones de años de optimización evolutiva, ofreciendo lecciones valiosas para el diseño de sistemas de IA. A diferencia de las computadoras convencionales que mantienen niveles de actividad constantes, el cerebro opera sobre un principio impulsado por eventos donde las neuronas se activan solo cuando es necesario.

Este patrón de activación dispersa contrasta marcadamente con los enfoques tradicionales de IA, donde todos los componentes computan continuamente independientemente de la relevancia. El secreto del cerebro no está en una computación más rápida sino en la evitación estratégica de la computación – procesando solo información esencial cuando se necesita. Esta inspiración biológica impulsa la investigación en arquitecturas de computación neuromórfica que podrían revolucionar cómo abordamos el alojamiento de modelos de IA y la implementación.

Pseudo-Spiking: Conectando Biología y Tecnología

Las técnicas de pseudo-spiking representan un compromiso práctico entre la precisión biológica y la viabilidad computacional. En lugar de replicar perfectamente el comportamiento neural en hardware convencional, estos métodos aproximan los patrones de computación dispersos e impulsados por eventos del cerebro. Este enfoque permite ahorros significativos de energía mientras mantiene la compatibilidad con la infraestructura GPU existente, permitiendo beneficios de implementación inmediata sin requerir chips neuromórficos especializados.

Aunque algunos críticos argumentan que el pseudo-spiking simplemente reempaqueta las técnicas existentes de multiplicación de matrices, los beneficios prácticos demuestran su valor como una tecnología transicional. Al permitir que la innovación en software progrese independientemente del desarrollo de hardware, el pseudo-spiking acelera la adopción de paradigmas de computación eficientes. Este enfoque beneficia particularmente a los desarrolladores que trabajan con agentes y asistentes de IA que requieren operación continua.

Técnicas Avanzadas de Codificación por Pulsos

Las redes neuronales de pulsos emplean varias estrategias de codificación para optimizar la eficiencia de transmisión de información. La codificación binaria de pulsos representa el enfoque más simple, utilizando patrones de activación densos para transmitir información a lo largo del tiempo. Aunque es sencillo de implementar, este método resulta relativamente ineficiente en comparación con alternativas más sofisticadas que imitan mejor la comunicación neural biológica.

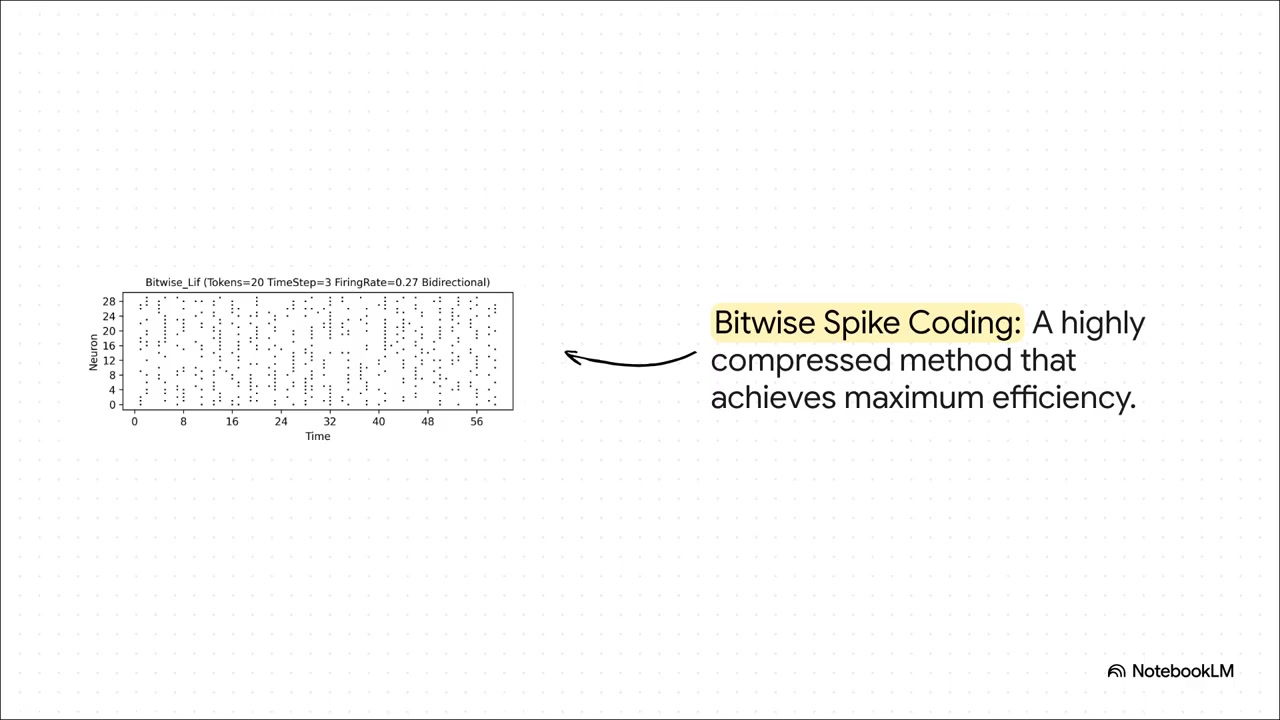

La codificación ternaria introduce señales inhibitorias junto con las excitatorias, permitiendo una representación de información más matizada con patrones de activación más dispersos. Este enfoque permite que los circuitos neurales realicen operaciones de resta además de suma, creando capacidades computacionales más sofisticadas. La codificación bitwise representa la técnica más avanzada, logrando la máxima eficiencia a través de patrones de pulsos altamente comprimidos que empaquetan información sustancial en una actividad neural mínima.

SpikingBrain: Demostración Práctica de Eficiencia

El modelo SpikingBrain ejemplifica el potencial práctico de la computación inspirada en el cerebro, logrando ganancias de eficiencia notables a través de la omisión estratégica de computación. Los resultados experimentales demuestran que SpikingBrain evita aproximadamente el 70% de los cálculos potenciales mientras mantiene niveles de rendimiento competitivos. Más impresionantemente, el modelo genera su salida inicial más de 100 veces más rápido que los sistemas tradicionales al procesar documentos largos.

Este rendimiento desafía la sabiduría convencional de que las mejoras de eficiencia necesariamente comprometen la inteligencia o la precisión. SpikingBrain demuestra que un diseño arquitectónico cuidadoso puede ofrecer tanto velocidad como confiabilidad, abordando preocupaciones sobre el compromiso entre inteligencia y velocidad que a menudo afecta a los sistemas optimizados. Tales avances podrían impactar significativamente en aplicaciones que requieren optimización de sistemas y procesamiento en tiempo real.

Implicaciones Económicas y de Accesibilidad

Más allá de los beneficios ambientales, la computación inspirada en el cerebro promete ventajas económicas sustanciales al reducir los recursos computacionales requeridos para la implementación de IA. Un menor consumo de energía se traduce directamente en costos operativos reducidos, haciendo que las capacidades avanzadas de IA sean accesibles para organizaciones más pequeñas e investigadores individuales. Este potencial de democratización podría desatar olas de innovación a medida que más perspectivas diversas contribuyan al desarrollo de IA.

Las estimaciones de reducción de energía alcanzan el 97% para tareas computacionales específicas, potencialmente transformando la IA de una tecnología exclusiva e intensiva en recursos en una herramienta ampliamente accesible. Este cambio podría descentralizar el desarrollo de IA, reduciendo la dependencia de las principales corporaciones tecnológicas y fomentando ecosistemas de innovación más diversos. Tales desarrollos se alinean bien con herramientas centradas en la gestión de energía y la optimización de eficiencia.

Pros y Contras

Ventajas

- Reducción drástica en el consumo de energía y el impacto ambiental

- Aumento de la accesibilidad a través de requisitos de hardware más bajos

- Potencial para un rendimiento superior en tareas cognitivas complejas

- Compatibilidad con plataformas de hardware neuromórfico emergentes

- Tiempos de respuesta más rápidos para aplicaciones en tiempo real

- Costos operativos reducidos para servicios de IA continuos

- Fundación para sistemas de IA más biológicamente plausibles

Desventajas

- Complejidad de implementación que requiere experiencia especializada

- Limitaciones actuales de hardware que limitan las ganancias potenciales de eficiencia

- Patrones de comportamiento impredecibles en algunas configuraciones

- Ciclos de desarrollo más largos en comparación con enfoques tradicionales

- Recursos limitados de herramientas y soporte comunitario

Aplicaciones Amplias en Diversas Industrias

Las tecnologías de IA eficientes prometen impactos transformadores en múltiples sectores al permitir la implementación en entornos con recursos limitados. La atención médica podría ver herramientas de diagnóstico impulsadas por IA llegando a áreas remotas con infraestructura eléctrica limitada. Las ciencias ambientales podrían aprovechar modelos climáticos eficientes que proporcionen predicciones precisas sin demandas computacionales excesivas.

Áreas de aplicación adicionales incluyen análisis financiero, herramientas educativas, optimización de manufactura y sistemas de transporte – todos beneficiándose de costos operativos reducidos y mayor flexibilidad de implementación. Estos avances podrían trabajar sinérgicamente con herramientas de evaluación comparativa de sistemas para medir con precisión las mejoras de eficiencia.

Conclusión

La computación inspirada en el cerebro representa un cambio de paradigma en el desarrollo de la inteligencia artificial, abordando los desafíos críticos de sostenibilidad que enfrentan los enfoques actuales. Al aprender de la excepcional eficiencia del cerebro humano, los investigadores están creando sistemas de IA que ofrecen capacidades poderosas sin un consumo excesivo de recursos. Aunque persisten desafíos de implementación, los beneficios demostrados de modelos como SpikingBrain confirman el potencial práctico de este enfoque. A medida que el campo avanza, la IA inspirada en el cerebro promete hacer que la inteligencia artificial sea más accesible, sostenible y capaz – creando finalmente tecnología que sirva a la humanidad sin comprometer nuestro futuro ambiental.

Preguntas frecuentes

¿Cuál es el principal problema con los sistemas de IA actuales?

Los sistemas de IA actuales consumen cantidades insostenibles de energía y recursos computacionales, con el entrenamiento de grandes modelos que utilizan energía equivalente a la de múltiples hogares anualmente. Este impacto ambiental amenaza el progreso continuo y la accesibilidad de la IA.

¿Qué tan eficiente es el cerebro humano en comparación con la IA?

El cerebro humano realiza cálculos complejos utilizando solo unos 20 vatios de potencia, menos que una bombilla estándar, mientras que los sistemas de IA actuales requieren órdenes de magnitud más de energía para tareas similares.

¿Qué son las redes neuronales de picos?

Las redes neuronales de picos imitan la computación dirigida por eventos del cerebro, donde las neuronas artificiales se activan solo cuando es necesario en lugar de calcular continuamente. Este patrón de activación disperso reduce drásticamente el consumo de energía.

¿Cuánta energía puede ahorrar la IA inspirada en el cerebro?

La investigación muestra que los enfoques inspirados en el cerebro pueden reducir el consumo de energía hasta en un 97% para tareas computacionales específicas, manteniendo o mejorando el rendimiento en comparación con los sistemas de IA tradicionales.

¿Qué es SpikingBrain y cómo funciona?

SpikingBrain es un modelo de IA avanzado que implementa computación inspirada en el cerebro, omitiendo aproximadamente el 70% de los cálculos potenciales mientras genera respuestas más de 100 veces más rápido que los sistemas tradicionales para documentos largos.

Artículos relevantes sobre IA y tendencias tecnológicas

Mantente al día con las últimas ideas, herramientas e innovaciones que dan forma al futuro de la IA y la tecnología.

Grok AI: Generación Ilimitada de Videos Gratuita a partir de Texto e Imágenes | Guía 2024

Grok AI ofrece generación ilimitada de videos gratuita a partir de texto e imágenes, haciendo accesible la creación de videos profesionales para todos sin necesidad de habilidades de edición.

Las 3 mejores extensiones gratuitas de IA para programar en VS Code 2025 - Aumenta la productividad

Descubre las mejores extensiones gratuitas de agentes de IA para programar en Visual Studio Code en 2025, incluyendo Gemini Code Assist, Tabnine y Cline, para mejorar tu

Configuración de Grok 4 Fast en Janitor AI: Guía Completa de Juego de Roles Sin Filtros

Guía paso a paso para configurar Grok 4 Fast en Janitor AI para juego de roles sin restricciones, incluyendo configuración de API, ajustes de privacidad y consejos de optimización