Annotation

- Introducción

- Entendiendo los Flujos de Trabajo de LLM

- ¿Qué es un Flujo de Trabajo?

- Limitaciones de la Automatización Tradicional

- El Auge de los Flujos de Trabajo de LLM para una Automatización Mejorada

- Patrones de Diseño Comunes en Flujos de Trabajo de LLM

- Flujos Impulsados por Modelos de Lenguaje Grande

- Los Peligros de No Definir un Flujo de Trabajo Sólido

- Cómo Prevenir Altos Costos Computacionales

- Implementando Tu Propio Flujo de Trabajo de LLM

- Pros y Contras

- Conclusión

- Preguntas frecuentes

Dominio de los Flujos de Trabajo LLM: Guía de Automatización de IA e Implementación de Agentes

Dominar los flujos de trabajo LLM permite la automatización eficiente de tareas complejas utilizando agentes de IA, cubriendo patrones de diseño, implementación y costos

Introducción

Los flujos de trabajo de Modelos de Lenguaje Grande representan la siguiente evolución en automatización, transformando cómo las empresas manejan tareas complejas a través de sistemas de IA inteligentes. Al combinar procesos estructurados con las capacidades creativas de los LLM, las organizaciones pueden automatizar todo, desde el servicio al cliente hasta la creación de contenido, manteniendo flexibilidad y escalabilidad.

Entendiendo los Flujos de Trabajo de LLM

En esencia, los flujos de trabajo de LLM son procesos sistemáticos que aprovechan la inteligencia artificial para lograr objetivos específicos a través de una secuencia de pasos bien definidos. A diferencia de la automatización tradicional que depende de reglas rígidas, estos flujos de trabajo incorporan la comprensión contextual y las capacidades generativas de modelos de lenguaje avanzados.

¿Qué es un Flujo de Trabajo?

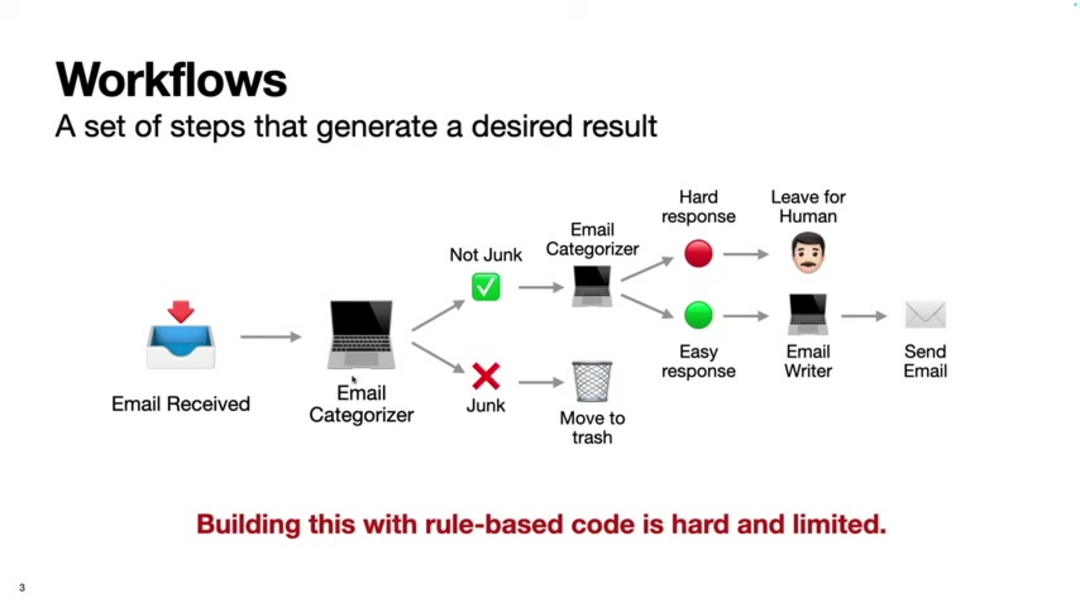

Un flujo de trabajo representa una serie estructurada de acciones diseñadas para lograr un resultado particular de manera eficiente. Cuando se define adecuadamente, los flujos de trabajo permiten resultados consistentes mientras permiten la optimización y automatización. La base de cualquier flujo de trabajo efectivo comienza con objetivos claros y progresa a través de pasos lógicos que pueden involucrar intervención humana, procesos automatizados o una combinación de ambos.

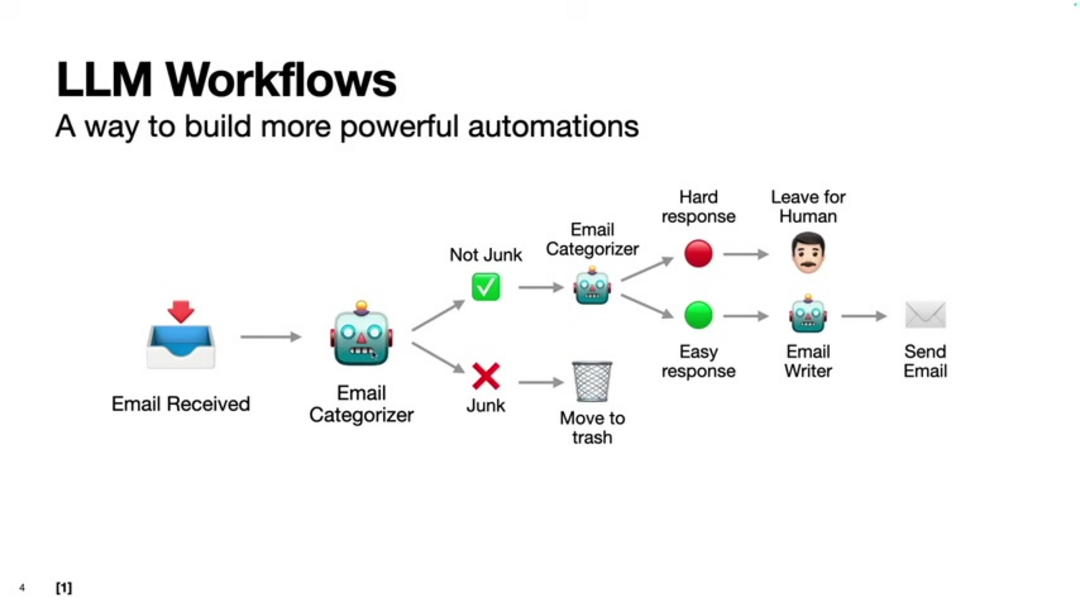

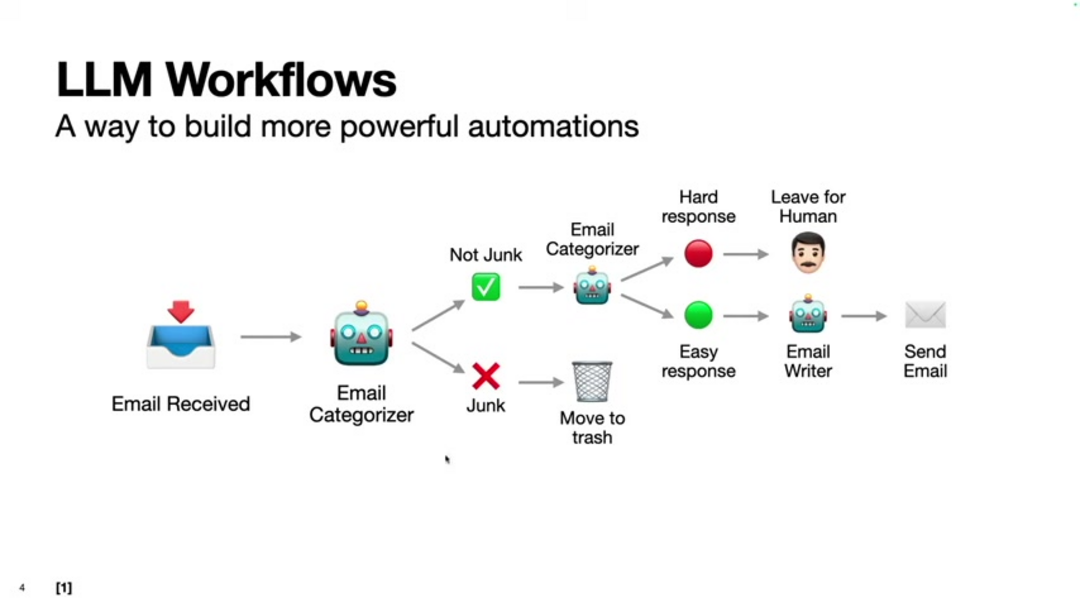

Considere el ejemplo de gestionar correos electrónicos entrantes: un flujo de trabajo básico podría involucrar recibir mensajes, analizar contenido, tomar decisiones de clasificación y realizar acciones apropiadas. Con asistentes de correo electrónico con IA, este proceso se automatiza manteniendo la conciencia contextual que carecen los sistemas tradicionales.

Las características clave de los flujos de trabajo efectivos incluyen orientación a objetivos, procesamiento secuencial y repetibilidad. Cada flujo de trabajo debe comenzar con objetivos claramente definidos, seguir pasos lógicos en el orden adecuado y producir resultados consistentes cuando se ejecuta múltiples veces. Este enfoque estructurado forma la base para implementar sistemas sofisticados de automatización con LLM.

Limitaciones de la Automatización Tradicional

Los sistemas de automatización convencionales a menudo luchan con flexibilidad y adaptabilidad debido a su naturaleza basada en reglas. Estos sistemas requieren programación explícita para cada escenario posible, lo que los hace difíciles de escalar y mantener a medida que aumenta la complejidad. Los enfoques tradicionales típicamente sobresalen con datos estructurados pero fallan cuando se enfrentan a información no estructurada como lenguaje natural o documentos complejos.

Los desafíos principales incluyen rigidez del sistema que impide la adaptación a condiciones cambiantes, problemas de escalabilidad a medida que crece la complejidad de los escenarios, incapacidad para procesar datos no estructurados efectivamente y altos costos de desarrollo y mantenimiento. Por ejemplo, un clasificador de correo electrónico basado en reglas podría identificar spam basado en palabras clave específicas, pero los spammers pueden eludir fácilmente estas reglas alterando sus tácticas.

El Auge de los Flujos de Trabajo de LLM para una Automatización Mejorada

Los Modelos de Lenguaje Grande han revolucionado la automatización al introducir sistemas que pueden entender contexto, procesar datos no estructurados y generar contenido creativo. Este avance tecnológico permite automatizar tareas previamente consideradas imposibles para sistemas tradicionales, abriendo nuevas posibilidades en varias industrias y aplicaciones.

Los flujos de trabajo de LLM proporcionan ventajas significativas incluyendo mayor flexibilidad para manejar diversos tipos de datos y condiciones cambiantes, escalabilidad mejorada para gestionar grandes volúmenes de información, capacidades creativas mejoradas para generación de contenido y costos de desarrollo reducidos a través de modelos preentrenados. Estos beneficios hacen que los flujos de trabajo de LLM sean particularmente valiosos para plataformas de automatización con IA que requieren tanto estructura como adaptabilidad.

Patrones de Diseño Comunes en Flujos de Trabajo de LLM

Han surgido varios patrones establecidos para estructurar flujos de trabajo de LLM efectivamente. Entender estos patrones ayuda a los desarrolladores a crear sistemas de IA robustos y escalables que pueden manejar tareas complejas eficientemente mientras mantienen control sobre el proceso de automatización.

Los patrones de diseño clave incluyen encadenar múltiples LLM en secuencia donde la salida de cada modelo alimenta al siguiente, enrutar tareas a agentes especializados basado en análisis de entrada, procesamiento paralelo donde múltiples LLM trabajan simultáneamente en subtareas, arquitecturas orquestador-trabajador que coordinan componentes de IA especializados y sistemas evaluador-optimizador que refinan salidas a través de mejora iterativa. Estos patrones forman la base para construir agentes y asistentes de IA sofisticados.

Flujos Impulsados por Modelos de Lenguaje Grande

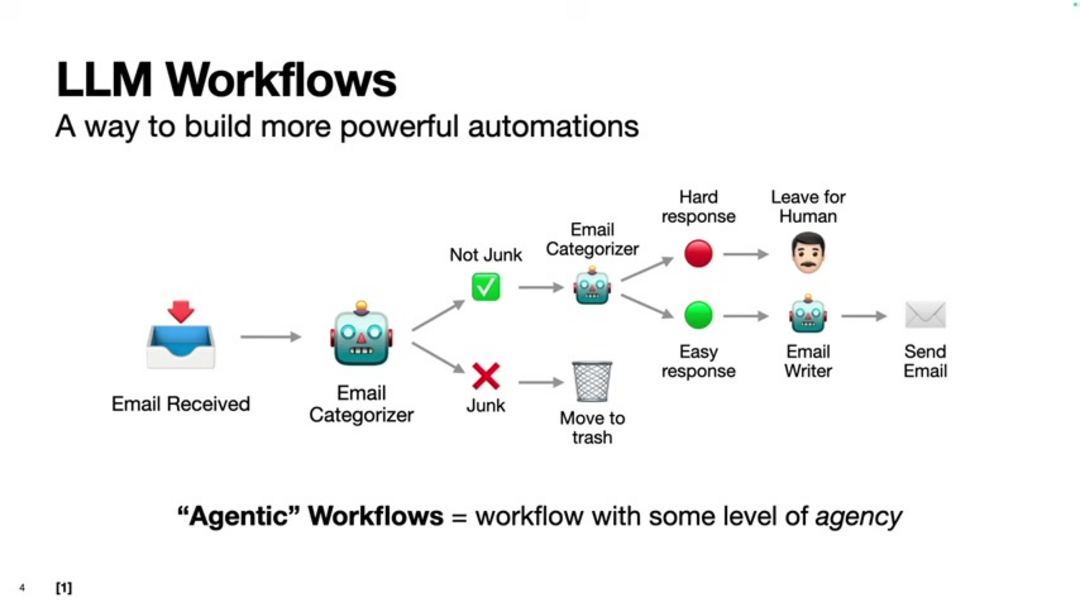

Los flujos impulsados por LLM representan un cambio de paradigma de flujos de trabajo predeterminados a sistemas dinámicos y conscientes del contexto. En lugar de seguir secuencias fijas, estos flujos permiten que la IA determine los siguientes pasos apropiados basados en análisis en tiempo real de la situación e información disponible.

Las ventajas principales incluyen adaptabilidad superior a condiciones cambiantes, conciencia contextual mejorada para decisiones más inteligentes y mayor flexibilidad en diversos escenarios. Dos patrones prominentes dentro de esta categoría son sistemas orquestador-trabajador donde un LLM central coordina trabajadores especializados y configuraciones evaluador-optimizador donde las salidas son continuamente evaluadas y refinadas. Estos enfoques son particularmente efectivos para herramientas de IA conversacional que requieren interacciones naturales y conscientes del contexto.

Los Peligros de No Definir un Flujo de Trabajo Sólido

Sin un diseño adecuado del flujo de trabajo, las implementaciones de LLM pueden volverse ineficientes y costosas. A medida que aumenta la complejidad del modelo, los requisitos computacionales crecen exponencialmente, haciendo que la planificación cuidadosa sea esencial para el despliegue práctico y la operación sostenible.

El diseño ineficiente del flujo de trabajo a menudo conduce a costos computacionales excesivos, particularmente al tratar con casos extremos o escenarios de cola larga. La planificación adecuada ayuda a identificar dónde el código tradicional, el aprendizaje automático o el prompting de LLM proporcionan la solución más eficiente para cada aspecto de un sistema.

Cómo Prevenir Altos Costos Computacionales

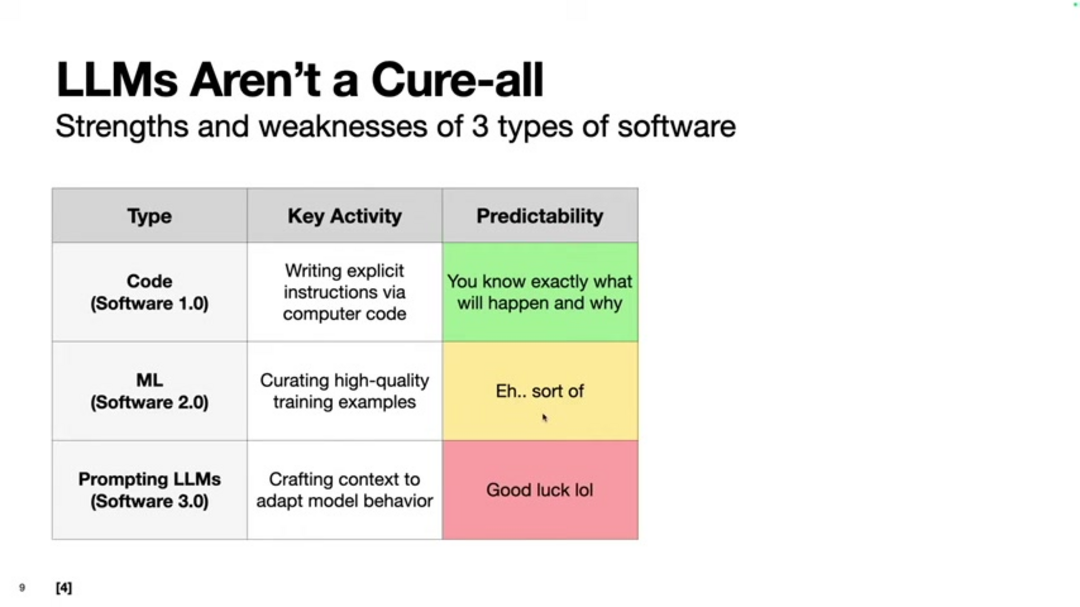

Entender las fortalezas y limitaciones de diferentes enfoques de software es crucial para una implementación de LLM rentable. El marco de Andrej Karpathy distingue entre código tradicional (Software 1.0), sistemas de aprendizaje automático (Software 2.0) y prompting de LLM (Software 3.0), cada uno con características distintas y casos de uso apropiados.

Al combinar estratégicamente estos enfoques, los desarrolladores pueden crear sistemas que aprovechen la predictibilidad del código tradicional donde sea apropiado mientras utilizan LLMs para tareas que requieren flexibilidad y creatividad. Este enfoque híbrido es fundamental para APIs y SDKs de IA efectivos que equilibran rendimiento con eficiencia computacional.

Implementando Tu Propio Flujo de Trabajo de LLM

Comenzar con la implementación de flujos de trabajo de LLM requiere la configuración adecuada del entorno y la comprensión de las herramientas disponibles. El SDK de Agente de OpenAI proporciona una base sólida para construir sistemas de IA sofisticados que puedan manejar tareas complejas a través de flujos de trabajo bien estructurados.

Los pasos esenciales de configuración incluyen instalar Python y las bibliotecas necesarias, obtener claves API para acceso a LLM, configurar variables de entorno de manera segura y crear archivos de instrucción que guíen el comportamiento del agente. Esta base permite a los desarrolladores construir desde scripts de automatización simples hasta sistemas complejos de chatbots con IA con capacidades de flujo de trabajo sofisticadas.

Pros y Contras

Ventajas

- Flexibilidad excepcional manejando datos no estructurados y condiciones cambiantes

- Escalabilidad fácil desde tareas pequeñas hasta aplicaciones a nivel empresarial

- Capacidades avanzadas de creación de contenido para marketing y comunicaciones

- Costos de desarrollo y mantenimiento reducidos en comparación con sistemas personalizados

- Comprensión contextual que mejora con más datos y uso

- Interfaz de lenguaje natural que requiere mínima experiencia técnica

- Mejora continua a través de actualizaciones de modelos y ajuste fino

Desventajas

- Imprevisibilidad de salida que desafía requisitos determinísticos

- Altos costos computacionales para modelos complejos y despliegue a gran escala

- Posible confusión con casos extremos y entradas ambiguas

- Control limitado sobre salidas específicas en comparación con programación tradicional

- Dependencia de la disponibilidad de API y posibles interrupciones de servicio

Conclusión

Los flujos de trabajo de LLM representan un enfoque transformador para la automatización que combina la estructura de los flujos de trabajo tradicionales con la flexibilidad e inteligencia de sistemas de IA avanzados. Al entender los patrones de diseño, estrategias de implementación y consideraciones de costos, las organizaciones pueden aprovechar estas tecnologías para automatizar tareas complejas mientras mantienen control y eficiencia. A medida que el campo continúa evolucionando, dominar los flujos de trabajo de LLM se volverá cada vez más esencial para las empresas que buscan ventaja competitiva a través de la automatización inteligente.

Preguntas frecuentes

¿Cuáles son los principales beneficios de utilizar flujos de trabajo LLM para la automatización?

Los flujos de trabajo LLM ofrecen una flexibilidad superior para manejar datos no estructurados, fácil escalabilidad, costos de desarrollo reducidos y comprensión contextual que la automatización tradicional carece, permitiendo sistemas más inteligentes y adaptables.

¿Cuál es la diferencia entre los flujos de trabajo en cadena y los flujos de trabajo impulsados por LLM?

Los flujos de trabajo en cadena utilizan secuencias predefinidas de LLM, mientras que los flujos de trabajo impulsados por LLM permiten una toma de decisiones dinámica donde la IA determina los siguientes pasos según el contexto, proporcionando mayor adaptabilidad y resiliencia.

¿Cómo empezar con el SDK de Agentes de OpenAI?

Comience instalando Python y el SDK de Agentes de OpenAI a través de pip, obtenga una clave API, configure variables de entorno y cree archivos de instrucciones para definir el comportamiento del agente y las herramientas para tareas específicas.

¿Cuáles son los casos de uso más comunes para los agentes de IA?

Los agentes de IA sobresalen en la resumen de correos electrónicos, creación automatizada de contenido, chatbots de servicio al cliente, gestión inteligente de tareas, análisis de datos y procesos complejos de toma de decisiones que requieren comprensión contextual.

¿Qué son el Software 1.0, 2.0 y 3.0 en el contexto de la IA?

El Software 1.0 se refiere al código tradicional, el 2.0 a los sistemas de aprendizaje automático y el 3.0 al prompting de LLM, cada uno ofreciendo diferentes enfoques para la automatización con flexibilidad y costos variables.

Artículos relevantes sobre IA y tendencias tecnológicas

Mantente al día con las últimas ideas, herramientas e innovaciones que dan forma al futuro de la IA y la tecnología.

Grok AI: Generación Ilimitada de Videos Gratuita a partir de Texto e Imágenes | Guía 2024

Grok AI ofrece generación ilimitada de videos gratuita a partir de texto e imágenes, haciendo accesible la creación de videos profesionales para todos sin necesidad de habilidades de edición.

Las 3 mejores extensiones gratuitas de IA para programar en VS Code 2025 - Aumenta la productividad

Descubre las mejores extensiones gratuitas de agentes de IA para programar en Visual Studio Code en 2025, incluyendo Gemini Code Assist, Tabnine y Cline, para mejorar tu

Configuración de Grok 4 Fast en Janitor AI: Guía Completa de Juego de Roles Sin Filtros

Guía paso a paso para configurar Grok 4 Fast en Janitor AI para juego de roles sin restricciones, incluyendo configuración de API, ajustes de privacidad y consejos de optimización