Annotation

- Introduction

- Comprendre les agents d'IA : Des LLM à l'action intelligente

- Grands modèles de langage : La fondation

- Flux de travail IA : Guider les LLM à travers des tâches spécifiques

- Agents d'IA : Résolveurs de problèmes autonomes et adaptatifs

- Génération augmentée par récupération (RAG)

- Parcours d'apprentissage pratique pour les agents d'IA

- Tarification des outils mentionnés

- Fonctionnalités principales des outils d'IA

- Cas d'utilisation pour les outils d'IA

- Avantages et inconvénients

- Conclusion

- Questions fréquemment posées

Guide des Agents IA : Des LLM à la Mise en Œuvre de Systèmes Autonomes

Explorez l'évolution des agents IA des LLM vers les systèmes autonomes, couvrant le cadre ReAct, la mise en œuvre de RAG et un chemin de développement pratique

Introduction

L'intelligence artificielle progresse à un rythme sans précédent, et les agents d'IA représentent la pointe de cette transformation. Ces systèmes intelligents vont au-delà des simples chatbots pour devenir des résolveurs de problèmes autonomes capables de raisonner, de s'adapter et d'exécuter des tâches complexes. Ce guide complet explore comment les agents d'IA s'appuient sur les grands modèles de langage et les flux de travail pour créer des systèmes véritablement intelligents qui peuvent révolutionner notre approche de l'automatisation et de la prise de décision dans tous les secteurs.

Comprendre les agents d'IA : Des LLM à l'action intelligente

Grands modèles de langage : La fondation

Au cœur des agents d'IA modernes se trouvent les grands modèles de langage (LLM) – des réseaux neuronaux sophistiqués entraînés sur d'immenses ensembles de données textuelles. Les exemples leaders incluent ChatGPT, Google Gemini et Claude, qui excellent dans la compréhension du langage naturel, la génération de texte et les tâches de raisonnement complexe. Ces modèles servent de moteur cognitif qui permet aux agents d'IA de traiter l'information et de communiquer efficacement.

Les LLM fournissent les capacités essentielles de traitement du langage qui permettent aux agents d'IA d'interpréter les demandes des utilisateurs, de générer des réponses et de comprendre le contexte. Cependant, ils fonctionnent principalement comme des systèmes réactifs – attendant des invites plutôt que d'initier des actions. Cette limitation devient apparente lorsqu'il s'agit de données propriétaires ou nécessitant une prise de décision en temps réel, c'est là que les agents et assistants d'IA plus avancés entrent en jeu.

Flux de travail IA : Guider les LLM à travers des tâches spécifiques

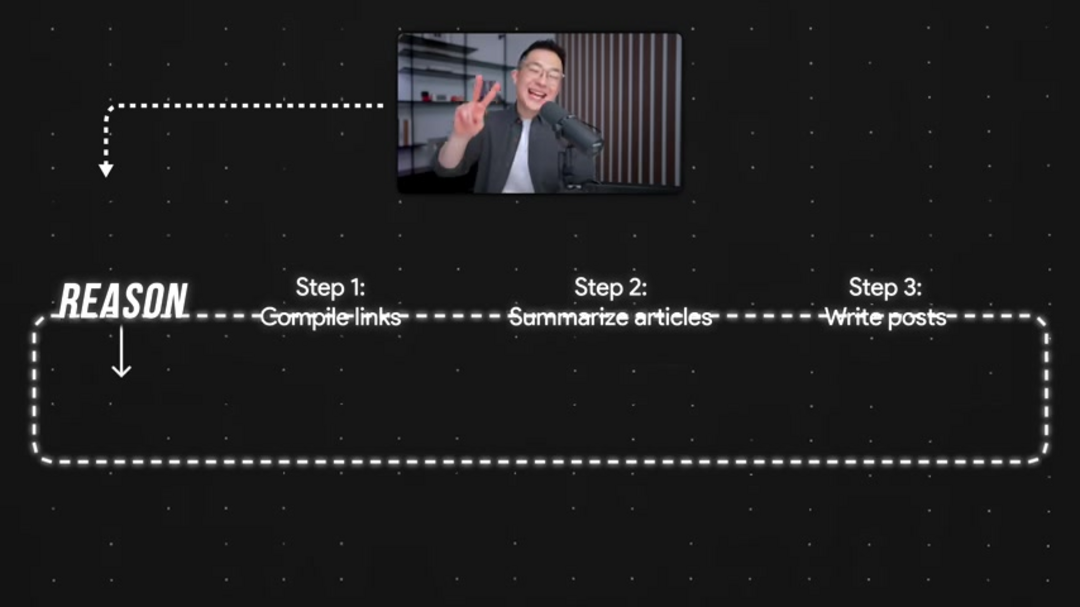

Les flux de travail IA représentent l'étape évolutive suivante, créant des séquences structurées qui guident les LLM à travers des processus multi-étapes. Ces flux de travail intègrent des outils externes et des sources de données, permettant une automatisation des tâches plus sophistiquée. Par exemple, un flux de travail de gestion des médias sociaux pourrait impliquer la compilation d'articles de presse, la synthèse de contenu à l'aide d'outils comme Perplexity AI, la rédaction de publications avec un LLM et la planification de la publication – le tout sans intervention manuelle.

Bien que les flux de travail améliorent considérablement les capacités d'automatisation, ils restent contraints par leurs chemins prédéfinis. Le programmeur humain doit spécifier chaque étape à l'avance, limitant la capacité du système à s'adapter à des situations inattendues ou à optimiser les processus dynamiquement. C'est là que les plateformes spécialisées dans les plateformes d'automatisation IA fournissent une infrastructure précieuse pour construire ces séquences complexes.

Agents d'IA : Résolveurs de problèmes autonomes et adaptatifs

Les agents d'IA représentent le summum de l'automatisation intelligente, combinant les capacités des LLM avec le raisonnement et l'action autonomes. Contrairement aux flux de travail qui suivent des étapes prédéterminées, les agents d'IA reçoivent des objectifs de haut niveau et déterminent indépendamment le chemin optimal pour les atteindre. Ils évaluent continuellement leur environnement, prennent des décisions basées sur des retours en temps réel et adaptent leurs stratégies au fur et à mesure que les circonstances changent.

Le cadre ReAct (Raisonnement + Action) illustre cette approche, permettant aux agents de raisonner itérativement sur les situations et de prendre des actions appropriées. Par exemple, un agent d'IA gérant les médias sociaux ne se contenterait pas de rédiger des publications – il analyserait les métriques d'engagement, identifierait les meilleures pratiques et affinerait sa stratégie de contenu de manière autonome. Ce niveau de sophistication rend les chatbots IA et les interfaces conversationnelles de plus en plus puissants pour les interactions clients.

Génération augmentée par récupération (RAG)

Qu'est-ce que le RAG ?

La Génération Augmentée par Récupération (RAG) aborde une limitation critique des LLM standards : leur incapacité à accéder à des informations actuelles ou propriétaires. Les systèmes RAG permettent aux modèles d'IA de récupérer des informations pertinentes à partir de bases de données externes ou de bases de connaissances avant de générer des réponses. Cette approche « regarder avant de répondre » garantit que les réponses sont fondées sur des informations précises et à jour plutôt que de reposer uniquement sur les données d'entraînement du modèle.

Le RAG fonctionne essentiellement comme un flux de travail IA spécialisé qui améliore la fiabilité et la précision des systèmes d'IA. En intégrant des mécanismes de récupération, les agents d'IA peuvent fournir des réponses plus pertinentes contextuellement et factuellement correctes, les rendant particulièrement précieux pour les applications nécessitant des informations actuelles ou des connaissances spécifiques à un domaine. Cette capacité est cruciale pour développer des outils d'IA conversationnelle avancés qui doivent maintenir une précision sur divers sujets.

Parcours d'apprentissage pratique pour les agents d'IA

Niveau 1 : Maîtriser les LLM

Commencez votre parcours en développant une compétence avec les LLM leaders comme ChatGPT, Google Gemini et Claude. Expérimentez avec différentes techniques d'invite pour comprendre comment des variations subtiles dans l'entrée affectent la qualité de la sortie. Apprenez à tirer parti de leurs capacités pour la génération de texte, la traduction, la synthèse et la génération de code. Cette connaissance fondamentale est essentielle avant de progresser vers des systèmes d'IA plus complexes et de comprendre comment les outils d'écriture IA optimisent la création de contenu.

Niveau 2 : Concevoir des flux de travail IA

Passez à la conception de séquences automatisées qui intègrent les LLM avec des outils externes et des sources de données. Des plateformes comme Make.com fournissent des interfaces intuitives pour créer des flux de travail multi-étapes qui combinent les capacités de l'IA avec des applications pratiques. Apprenez à structurer des processus qui tirent parti des différentes forces de l'IA tout en maintenant un flux logique et une gestion des erreurs – des compétences qui se traduisent directement dans le travail avec les outils d'invite IA et les cadres d'automatisation.

Niveau 3 : Construire des agents d'IA

Passez au développement de véritables agents d'IA en utilisant des cadres qui supportent le raisonnement et l'action autonomes. Explorez le cadre ReAct et d'autres architectures qui permettent aux systèmes de s'adapter à des conditions changeantes. Expérimentez avec différentes approches de fixation d'objectifs, de perception de l'environnement et de sélection d'actions. Ce niveau implique de comprendre comment déployer et gérer des solutions d'hébergement de modèles IA qui supportent la fonctionnalité des agents.

Tarification des outils mentionnés

Coût d'utilisation de ces outils d'IA

Comprendre les implications financières de la mise en œuvre de solutions d'IA est crucial pour la planification et la budgétisation. La plupart des outils d'IA fonctionnent sur des modèles de tarification basés sur l'utilisation, avec des coûts variant significativement en fonction du volume et des fonctionnalités requises. ChatGPT propose des abonnements échelonnés allant de l'accès gratuit aux plans entreprise, tandis que la tarification de Google Gemini s'intègre aux services de Google Cloud Platform. Claude utilise une facturation basée sur les jetons, et Perplexity AI offre à la fois des niveaux gratuit et premium. Make.com suit un modèle freemium similaire, avec des fonctionnalités d'automatisation avancées nécessitant des abonnements payants.

Fonctionnalités principales des outils d'IA

Fonctions principales

Chaque outil d'IA apporte des capacités distinctes. ChatGPT excelle dans la génération de texte, la traduction et la création de code. Google Gemini se distingue par le traitement multimodal du texte et des images. Claude se concentre sur l'IA conversationnelle et les tâches de synthèse. Perplexity AI se spécialise dans la récupération d'informations en temps réel et les réponses améliorées par la recherche. Make.com sert de plateforme d'automatisation connectant diverses applications et services. Comprendre ces fonctions spécialisées aide à sélectionner les bons outils pour des projets d'intégration spécifiques d'API et SDK d'IA.

Cas d'utilisation pour les outils d'IA

Applications typiques

Les agents d'IA et leurs technologies sous-jacentes trouvent des applications dans de nombreux domaines. La création de contenu bénéficie de publications de blog et de matériels marketing automatisés. Le service client se transforme grâce à des chatbots intelligents et des assistants virtuels. L'analyse de données devient plus accessible avec la génération automatisée d'insights. Le développement logiciel s'accélère grâce à la génération et l'optimisation de code. Les processus de recherche se rationalisent avec des capacités améliorées de récupération et de synthèse d'informations. Ces applications démontrent le potentiel transformateur de l'IA à travers les fonctions commerciales et les industries.

Avantages et inconvénients

Avantages

- Automatise des tâches multi-étapes complexes nécessitant du raisonnement

- Améliore significativement l'efficacité opérationnelle et la productivité

- Permet une prise de décision basée sur les données avec adaptation en temps réel

- Crée des expériences utilisateur et des interactions hautement personnalisées

- Résout des problèmes nouveaux sans solutions pré-programmées

- Réduit l'erreur humaine dans les tâches cognitives répétitives

- Évolutif à travers de multiples domaines et applications

Inconvénients

- Coûts de développement et de mise en œuvre élevés initialement

- Préoccupations éthiques concernant les biais, la transparence et l'impact sur l'emploi

- Nécessite des ensembles de données d'entraînement étendus et de haute qualité

- Intégration complexe avec les systèmes et flux de travail existants

- Vulnérabilités potentielles de sécurité dans les systèmes autonomes

Conclusion

Les agents d'IA représentent une avancée majeure dans l'IA, évoluant de systèmes réactifs à des résolveurs de problèmes autonomes. Construits sur de grands modèles de langage avec un raisonnement avancé, ils s'adaptent à des environnements dynamiques et atteignent des objectifs complexes avec un minimum d'intervention humaine. À mesure que la technologie mûrit, les agents d'IA géreront des tâches plus nuancées de manière intelligente. Comprendre les LLM et progresser à travers les concepts fondamentaux est clé pour tirer parti du potentiel de l'IA.

Questions fréquemment posées

Que sont les agents IA et comment fonctionnent-ils ?

Les agents IA sont des systèmes autonomes qui perçoivent leur environnement, raisonnent sur les situations et prennent des mesures pour atteindre des objectifs spécifiques. Ils combinent de grands modèles de langage avec des capacités de prise de décision pour résoudre des problèmes de manière adaptative sans suivre des étapes préprogrammées.

En quoi les agents IA diffèrent-ils des chatbots standard ?

Alors que les chatbots suivent généralement des conversations scriptées, les agents IA peuvent déterminer de manière autonome des actions, s'adapter à de nouvelles informations et poursuivre des objectifs complexes grâce au raisonnement et à l'amélioration itérative plutôt que de simplement répondre à des invites immédiates.

Qu'est-ce que le cadre ReAct dans les agents IA ?

Le cadre ReAct combine le Raisonnement et l'Action, permettant aux agents IA de réfléchir de manière itérative aux problèmes, de planifier des actions, de les exécuter et d'affiner les approches en fonction des résultats pour une résolution de problèmes plus efficace.

Comment RAG améliore-t-il les capacités des agents IA ?

La Génération Augmentée par Récupération permet aux agents IA d'accéder à des sources de connaissances externes avant de répondre, garantissant que les réponses sont basées sur des informations actuelles et précises plutôt que sur des données pré-entraînées, améliorant considérablement la fiabilité.

Quelles sont les applications courantes dans le monde réel des agents IA ?

Les agents IA alimentent les assistants virtuels, les véhicules autonomes, les systèmes de détection de fraude, l'automatisation des processus robotiques, les moteurs de recommandation personnalisés et les applications de résolution de problèmes complexes dans les domaines de la santé, de la finance et du service client.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre