Annotation

- Introduction

- Le coût environnemental caché de l'IA moderne

- Consommation de ressources non durable

- Mise à l'échelle quadratique : le goulot d'étranglement architectural

- Apprendre du maître ordinateur de la nature

- Le plan d'efficacité du cerveau humain

- Pseudo-impulsions : faire le lien entre biologie et technologie

- Techniques de codage par impulsions avancées

- SpikingBrain : démonstration pratique de l'efficacité

- Implications économiques et d'accessibilité

- Avantages et inconvénients

- Applications étendues à travers les industries

- Conclusion

- Questions fréquemment posées

IA Inspirée du Cerveau : Révolution du Calcul Durable pour l'Efficacité Énergétique

Les modèles d'IA inspirés du cerveau imitent l'efficacité du cerveau humain pour réduire la consommation d'énergie jusqu'à 97% avec des réseaux de neurones à impulsions, permettant une informatique durable et

Introduction

L'intelligence artificielle a atteint des capacités remarquables, de la génération de contenu créatif à la résolution de problèmes complexes, mais ces avancées s'accompagnent d'un coût environnemental non durable. Les systèmes d'IA actuels consomment des quantités d'énergie stupéfiantes, menaçant de freiner le progrès technologique. Cette exploration révèle comment l'informatique inspirée du cerveau offre une voie durable, s'inspirant du modèle de calcul le plus efficace de la nature pour créer une IA à la fois puissante et respectueuse de l'environnement.

Le coût environnemental caché de l'IA moderne

Consommation de ressources non durable

Bien que les modèles d'IA démontrent des capacités impressionnantes en codage, création artistique et dialogue sophistiqué, ces réalisations masquent une crise de durabilité critique. L'architecture de transformateur, qui a permis la révolution actuelle de l'IA, contient des défauts de conception fondamentaux qui la rendent exceptionnellement gourmande en ressources. L'entraînement de grands modèles linguistiques comme GPT-3 consomme une énergie équivalente à l'utilisation annuelle de plusieurs ménages, soulevant de sérieuses préoccupations environnementales concernant la mise à l'échelle continue des modèles.

Les demandes de ressources vont au-delà de l'énergie pour inclure la puissance de calcul, les besoins de refroidissement et le matériel spécialisé. À mesure que les modèles deviennent plus grands et plus complexes, ces exigences augmentent de façon exponentielle, créant des barrières à l'entrée pour les petites organisations et les chercheurs. Cette concentration des capacités d'IA menace la diversité et l'accessibilité de l'innovation dans le paysage technologique, rendant les plateformes d'automatisation IA efficaces de plus en plus précieuses.

Mise à l'échelle quadratique : le goulot d'étranglement architectural

La limitation fondamentale de l'architecture de transformateur réside dans la mise à l'échelle quadratique, où les coûts de calcul augmentent de façon quadratique avec la longueur de la séquence d'entrée. Lors du traitement d'un document, doubler sa longueur quadruple les exigences de calcul plutôt que de simplement les doubler. Cette croissance exponentielle des coûts crée des obstacles significatifs pour les applications nécessitant une compréhension de contexte long, comme l'analyse de documents juridiques, le traitement de dossiers médicaux ou l'analyse littéraire.

L'explication technique implique que le mécanisme d'attention nécessite de comparer chaque mot avec tous les autres mots d'une séquence. À mesure que la longueur de la séquence augmente, le nombre de comparaisons croît à un rythme non durable. Cette contrainte architecturale oblige soit à accepter des limitations de performance, soit à investir dans une infrastructure informatique de plus en plus puissante, augmentant les coûts économiques et environnementaux pour les organisations mettant en œuvre des API et SDK d'IA.

Apprendre du maître ordinateur de la nature

Le plan d'efficacité du cerveau humain

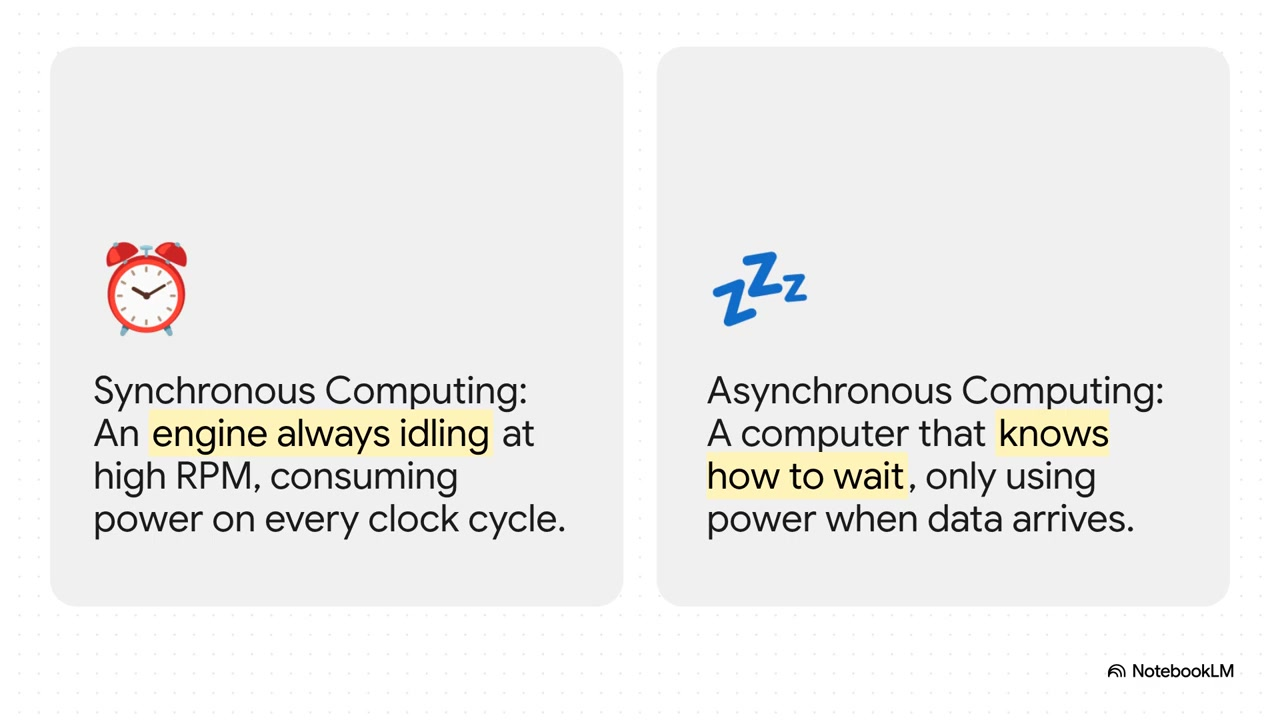

Le cerveau humain représente la référence en matière d'efficacité computationnelle, effectuant des tâches cognitives complexes tout en consommant seulement environ 20 watts d'énergie – moins qu'une ampoule standard. Cette efficacité remarquable résulte de millions d'années d'optimisation évolutive, offrant des leçons précieuses pour la conception de systèmes d'IA. Contrairement aux ordinateurs conventionnels qui maintiennent des niveaux d'activité constants, le cerveau fonctionne sur un principe événementiel où les neurones s'activent uniquement lorsque nécessaire.

Ce modèle d'activation éparse contraste fortement avec les approches traditionnelles de l'IA, où tous les composants calculent continuellement indépendamment de la pertinence. Le secret du cerveau ne réside pas dans un calcul plus rapide mais dans l'évitement stratégique du calcul – ne traitant que les informations essentielles lorsque nécessaire. Cette inspiration biologique motive la recherche sur les architectures de calcul neuromorphiques qui pourraient révolutionner notre approche de l'hébergement de modèles d'IA et du déploiement.

Pseudo-impulsions : faire le lien entre biologie et technologie

Les techniques de pseudo-impulsions représentent un compromis pratique entre la précision biologique et la faisabilité computationnelle. Plutôt que de reproduire parfaitement le comportement neural sur du matériel conventionnel, ces méthodes approximent les modèles de calcul épars et événementiels du cerveau. Cette approche permet des économies d'énergie significatives tout en maintenant la compatibilité avec l'infrastructure GPU existante, offrant des avantages de mise en œuvre immédiate sans nécessiter de puces neuromorphiques spécialisées.

Bien que certains critiques affirment que la pseudo-impulsions ne fait que remballer les techniques existantes de multiplication matricielle, les bénéfices pratiques démontrent sa valeur en tant que technologie de transition. En permettant à l'innovation logicielle de progresser indépendamment du développement matériel, la pseudo-impulsions accélère l'adoption de paradigmes de calcul efficaces. Cette approche bénéficie particulièrement aux développeurs travaillant avec des agents et assistants d'IA qui nécessitent un fonctionnement continu.

Techniques de codage par impulsions avancées

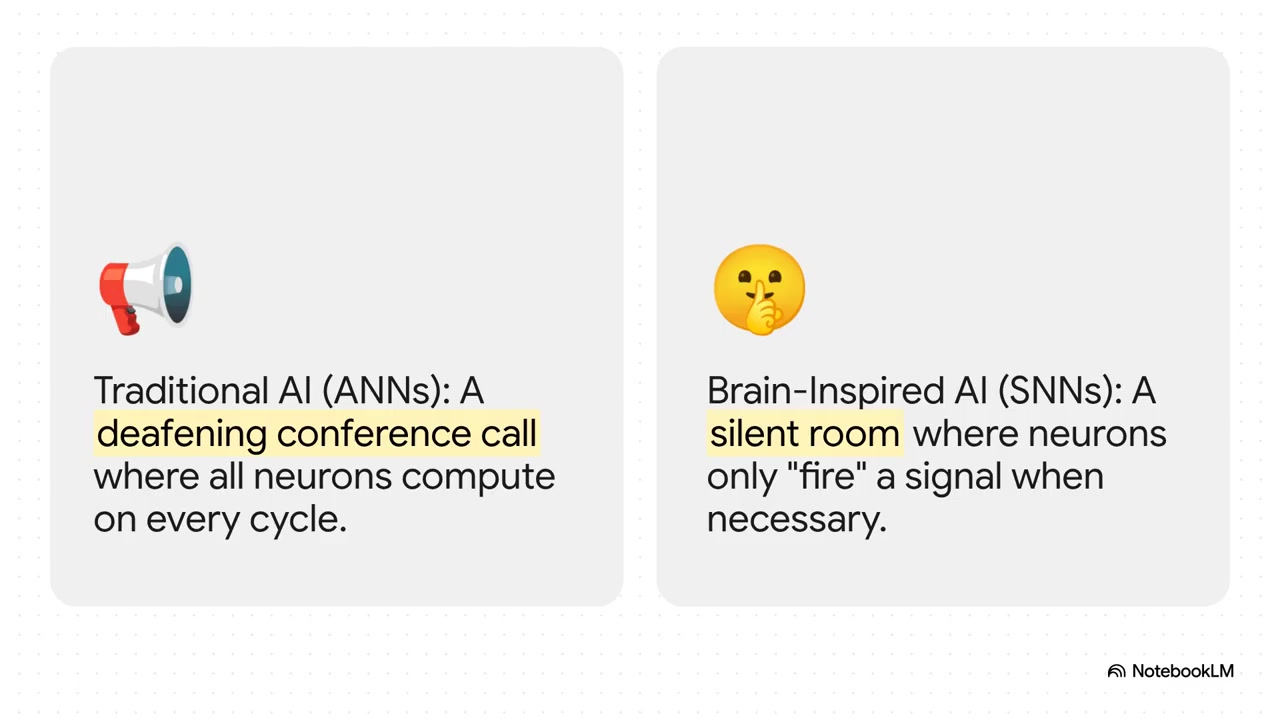

Les réseaux de neurones à impulsions emploient diverses stratégies de codage pour optimiser l'efficacité de la transmission d'information. Le codage binaire par impulsions représente l'approche la plus simple, utilisant des modèles d'activation denses pour transmettre l'information dans le temps. Bien que simple à mettre en œuvre, cette méthode s'avère relativement inefficace par rapport à des alternatives plus sophistiquées qui imitent mieux la communication neurale biologique.

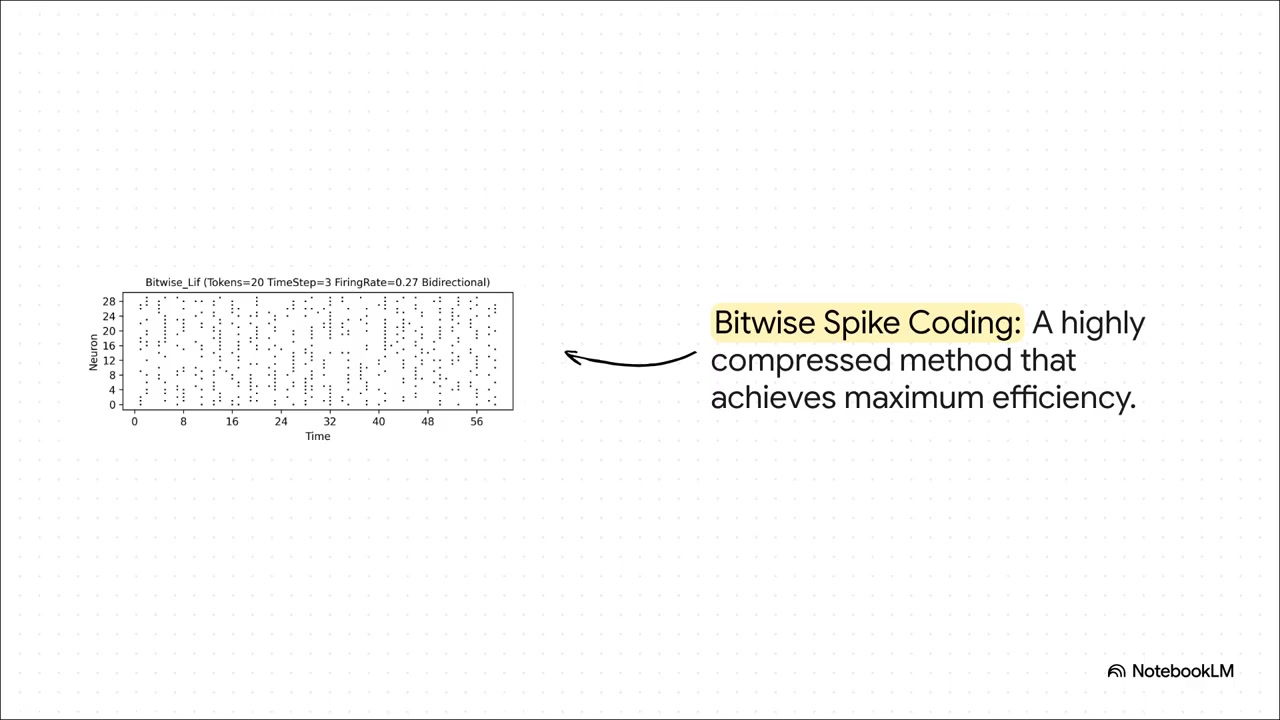

Le codage ternaire introduit des signaux inhibiteurs aux côtés des signaux excitateurs, permettant une représentation de l'information plus nuancée avec des modèles d'activation plus épars. Cette approche permet aux circuits neuronaux d'effectuer des opérations de soustraction en plus de l'addition, créant des capacités computationnelles plus sophistiquées. Le codage bit à bit représente la technique la plus avancée, atteignant une efficacité maximale grâce à des modèles d'impulsions hautement compressés qui contiennent des informations substantielles dans une activité neurale minimale.

SpikingBrain : démonstration pratique de l'efficacité

Le modèle SpikingBrain illustre le potentiel pratique de l'informatique inspirée du cerveau, atteignant des gains d'efficacité remarquables grâce à l'omission stratégique de calculs. Les résultats expérimentaux démontrent que SpikingBrain évite environ 70 % des calculs potentiels tout en maintenant des niveaux de performance compétitifs. Plus impressionnant encore, le modèle génère sa sortie initiale plus de 100 fois plus rapidement que les systèmes traditionnels lors du traitement de documents longs.

Cette performance remet en question la sagesse conventionnelle selon laquelle les améliorations d'efficacité compromettent nécessairement l'intelligence ou la précision. SpikingBrain démontre qu'une conception architecturale soignée peut offrir à la fois vitesse et fiabilité, répondant aux préoccupations concernant le compromis intelligence-vitesse qui affecte souvent les systèmes optimisés. De telles avancées pourraient avoir un impact significatif sur les applications nécessitant une optimisation du système et un traitement en temps réel.

Implications économiques et d'accessibilité

Au-delà des bénéfices environnementaux, l'informatique inspirée du cerveau promet des avantages économiques substantiels en réduisant les ressources computationnelles requises pour le déploiement de l'IA. Une consommation d'énergie réduite se traduit directement par des coûts opérationnels réduits, rendant les capacités avancées d'IA accessibles aux petites organisations et aux chercheurs individuels. Ce potentiel de démocratisation pourrait libérer des vagues d'innovation alors que des perspectives plus diverses contribuent au développement de l'IA.

Les estimations de réduction d'énergie atteignent 97 % pour des tâches computationnelles spécifiques, transformant potentiellement l'IA d'une technologie exclusive et gourmande en ressources en un outil largement accessible. Ce changement pourrait décentraliser le développement de l'IA, réduisant la dépendance aux grandes entreprises technologiques et favorisant des écosystèmes d'innovation plus diversifiés. De tels développements s'alignent bien avec les outils axés sur la gestion de l'alimentation et l'optimisation de l'efficacité.

Avantages et inconvénients

Avantages

- Réduction drastique de la consommation d'énergie et de l'impact environnemental

- Accessibilité accrue grâce à des exigences matérielles réduites

- Potentiel de performance supérieure sur des tâches cognitives complexes

- Compatibilité avec les plateformes matérielles neuromorphiques émergentes

- Temps de réponse plus rapides pour les applications en temps réel

- Coûts opérationnels réduits pour les services d'IA continus

- Fondation pour des systèmes d'IA plus biologiquement plausibles

Inconvénients

- Complexité de mise en œuvre nécessitant une expertise spécialisée

- Limitations matérielles actuelles limitant les gains d'efficacité potentiels

- Comportements imprévisibles dans certaines configurations

- Cycles de développement plus longs par rapport aux approches traditionnelles

- Ressources de support communautaire et d'outillage limitées

Applications étendues à travers les industries

Les technologies d'IA efficaces promettent des impacts transformateurs dans de multiples secteurs en permettant le déploiement dans des environnements à ressources limitées. La santé pourrait voir des outils de diagnostic alimentés par l'IA atteindre des zones reculées avec une infrastructure électrique limitée. Les sciences environnementales pourraient tirer parti de la modélisation climatique efficace fournissant des prédictions précises sans exigences computationnelles excessives.

Les domaines d'application supplémentaires incluent l'analyse financière, les outils éducatifs, l'optimisation de la fabrication et les systèmes de transport – tous bénéficiant de coûts opérationnels réduits et d'une flexibilité de déploiement accrue. Ces avancées pourraient fonctionner en synergie avec les outils de benchmarking système pour mesurer avec précision les améliorations d'efficacité.

Conclusion

L'informatique inspirée du cerveau représente un changement de paradigme dans le développement de l'intelligence artificielle, abordant les défis de durabilité critiques auxquels sont confrontées les approches actuelles. En s'inspirant de l'efficacité exceptionnelle du cerveau humain, les chercheurs créent des systèmes d'IA qui offrent des capacités puissantes sans consommation excessive de ressources. Bien que des défis de mise en œuvre subsistent, les bénéfices démontrés de modèles comme SpikingBrain confirment le potentiel pratique de cette approche. À mesure que le domaine progresse, l'IA inspirée du cerveau promet de rendre l'intelligence artificielle plus accessible, durable et capable – créant finalement une technologie qui sert l'humanité sans compromettre notre avenir environnemental.

Questions fréquemment posées

Quel est le principal problème des systèmes d'IA actuels ?

Les systèmes d'IA actuels consomment des quantités non durables d'énergie et de ressources informatiques, la formation de grands modèles utilisant une énergie équivalente à celle de plusieurs ménages annuellement. Cet impact environnemental menace la poursuite des progrès de l'IA et son accessibilité.

Quelle est l'efficacité du cerveau humain par rapport à l'IA ?

Le cerveau humain effectue des calculs complexes en utilisant seulement environ 20 watts de puissance – moins qu'une ampoule standard – tandis que les systèmes d'IA actuels nécessitent des ordres de grandeur plus d'énergie pour des tâches similaires.

Que sont les réseaux de neurones à impulsions ?

Les réseaux de neurones à impulsions imitent le calcul piloté par événements du cerveau, où les neurones artificiels s'activent uniquement lorsque nécessaire plutôt que de calculer en continu. Ce modèle d'activation éparse réduit considérablement la consommation d'énergie.

Combien d'énergie l'IA inspirée du cerveau peut-elle économiser ?

La recherche montre que les approches inspirées du cerveau peuvent réduire la consommation d'énergie jusqu'à 97% pour des tâches de calcul spécifiques tout en maintenant ou en améliorant les performances par rapport aux systèmes d'IA traditionnels.

Qu'est-ce que SpikingBrain et comment fonctionne-t-il ?

SpikingBrain est un modèle d'IA avancé qui met en œuvre le calcul inspiré du cerveau, sautant environ 70% des calculs potentiels tout en générant des réponses plus de 100 fois plus rapides que les systèmes traditionnels pour les documents longs.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation