Annotation

- Introduction

- Comprendre la reconnaissance d'images et la vision par ordinateur

- Qu'est-ce que la vision par ordinateur ?

- Applications clés de la vision par ordinateur

- Une brève histoire de la recherche en vision par ordinateur

- Le rôle de l'apprentissage profond dans la reconnaissance d'images

- Apprentissage profond et réseaux neuronaux

- Avantages et inconvénients

- Stratégies de mise en œuvre et bonnes pratiques

- Conclusion

- Questions fréquemment posées

Apache Spark Apprentissage Profond pour la Reconnaissance d'Images : Guide d'IA Évolutive

Découvrez comment Apache Spark et l'apprentissage profond permettent une reconnaissance d'images évolutive avec les CNN, le calcul distribué et les meilleures pratiques pour les systèmes d'IA.

Introduction

La technologie de reconnaissance d'images a transformé la manière dont les ordinateurs interprètent les données visuelles, permettant des avancées dans divers secteurs, du diagnostic médical à la navigation des véhicules autonomes. Ce guide complet explore comment les capacités de calcul distribué d'Apache Spark se combinent avec les frameworks d'apprentissage profond pour créer des systèmes de reconnaissance d'images évolutifs et efficaces. Nous examinerons l'évolution de la vision par ordinateur, plongerons dans les architectures de réseaux neuronaux convolutifs et démontrerons des stratégies de mise en œuvre pratiques pour construire des modèles de classification d'images robustes capables de gérer des ensembles de données massifs avec des performances de niveau entreprise.

Comprendre la reconnaissance d'images et la vision par ordinateur

Qu'est-ce que la vision par ordinateur ?

La vision par ordinateur représente une branche sophistiquée de l'intelligence artificielle qui permet aux machines d'interpréter et de comprendre les informations visuelles du monde qui nous entoure. Contrairement au simple traitement d'image, les systèmes de vision par ordinateur extraient des insights significatifs des données visuelles, permettant des applications allant de l'analyse d'images médicales au contrôle qualité industriel. Le domaine combine des techniques d'apprentissage automatique, de reconnaissance de formes et de traitement numérique du signal pour reproduire les capacités visuelles humaines.

La reconnaissance d'images se concentre spécifiquement sur l'identification et la catégorisation d'objets, de motifs et de caractéristiques dans les images numériques. Cette technologie a évolué de la simple correspondance de modèles à des réseaux neuronaux complexes capables de comprendre le contexte et les relations entre les éléments visuels. Les systèmes modernes peuvent distinguer des milliers de catégories d'objets avec des taux de précision dépassant les capacités humaines dans des domaines spécifiques.

Applications clés de la vision par ordinateur

- Détection et reconnaissance faciale : Systèmes biométriques avancés qui identifient les individus en temps réel, utilisés dans le contrôle d'accès sécurisé et les plateformes de médias sociaux pour l'étiquetage automatique.

- Détection d'objets : Essentielle pour les véhicules autonomes afin d'identifier les piétons, les panneaux de signalisation et autres véhicules, permettant une navigation sûre dans des environnements complexes.

- Légendage d'images : Systèmes d'IA qui génèrent du texte descriptif pour les images, offrant une accessibilité aux utilisateurs malvoyants et une analyse automatisée du contenu.

- Réalité augmentée : Technologie qui superpose des informations numériques sur des vues du monde réel, révolutionnant les applications de jeu, de vente au détail et de maintenance industrielle.

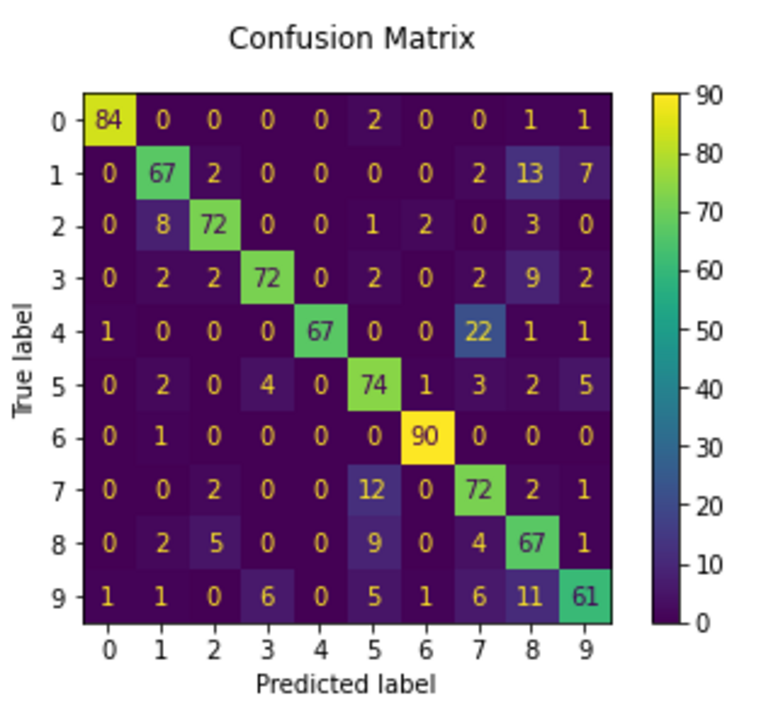

- Reconnaissance de chiffres manuscrits : Systèmes qui convertissent les chiffres manuscrits en format numérique, essentiels pour le traitement des chèques bancaires et l'automatisation des services postaux.

Ces applications démontrent le potentiel transformateur de la vision par ordinateur dans de multiples secteurs, de nombreuses entreprises exploitant les plateformes d'automatisation IA pour intégrer ces capacités dans leurs flux de travail.

| Tâche | Description | Exemple |

|---|---|---|

| Classification | Catégoriser des images entières dans des classes prédéfinies | Identifier des images médicales comme normales ou anormales |

| Localisation | Déterminer les positions des objets dans les images | Localiser précisément les tumeurs dans les scanners médicaux |

| Détection d'objets | Identifier plusieurs objets et leurs positions | Détecter simultanément les véhicules, les piétons et les panneaux de signalisation |

| Segmentation d'instances | Identification au niveau des pixels des limites des objets | Délimitation précise des objets individuels pour la manipulation robotique |

Une brève histoire de la recherche en vision par ordinateur

Les fondements de la vision par ordinateur moderne remontent aux recherches pionnières en neurosciences dans les années 1950. Les travaux révolutionnaires de David Hubel et Torsten Wiesel sur le cortex visuel du chat ont révélé comment les neurones répondent à des motifs visuels spécifiques, établissant le principe de traitement hiérarchique qui sous-tend les réseaux neuronaux contemporains. Leur découverte des cellules simples et complexes a fourni l'inspiration biologique pour les mécanismes d'extraction de caractéristiques dans les systèmes artificiels.

Les premiers systèmes de vision par ordinateur reposaient sur des algorithmes d'extraction de caractéristiques artisanaux qui identifiaient les bords, les coins et les textures. Bien qu'efficaces pour des environnements contraints, ces méthodes luttaient avec la variabilité et la complexité du monde réel. La percée est venue avec l'émergence de l'apprentissage profond dans les années 2010, qui a permis l'apprentissage automatique des caractéristiques directement à partir des données. Ce changement de paradigme a éliminé le besoin d'ingénierie manuelle des caractéristiques et a considérablement amélioré les performances des systèmes dans diverses tâches de reconnaissance visuelle.

Le rôle de l'apprentissage profond dans la reconnaissance d'images

Apprentissage profond et réseaux neuronaux

L'apprentissage profond représente une approche révolutionnaire de l'apprentissage automatique qui utilise des réseaux neuronaux multicouches pour traiter les données à travers des représentations de plus en plus abstraites. Ces réseaux neuronaux artificiels imitent les structures cérébrales biologiques, avec des nœuds interconnectés traitant l'information via des connexions pondérées. La profondeur de ces réseaux leur permet d'apprendre des modèles hiérarchiques complexes que des modèles plus simples ne peuvent pas capturer.

Les composants architecturaux clés incluent :

- Couches du réseau : Unités de traitement empilées qui transforment les données d'entrée via des paramètres appris et des fonctions d'activation

- Connexions pondérées : Relations mathématiques entre les neurones qui sont optimisées pendant l'entraînement

- Fonctions d'activation : Transformations non linéaires qui permettent aux réseaux d'apprendre des modèles complexes, ReLU étant la norme contemporaine

- Rétropropagation : L'algorithme d'apprentissage qui ajuste les poids du réseau en fonction des erreurs de prédiction

Les réseaux neuronaux convolutifs (CNN) représentent l'architecture dominante pour les tâches de reconnaissance d'images. Leur conception spécialisée traite efficacement les données spatiales via des opérations de convolution qui préservent les relations spatiales tout en apprenant des représentations hiérarchiques des caractéristiques. De nombreux développeurs utilisent les API et SDK d'IA pour intégrer ces capacités dans leurs applications sans construire des modèles à partir de zéro.

| Composant | Fonction | Impact |

|---|---|---|

| Couche convolutive | Applique des filtres apprenables pour extraire des caractéristiques spatiales | Détecte des motifs comme les bords, les textures et les formes |

| Couche de pooling | Réduit les dimensions spatiales tout en préservant les caractéristiques | Améliore l'efficacité computationnelle et l'invariance à la translation |

| Fonction d'activation | Introduit la non-linéarité pour permettre un apprentissage complexe | Permet aux réseaux de modéliser des relations complexes |

| Couches entièrement connectées | Effectue la classification finale basée sur les caractéristiques apprises | Mappe les caractéristiques extraites aux catégories de sortie |

Les CNN ont largement remplacé les réseaux feed-forward traditionnels pour le traitement d'image en raison de plusieurs avantages critiques. Le partage de paramètres via les filtres convolutifs réduit considérablement les exigences computationnelles tout en maintenant la capacité de modélisation. La hiérarchie spatiale permet d'apprendre des bords simples aux représentations complexes d'objets, et leur invariance à la translation assure des performances robustes indépendamment du positionnement des objets dans les images. Pour les organisations ayant besoin de déployer ces modèles à grande échelle, les services d'hébergement de modèles d'IA fournissent l'infrastructure nécessaire.

Avantages et inconvénients

Avantages

- Évolutivité massive pour traiter d'énormes ensembles de données d'images à travers des clusters

- Le calcul en mémoire accélère considérablement les flux de travail itératifs d'apprentissage profond

- La tolérance aux pannes intégrée assure un traitement fiable des travaux de longue durée

- Intégration transparente avec les bibliothèques et frameworks populaires d'apprentissage automatique

- Plateforme unifiée pour le prétraitement des données, l'entraînement des modèles et le déploiement

- Le traitement distribué efficace réduit le temps d'entraînement pour les grands modèles

- Écosystème robuste avec un support communautaire étendu et une documentation

Inconvénients

- Complexité significative dans la configuration des clusters et le réglage des performances

- Surcharge substantielle due à la coordination des systèmes distribués et au brassage des données

- Courbe d'apprentissage abrupte pour maîtriser les API de Spark et les concepts distribués

- Défis de gestion de la mémoire avec les charges de travail de traitement d'image à grande échelle

- Le débogage des applications distribuées nécessite des compétences et des outils spécialisés

Stratégies de mise en œuvre et bonnes pratiques

La mise en œuvre réussie de la reconnaissance d'images avec Apache Spark nécessite une attention particulière à la conception du pipeline de données et à l'architecture du modèle. La nature distribuée de Spark permet le traitement de collections massives d'images qui submergeraient les systèmes à machine unique. La mise en œuvre pratique implique typiquement le chargement distribué des données, l'extraction parallèle des caractéristiques et l'entraînement synchronisé des modèles à travers les nœuds de travail.

Les considérations clés de mise en œuvre incluent des stratégies de partitionnement des données qui équilibrent la charge computationnelle tout en minimisant le transfert réseau, la sérialisation efficace des données d'image pour réduire la surcharge de stockage, et la gestion attentive des ressources GPU dans les clusters hétérogènes. De nombreuses équipes complètent leurs flux de travail Spark avec des outils d'édition photo spécialisés pour l'augmentation et le prétraitement des données.

Pour les applications réelles, l'intégration avec les logiciels de capture d'écran peut fournir des flux continus de données d'entraînement, tandis que les générateurs d'images IA peuvent créer des données synthétiques pour améliorer la robustesse du modèle. La surveillance et l'optimisation doivent se concentrer à la fois sur les performances algorithmiques et l'utilisation des ressources pour assurer un fonctionnement rentable à l'échelle.

Conclusion

La combinaison d'Apache Spark et de l'apprentissage profond représente un paradigme puissant pour construire des systèmes de reconnaissance d'images évolutifs capables de traiter des ensembles de données visuelles massives. Cette intégration aborde les défis critiques des applications modernes de vision par ordinateur, fournissant l'infrastructure computationnelle nécessaire pour entraîner des modèles complexes sur des données distribuées. Bien que la mise en œuvre nécessite une attention particulière aux principes des systèmes distribués et à la gestion des ressources, les systèmes résultants offrent une évolutivité et des performances sans précédent. Alors que la vision par ordinateur continue d'évoluer, cette combinaison puissante permettra des applications de plus en plus sophistiquées dans tous les secteurs, de la santé et des systèmes autonomes aux applications créatives et au-delà, stimulant l'innovation dans la manière dont les machines comprennent et interprètent les informations visuelles.

Questions fréquemment posées

Qu'est-ce que la reconnaissance d'images et pourquoi est-elle importante ?

La reconnaissance d'images permet aux ordinateurs d'identifier des objets, des personnes et des modèles dans les données visuelles. Elle est cruciale pour des applications comme les diagnostics médicaux, les véhicules autonomes, les systèmes de sécurité et l'analyse de détail, fournissant automatisation et insights à partir d'informations visuelles.

Comment l'apprentissage profond améliore-t-il la précision de la reconnaissance d'images ?

L'apprentissage profond apprend automatiquement des caractéristiques pertinentes à partir de données d'image brutes via des réseaux neuronaux, éliminant l'ingénierie manuelle des caractéristiques. Cela permet des systèmes plus robustes et précis capables de gérer des modèles visuels complexes et des variations dans des conditions réelles.

À quoi servent les réseaux neuronaux convolutifs dans le traitement d'images ?

Les CNN sont des architectures neuronales spécialisées conçues pour les données d'image. Elles utilisent des couches convolutionnelles pour détecter des motifs spatiaux, du pooling pour la réduction de dimensionnalité et l'apprentissage hiérarchique des caractéristiques pour reconnaître des objets à différents niveaux d'abstraction avec invariance translationnelle.

Comment Apache Spark profite-t-il à l'apprentissage profond pour la reconnaissance d'images ?

Spark permet le traitement distribué de grands ensembles de données d'images sur des clusters, réduisant considérablement le temps d'entraînement pour les modèles complexes. Son calcul en mémoire et sa tolérance aux pannes le rendent idéal pour les flux de travail d'apprentissage profond itératif avec des données visuelles massives.

Puis-je mettre en œuvre la reconnaissance d'images sur du matériel standard ?

Oui, les systèmes de base peuvent fonctionner sur des machines locales en utilisant des frameworks comme TensorFlow ou PyTorch avec Spark. Cependant, pour de grands ensembles de données ou un déploiement en production, des clusters distribués ou des ressources cloud sont recommandés pour des performances et une évolutivité adéquates.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre