Annotation

- Introduction

- Comprendre les workflows LLM

- Qu'est-ce qu'un workflow ?

- Limitations de l'automatisation traditionnelle

- L'essor des workflows LLM pour une automatisation améliorée

- Modèles de conception courants dans les workflows LLM

- Flux pilotés par des modèles de langage de grande taille

- Les pièges de ne pas définir un workflow solide

- Comment prévenir les coûts informatiques élevés

- Mettre en œuvre votre propre workflow LLM

- Avantages et inconvénients

- Conclusion

- Questions fréquemment posées

Maîtriser les Flux de Travail LLM : Guide d'Automatisation IA et de Mise en Œuvre d'Agents

Maîtriser les flux de travail LLM permet une automatisation efficace des tâches complexes en utilisant des agents IA, couvrant les modèles de conception, la mise en œuvre et les coûts

Introduction

Les workflows de modèles de langage de grande taille représentent la prochaine évolution de l'automatisation, transformant la manière dont les entreprises gèrent des tâches complexes grâce à des systèmes d'IA intelligents. En combinant des processus structurés avec les capacités créatives des LLM, les organisations peuvent automatiser tout, du service client à la création de contenu, tout en maintenant la flexibilité et l'évolutivité.

Comprendre les workflows LLM

Au cœur, les workflows LLM sont des processus systématiques qui exploitent l'intelligence artificielle pour accomplir des objectifs spécifiques à travers une séquence d'étapes bien définies. Contrairement à l'automatisation traditionnelle qui repose sur des règles rigides, ces workflows incorporent la compréhension contextuelle et les capacités génératives des modèles de langage avancés.

Qu'est-ce qu'un workflow ?

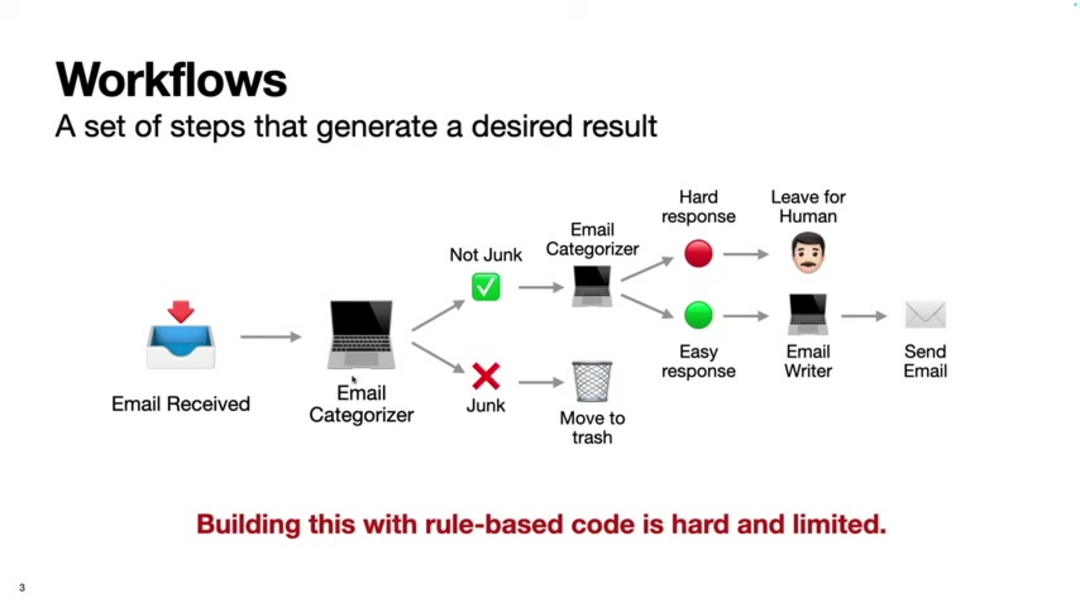

Un workflow représente une série structurée d'actions conçues pour atteindre un résultat particulier efficacement. Lorsqu'il est correctement défini, un workflow permet des résultats cohérents tout en permettant l'optimisation et l'automatisation. La fondation de tout workflow efficace commence par des objectifs clairs et progresse à travers des étapes logiques qui peuvent impliquer une intervention humaine, des processus automatisés, ou une combinaison des deux.

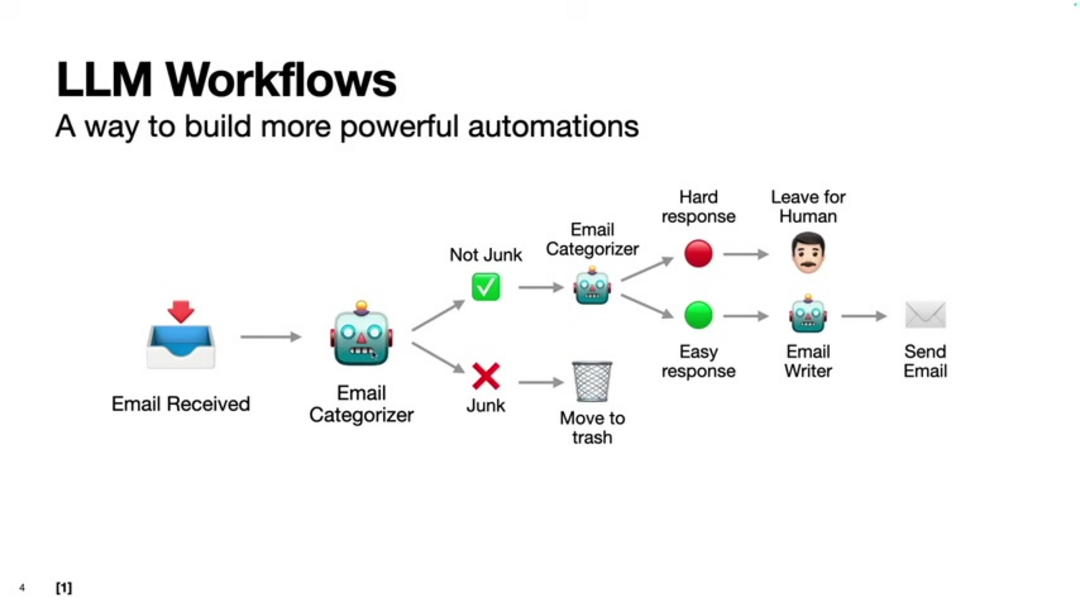

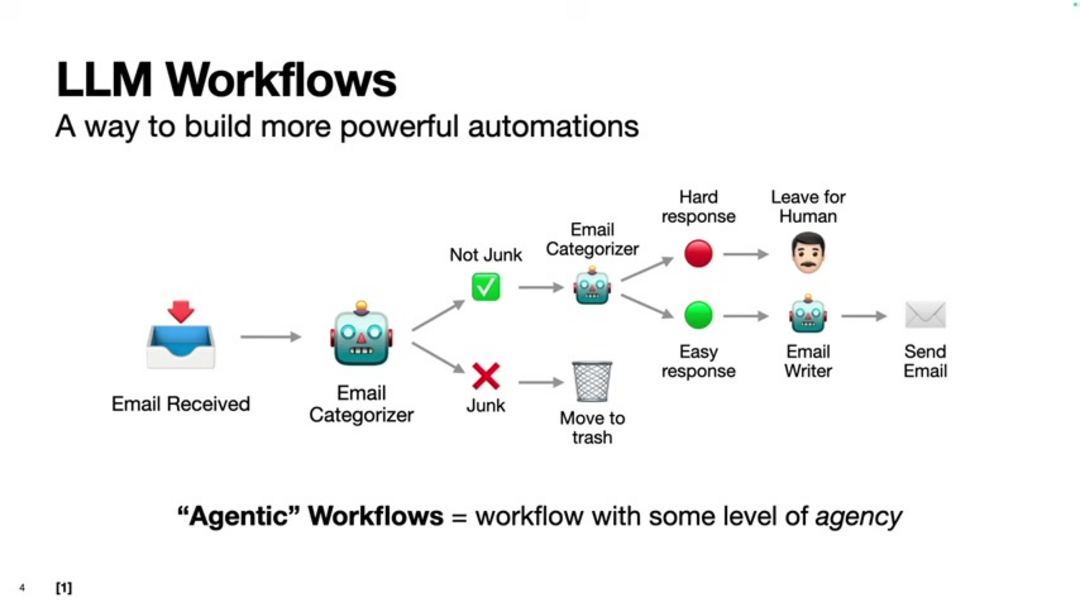

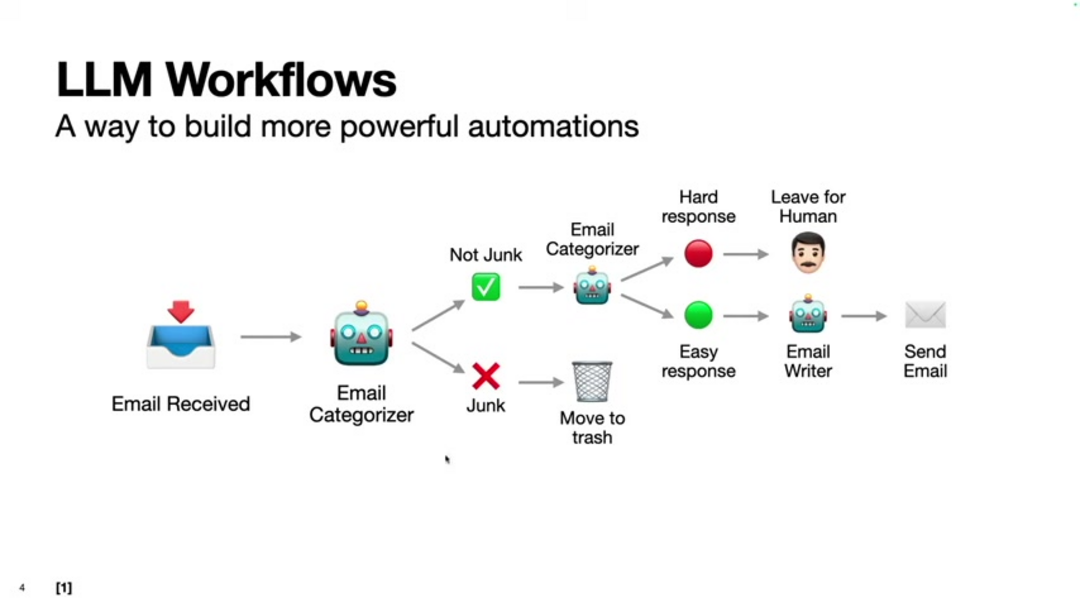

Considérez l'exemple de la gestion des emails entrants : un workflow de base pourrait impliquer la réception de messages, l'analyse du contenu, la prise de décisions de classification, et les actions appropriées. Avec des assistants email IA, ce processus devient automatisé tout en maintenant une conscience contextuelle que les systèmes traditionnels manquent.

Les caractéristiques clés des workflows efficaces incluent l'orientation vers un objectif, le traitement séquentiel, et la répétabilité. Chaque workflow devrait commencer par des objectifs clairement définis, suivre des étapes logiques dans l'ordre approprié, et produire des résultats cohérents lorsqu'il est exécuté plusieurs fois. Cette approche structurée forme la fondation pour mettre en œuvre des systèmes d'automatisation LLM sophistiqués.

Limitations de l'automatisation traditionnelle

Les systèmes d'automatisation conventionnels ont souvent du mal avec la flexibilité et l'adaptabilité en raison de leur nature basée sur des règles. Ces systèmes nécessitent une programmation explicite pour chaque scénario possible, les rendant difficiles à mettre à l'échelle et à maintenir à mesure que la complexité augmente. Les approches traditionnelles excellent généralement avec des données structurées mais échouent face à des informations non structurées comme le langage naturel ou des documents complexes.

Les défis principaux incluent la rigidité du système qui empêche l'adaptation aux conditions changeantes, les problèmes d'évolutivité à mesure que la complexité des scénarios augmente, l'incapacité à traiter efficacement les données non structurées, et les coûts élevés de développement et de maintenance. Par exemple, un classificateur d'email basé sur des règles pourrait identifier le spam basé sur des mots-clés spécifiques, mais les spammeurs peuvent facilement contourner ces règles en modifiant leurs tactiques.

L'essor des workflows LLM pour une automatisation améliorée

Les modèles de langage de grande taille ont révolutionné l'automatisation en introduisant des systèmes qui peuvent comprendre le contexte, traiter des données non structurées, et générer du contenu créatif. Cette avancée technologique permet l'automatisation de tâches précédemment considérées comme impossibles pour les systèmes traditionnels, ouvrant de nouvelles possibilités à travers diverses industries et applications.

Les workflows LLM offrent des avantages significatifs incluant une flexibilité accrue pour gérer divers types de données et conditions changeantes, une évolutivité améliorée pour gérer de grands volumes d'informations, des capacités créatives améliorées pour la génération de contenu, et des coûts de développement réduits grâce à des modèles pré-entraînés. Ces avantages rendent les workflows LLM particulièrement précieux pour les plateformes d'automatisation IA qui nécessitent à la fois structure et adaptabilité.

Modèles de conception courants dans les workflows LLM

Plusieurs modèles établis ont émergé pour structurer efficacement les workflows LLM. Comprendre ces modèles aide les développeurs à créer des systèmes IA robustes et évolutifs qui peuvent gérer des tâches complexes efficacement tout en maintenant le contrôle sur le processus d'automatisation.

Les modèles de conception clés incluent l'enchaînement de multiples LLM en séquence où la sortie de chaque modèle alimente le suivant, le routage des tâches vers des agents spécialisés basé sur l'analyse des entrées, le traitement parallèle où plusieurs LLM travaillent simultanément sur des sous-tâches, les architectures orchestrateur-travailleur qui coordonnent des composants IA spécialisés, et les systèmes évaluateur-optimiseur qui affinent les sorties grâce à l'amélioration itérative. Ces modèles forment la fondation pour construire des agents et assistants IA sophistiqués.

Flux pilotés par des modèles de langage de grande taille

Les flux pilotés par LLM représentent un changement de paradigme par rapport aux workflows prédéterminés vers des systèmes dynamiques et conscients du contexte. Au lieu de suivre des séquences fixes, ces flux permettent à l'IA de déterminer les prochaines étapes appropriées basées sur l'analyse en temps réel de la situation et des informations disponibles.

Les avantages principaux incluent une adaptabilité supérieure aux conditions changeantes, une conscience contextuelle améliorée pour des décisions plus intelligentes, et une plus grande flexibilité à travers divers scénarios. Deux modèles prominents dans cette catégorie sont les systèmes orchestrateur-travailleur où un LLM central coordonne des travailleurs spécialisés, et les configurations évaluateur-optimiseur où les sorties sont continuellement évaluées et affinées. Ces approches sont particulièrement efficaces pour les outils d'IA conversationnelle qui nécessitent des interactions naturelles et conscientes du contexte.

Les pièges de ne pas définir un workflow solide

Sans une conception de workflow appropriée, les implémentations LLM peuvent devenir inefficaces et coûteuses. À mesure que la complexité des modèles augmente, les exigences computationnelles croissent exponentiellement, rendant une planification minutieuse essentielle pour un déploiement pratique et une opération durable.

Une conception de workflow inefficace mène souvent à des coûts computationnels excessifs, particulièrement lorsqu'on traite des cas marginaux ou des scénarios de longue traîne. Une planification appropriée aide à identifier où le code traditionnel, l'apprentissage automatique, ou l'invocation LLM fournit la solution la plus efficace pour chaque aspect d'un système.

Comment prévenir les coûts informatiques élevés

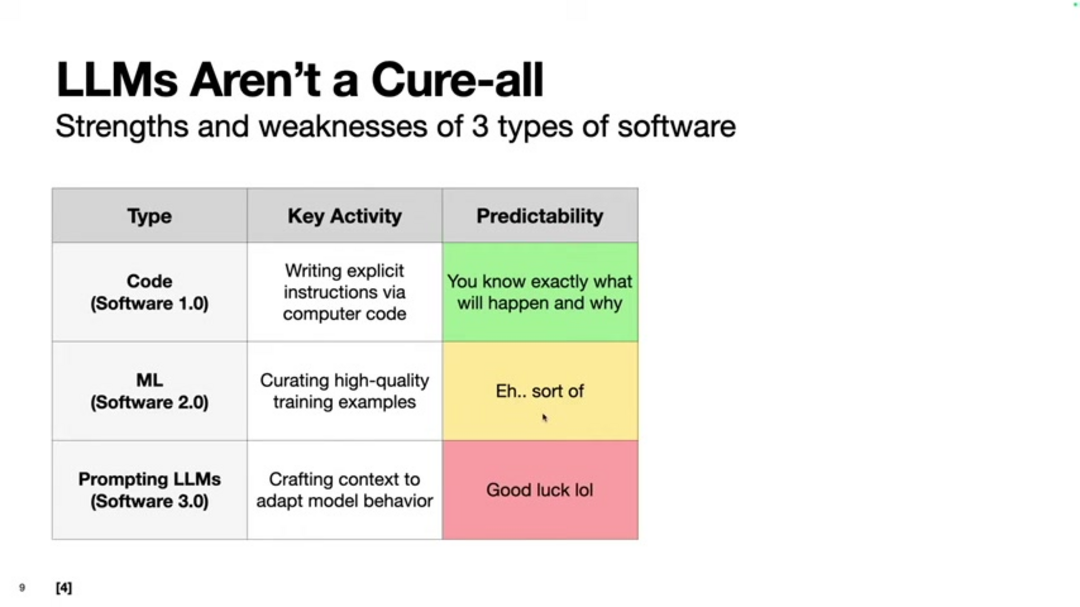

Comprendre les forces et limitations des différentes approches logicielles est crucial pour une implémentation LLM rentable. Le cadre d'Andrej Karpathy distingue entre le code traditionnel (Logiciel 1.0), les systèmes d'apprentissage automatique (Logiciel 2.0), et l'invocation LLM (Logiciel 3.0), chacun avec des caractéristiques distinctes et des cas d'utilisation appropriés.

En combinant stratégiquement ces approches, les développeurs peuvent créer des systèmes qui exploitent la prédictibilité du code traditionnel là où c'est approprié tout en utilisant les LLM pour des tâches nécessitant flexibilité et créativité. Cette approche hybride est fondamentale pour des API et SDK IA efficaces qui équilibrent performance et efficacité computationnelle.

Mettre en œuvre votre propre workflow LLM

Commencer avec l'implémentation de workflow LLM nécessite une configuration appropriée de l'environnement et une compréhension des outils disponibles. Le SDK Agent OpenAI fournit une fondation solide pour construire des systèmes IA sophistiqués qui peuvent gérer des tâches complexes à travers des workflows bien structurés.

Les étapes de configuration essentielles incluent l'installation de Python et des bibliothèques nécessaires, l'obtention de clés API pour l'accès LLM, la configuration sécurisée des variables d'environnement, et la création de fichiers d'instructions qui guident le comportement de l'agent. Cette fondation permet aux développeurs de construire tout, des scripts d'automatisation simples aux systèmes de chatbot IA complexes avec des capacités de workflow sophistiquées.

Avantages et inconvénients

Avantages

- Flexibilité exceptionnelle pour gérer les données non structurées et les conditions changeantes

- Évolutivité facile des petites tâches aux applications de niveau entreprise

- Capacités avancées de création de contenu pour le marketing et les communications

- Coûts de développement et de maintenance réduits par rapport aux systèmes personnalisés

- Compréhension contextuelle qui s'améliore avec plus de données et d'utilisation

- Interface en langage naturel qui nécessite une expertise technique minimale

- Amélioration continue grâce aux mises à jour des modèles et au réglage fin

Inconvénients

- Imprévisibilité des sorties qui défie les exigences déterministes

- Coûts computationnels élevés pour les modèles complexes et le déploiement à grande échelle

- Confusion potentielle avec les cas marginaux et les entrées ambiguës

- Contrôle limité sur les sorties spécifiques par rapport à la programmation traditionnelle

- Dépendance à la disponibilité de l'API et interruptions potentielles de service

Conclusion

Les workflows LLM représentent une approche transformative de l'automatisation qui combine la structure des workflows traditionnels avec la flexibilité et l'intelligence des systèmes IA avancés. En comprenant les modèles de conception, les stratégies d'implémentation, et les considérations de coût, les organisations peuvent exploiter ces technologies pour automatiser des tâches complexes tout en maintenant le contrôle et l'efficacité. Alors que le domaine continue d'évoluer, maîtriser les workflows LLM deviendra de plus en plus essentiel pour les entreprises cherchant un avantage concurrentiel grâce à l'automatisation intelligente.

Questions fréquemment posées

Quels sont les principaux avantages de l'utilisation des flux de travail LLM pour l'automatisation ?

Les flux de travail LLM offrent une flexibilité supérieure pour traiter les données non structurées, une évolutivité facile, des coûts de développement réduits et une compréhension contextuelle que l'automatisation traditionnelle n'a pas, permettant des systèmes plus intelligents et adaptatifs.

Quelle est la différence entre les flux de travail en chaîne et les flux de travail pilotés par LLM ?

Les flux de travail en chaîne utilisent des séquences prédéfinies de LLM, tandis que les flux de travail pilotés par LLM permettent une prise de décision dynamique où l'IA détermine les étapes suivantes en fonction du contexte, offrant une plus grande adaptabilité et résilience.

Comment commencer avec le SDK Agent d'OpenAI ?

Commencez par installer Python et le SDK Agent OpenAI via pip, obtenez une clé API, configurez les variables d'environnement et créez des fichiers d'instructions pour définir le comportement de l'agent et les outils pour des tâches spécifiques.

Quelles sont les utilisations les plus courantes des agents IA ?

Les agents IA excellent dans le résumé d'emails, la création automatisée de contenu, les chatbots de service client, la gestion intelligente des tâches, l'analyse de données et les processus complexes de prise de décision nécessitant une compréhension contextuelle.

Que sont les Logiciels 1.0, 2.0 et 3.0 dans le contexte de l'IA ?

Le Logiciel 1.0 fait référence au code traditionnel, le 2.0 aux systèmes d'apprentissage automatique et le 3.0 au prompt LLM, chacun offrant différentes approches pour l'automatisation avec une flexibilité et des coûts variables.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre