Annotation

- Introducción

- Historia y Fundamentos de la IA

- Etapas del Flujo de Trabajo de IA

- Herramientas de Desarrollo de IA

- Pros y Contras

- Conclusión

- Preguntas frecuentes

Guía de flujo de trabajo de IA: desde la preparación de datos hasta las estrategias de implementación de modelos

Una guía completa de flujos de trabajo de IA que cubre la preparación de datos, el entrenamiento de modelos, la optimización y las estrategias de implementación utilizando herramientas como PyTorch.

Introducción

La inteligencia artificial se ha transformado de un concepto teórico a una herramienta práctica en todas las industrias. Comprender los flujos de trabajo de IA – los procesos sistemáticos que guían el desarrollo de IA desde los datos brutos hasta el despliegue en producción – es esencial para construir soluciones de IA efectivas. Esta guía integral explora cada etapa del ciclo de vida de la IA, proporcionando información sobre herramientas, técnicas y mejores prácticas que aseguran la implementación exitosa de proyectos de aprendizaje automático y aprendizaje profundo.

Historia y Fundamentos de la IA

La Inteligencia Artificial representa el amplio campo de la informática centrado en crear sistemas capaces de realizar tareas que normalmente requieren inteligencia humana. Esto abarca el aprendizaje, el razonamiento, la resolución de problemas, la percepción y la comprensión del lenguaje. El viaje comenzó en la década de 1950 con sistemas basados en reglas que seguían instrucciones de programación explícitas, pero la IA moderna ha evolucionado significativamente más allá de estas limitaciones iniciales.

La progresión desde la IA simbólica hasta los sistemas avanzados de hoy representa décadas de investigación y avance tecnológico. Los primeros sistemas de IA luchaban con la complejidad del mundo real, pero la aparición del aprendizaje automático marcó un cambio pivotal hacia enfoques basados en datos que podían adaptarse y mejorar con el tiempo. El panorama actual de la IA incluye plataformas de automatización de IA especializadas que agilizan los procesos de desarrollo.

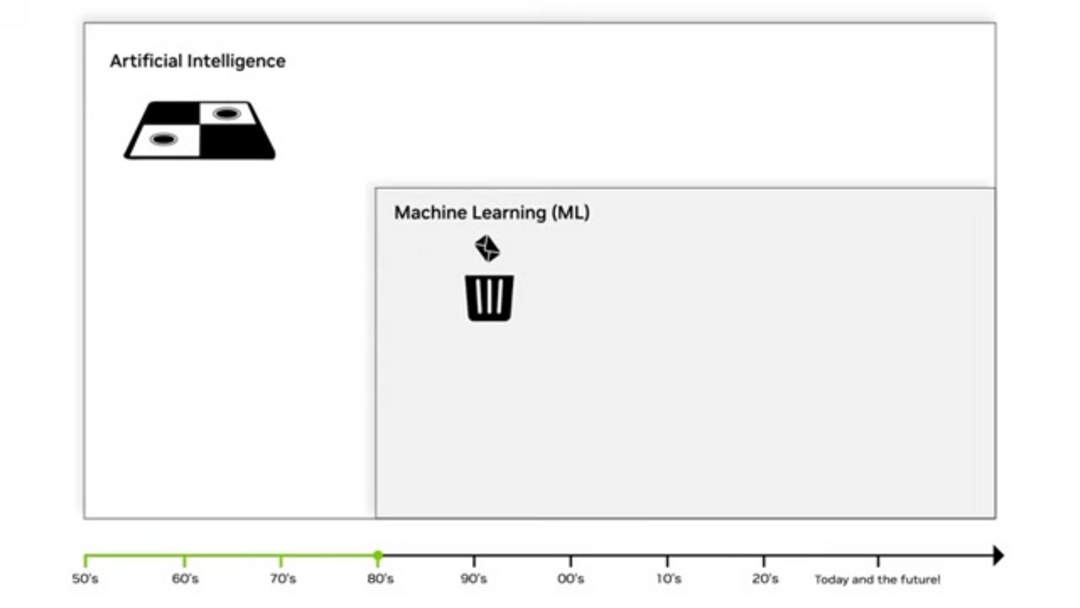

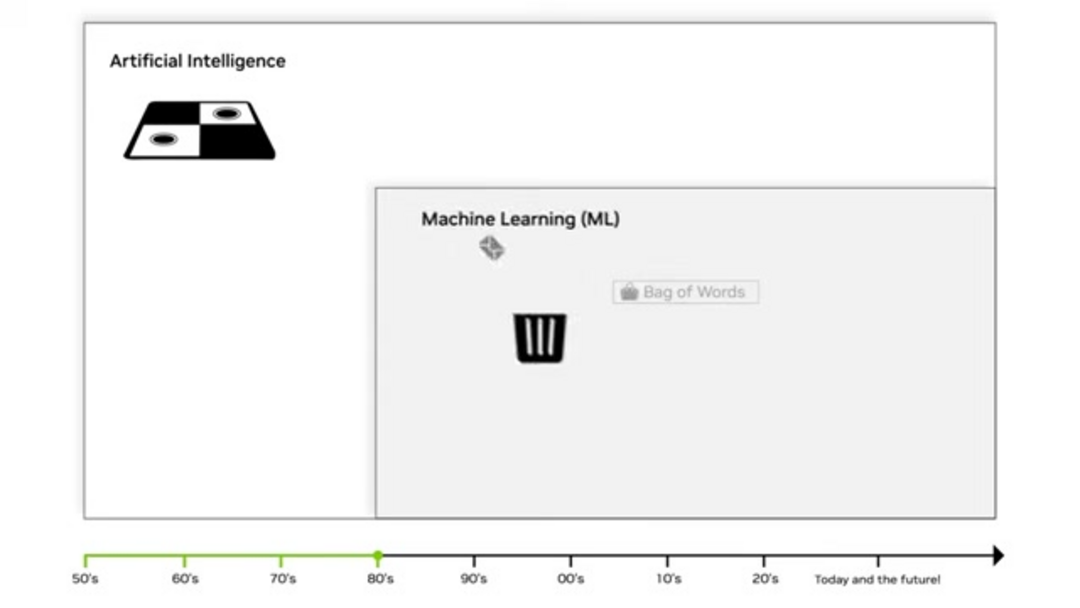

Aprendizaje Automático: La Revolución Estadística

El Aprendizaje Automático surgió en la década de 1980 como un enfoque transformador que utiliza métodos estadísticos para permitir que las computadoras aprendan de los datos sin programación explícita. A diferencia del software tradicional que sigue reglas fijas, los algoritmos de AA identifican patrones y relaciones dentro de los datos para hacer predicciones o decisiones. Esta base estadística permite que los modelos mejoren su rendimiento a medida que procesan más información.

Las técnicas clave de AA incluyen la regresión lineal para predecir valores continuos y algoritmos de clasificación como árboles de decisión para resultados categóricos. El enfoque "bolsa de palabras" revolucionó el análisis de texto al tratar los documentos como colecciones de palabras desordenadas, permitiendo aplicaciones como el filtrado de spam y el análisis de sentimientos. Estos métodos forman la columna vertebral de muchas herramientas de escritura con IA y sistemas de generación de contenido.

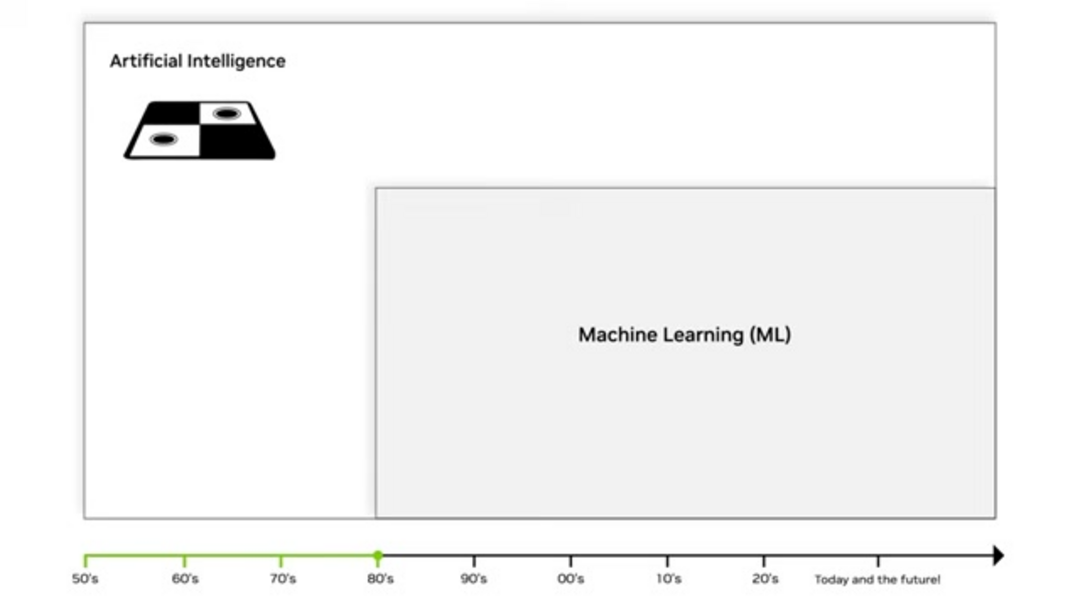

Aprendizaje Profundo y Redes Neuronales

El Aprendizaje Profundo representa un avance significativo dentro del aprendizaje automático, utilizando redes neuronales multicapa para aprender automáticamente características de los datos brutos. Lo "profundo" en el aprendizaje profundo se refiere a las múltiples capas a través de las cuales se transforman los datos, permitiendo que el sistema aprenda representaciones cada vez más abstractas. Este enfoque elimina la necesidad de ingeniería de características manual, que era un cuello de botella importante en el aprendizaje automático tradicional.

Tres factores clave impulsaron la revolución del aprendizaje profundo: hardware avanzado de GPU que aceleró la computación, conjuntos de datos masivos de fuentes digitales y algoritmos de entrenamiento mejorados. Las redes neuronales profundas sobresalen en tareas complejas como el reconocimiento de imágenes, el procesamiento del lenguaje natural y el reconocimiento de voz, impulsando chatbots de IA modernos y asistentes virtuales.

IA Generativa y Aplicaciones Modernas

La IA Generativa representa la frontera actual, permitiendo que los sistemas creen contenido original en lugar de simplemente analizar o clasificar datos existentes. Los Modelos de Lenguaje Grande (LLM) como GPT-4 demuestran capacidades notables en la generación de texto similar al humano, mientras que los modelos de difusión producen imágenes de alta calidad a partir de descripciones de texto. Esta capacidad generativa abre nuevas posibilidades para aplicaciones creativas y producción de contenido.

Las aplicaciones modernas de IA generativa abarcan múltiples dominios, incluyendo la creación automatizada de contenido, marketing personalizado, generación de código y expresión artística. Estos sistemas aprenden los patrones y estructuras subyacentes de sus datos de entrenamiento, luego generan nuevos ejemplos que siguen patrones similares. El auge de los generadores de imágenes con IA demuestra el impacto práctico de estas tecnologías.

Etapas del Flujo de Trabajo de IA

Un flujo de trabajo de IA proporciona un marco estructurado para desarrollar, desplegar y mantener sistemas de inteligencia artificial. Este enfoque sistemático asegura consistencia, reproducibilidad y eficiencia a lo largo del ciclo de vida del proyecto. Un flujo de trabajo bien definido típicamente incluye etapas de preparación de datos, desarrollo de modelos, optimización, despliegue y monitoreo, cada una con tareas y entregables específicos.

Seguir un flujo de trabajo estandarizado ayuda a los equipos a gestionar la complejidad, rastrear el progreso y mantener la calidad a lo largo del proceso de desarrollo. Este enfoque estructurado es particularmente importante cuando se trabaja con entornos complejos de alojamiento de modelos de IA y pipelines de despliegue.

Preparación de Datos: Fundamento para el Éxito

La preparación de datos transforma los datos brutos y no estructurados en un formato limpio y organizado adecuado para el entrenamiento de modelos. Esta fase crítica típicamente consume el 60-80% del tiempo total del proyecto pero impacta directamente en el rendimiento del modelo. El principio "basura entra, basura sale" enfatiza que incluso algoritmos sofisticados no pueden compensar datos de mala calidad.

Los pasos clave de preparación de datos incluyen recopilar diversas fuentes de datos, manejar valores faltantes mediante técnicas de imputación, identificar y abordar valores atípicos, estandarizar formatos entre conjuntos de datos y eliminar registros duplicados. La ingeniería de características crea nuevas variables a partir de datos existentes, mientras que la normalización asegura un escalado consistente. La preparación adecuada de datos sienta las bases para una integración efectiva de APIs y SDKs de IA.

Entrenamiento de Modelos y Selección de Algoritmos

El entrenamiento de modelos implica enseñar a los algoritmos a reconocer patrones y relaciones dentro de conjuntos de datos preparados. Este proceso utiliza optimización matemática para ajustar los parámetros del modelo, minimizando la diferencia entre predicciones y resultados reales. La elección del algoritmo depende del tipo de problema, las características de los datos y los requisitos de rendimiento.

El aprendizaje supervisado utiliza ejemplos etiquetados para entrenar modelos de clasificación y regresión, mientras que el aprendizaje no supervisado identifica patrones en datos no etiquetados mediante agrupamiento y reducción de dimensionalidad. El aprendizaje por refuerzo entrena agentes a través de interacciones de prueba y error con entornos. Cada enfoque requiere diferentes estrategias de entrenamiento y métricas de evaluación para asegurar un rendimiento robusto.

Técnicas de Optimización de Modelos

La optimización de modelos ajusta los modelos entrenados para mejorar el rendimiento, la eficiencia y la idoneidad para el despliegue. Este proceso iterativo aborda problemas como el sobreajuste, donde los modelos funcionan bien en datos de entrenamiento pero mal en nuevos ejemplos. La optimización equilibra la complejidad del modelo con la capacidad de generalización para lograr los mejores resultados prácticos.

Las técnicas comunes de optimización incluyen el ajuste de hiperparámetros para encontrar tasas de aprendizaje y arquitecturas de red óptimas, la poda de modelos para eliminar parámetros innecesarios, la cuantización para reducir la precisión para una inferencia más rápida y la destilación de conocimiento para transferir el aprendizaje de modelos grandes a versiones más pequeñas y eficientes. Estas técnicas son esenciales para preparar modelos para entornos de producción y aplicaciones de agentes y asistentes de IA.

Estrategias de Despliegue e Inferencia

El despliegue mueve los modelos entrenados desde entornos de desarrollo a sistemas de producción donde pueden generar predicciones sobre nuevos datos. Esta fase requiere una consideración cuidadosa de la latencia de inferencia (tiempo de respuesta), el rendimiento (solicitudes procesadas por segundo) y la escalabilidad (manejo de carga aumentada). Un despliegue exitoso asegura que los modelos entreguen valor en aplicaciones del mundo real.

Las estrategias de despliegue van desde simples APIs REST hasta arquitecturas complejas de microservicios con escalado automático. Los sistemas de monitoreo rastrean el rendimiento del modelo, la deriva de datos y la deriva de conceptos para mantener la precisión a lo largo del tiempo. Los pipelines de integración y despliegue continuo automatizan las actualizaciones y aseguran la consistencia entre entornos.

Herramientas de Desarrollo de IA

Las herramientas esenciales agilizan el desarrollo de IA, desde el procesamiento de datos hasta el despliegue. Las plataformas clave incluyen RAPIDS para ciencia de datos acelerada, PyTorch y TensorFlow para aprendizaje profundo, y soluciones NVIDIA para inferencia optimizada.

RAPIDS para Procesamiento de Datos Acelerado

RAPIDS proporciona bibliotecas de ciencia de datos aceleradas por GPU que aceleran significativamente la preparación y análisis de datos. Construido sobre Apache Arrow, RAPIDS ofrece interfaces familiares de Python mientras aprovecha las capacidades de procesamiento paralelo de las GPU modernas. La biblioteca cuDF proporciona funcionalidad similar a pandas para la manipulación de datos, mientras que cuML acelera los algoritmos de aprendizaje automático.

Marcos PyTorch y TensorFlow

PyTorch y TensorFlow dominan el panorama del aprendizaje profundo con fortalezas complementarias. PyTorch enfatiza la flexibilidad y la depuración intuitiva a través de grafos de computación dinámicos, haciéndolo popular para investigación y prototipado. TensorFlow ofrece capacidades de despliegue listas para producción con herramientas robustas y amplio soporte comunitario.

NVIDIA TensorRT para Optimización de Inferencia

TensorRT optimiza modelos entrenados para inferencia de alto rendimiento en hardware NVIDIA. A través de técnicas como fusión de capas, calibración de precisión y autoajuste de kernels, TensorRT puede lograr mejoras significativas de velocidad sin sacrificar precisión. La plataforma soporta modelos de múltiples marcos a través de interoperabilidad ONNX.

Servidor de Inferencia NVIDIA Triton

El Servidor de Inferencia Triton proporciona una plataforma unificada para desplegar modelos de múltiples marcos simultáneamente. Su arquitectura flexible soporta diversos tipos de modelos, configuraciones de procesamiento por lotes y modelos de conjunto. Triton simplifica la complejidad del despliegue mientras maximiza la utilización del hardware mediante programación inteligente y ejecución concurrente.

Pros y Contras

Ventajas

- Automatiza procesos complejos de toma de decisiones de manera eficiente

- Mejora la precisión y consistencia sobre operadores humanos

- Escala para manejar conjuntos de datos masivos y requisitos de computación

- Proporciona información basada en datos y capacidades predictivas

- Permite experiencias y recomendaciones personalizadas

- Reduce costos operativos mediante automatización

- Acelera ciclos de innovación y desarrollo de productos

Desventajas

- Requiere recursos computacionales e infraestructura significativos

- Dependiente de datos de entrenamiento de alta calidad y representativos

- Complejo de implementar, mantener y actualizar adecuadamente

- Potencial de resultados sesgados basados en datos de entrenamiento

- La naturaleza de caja negra puede hacer que las decisiones sean difíciles de interpretar

Conclusión

Dominar los flujos de trabajo de IA proporciona la base para una implementación exitosa de la inteligencia artificial en todas las industrias. Desde la cuidadosa preparación de datos hasta el despliegue optimizado, cada etapa contribuye a construir sistemas de IA confiables y efectivos. El ecosistema de herramientas en evolución – incluyendo RAPIDS, PyTorch, TensorFlow, TensorRT y Triton – continúa bajando barreras mientras aumenta las capacidades. A medida que las tecnologías de IA avanzan, comprender estos flujos de trabajo se vuelve cada vez más esencial para las organizaciones que buscan aprovechar la inteligencia artificial para ventaja competitiva e innovación.

Preguntas frecuentes

¿Cuál es el paso más crítico en los flujos de trabajo de IA?

La preparación de datos a menudo se considera el paso más crítico porque el rendimiento del modelo depende directamente de la calidad, integridad y relevancia de los datos. Los datos deficientes conducen a modelos poco fiables independientemente de la sofisticación del algoritmo.

¿Cómo mejora RAPIDS los flujos de trabajo de IA?

RAPIDS acelera la preparación y el procesamiento de datos utilizando el paralelismo de GPU, reduciendo el tiempo de procesamiento de horas a minutos mientras mantiene interfaces Python familiares para los científicos de datos.

¿Cuál es la diferencia entre PyTorch y TensorFlow?

PyTorch utiliza gráficos de cálculo dinámicos para flexibilidad y depuración, mientras que TensorFlow enfatiza la implementación en producción con gráficos estáticos y herramientas extensas. Ambos son marcos poderosos con diferentes fortalezas.

¿Por qué es importante la optimización de modelos?

La optimización mejora la eficiencia del modelo, reduce los requisitos computacionales y mejora la velocidad de inferencia manteniendo la precisión, lo cual es crucial para la implementación en producción y la experiencia del usuario.

¿Qué proporciona Triton Inference Server?

Triton proporciona una implementación unificada para múltiples modelos de marcos, admitiendo ejecución concurrente, procesamiento por lotes dinámico y modelos de conjunto mientras maximiza la utilización del hardware mediante programación inteligente.

Artículos relevantes sobre IA y tendencias tecnológicas

Mantente al día con las últimas ideas, herramientas e innovaciones que dan forma al futuro de la IA y la tecnología.

Grok AI: Generación Ilimitada de Videos Gratuita a partir de Texto e Imágenes | Guía 2024

Grok AI ofrece generación ilimitada de videos gratuita a partir de texto e imágenes, haciendo accesible la creación de videos profesionales para todos sin necesidad de habilidades de edición.

Configuración de Grok 4 Fast en Janitor AI: Guía Completa de Juego de Roles Sin Filtros

Guía paso a paso para configurar Grok 4 Fast en Janitor AI para juego de roles sin restricciones, incluyendo configuración de API, ajustes de privacidad y consejos de optimización

Las 3 mejores extensiones gratuitas de IA para programar en VS Code 2025 - Aumenta la productividad

Descubre las mejores extensiones gratuitas de agentes de IA para programar en Visual Studio Code en 2025, incluyendo Gemini Code Assist, Tabnine y Cline, para mejorar tu