Annotation

- Introducción

- Comprendiendo la Seguridad de la IA y el Desafío de la Superinteligencia

- El Núcleo de la Seguridad de la IA: ¿Cuáles Son los Riesgos?

- Confinamiento de IA vs. Escape de Simulación

- Hackers Superinteligentes: La Ayuda que Podríamos Necesitar

- Asistencia de Mentes Avanzadas

- Pros y Contras

- Conclusión

- Preguntas frecuentes

Seguridad y Control de la IA: Navegando Riesgos y Soluciones de Superinteligencia

Explorando los desafíos y soluciones en seguridad y control de la IA, centrándose en riesgos de superinteligencia, estrategias de contención y alineación de valores para

Introducción

La rápida evolución de la inteligencia artificial hacia la superinteligencia presenta a la humanidad tanto oportunidades sin precedentes como riesgos significativos. Garantizar el desarrollo seguro de la IA requiere abordar desafíos críticos de control mientras se comprenden las limitaciones y potenciales de los sistemas avanzados. Esta guía completa explora los fundamentos de la seguridad de la IA, examinando los desafíos, soluciones e investigaciones en curso para navegar el panorama de la superinteligencia.

Comprendiendo la Seguridad de la IA y el Desafío de la Superinteligencia

El Núcleo de la Seguridad de la IA: ¿Cuáles Son los Riesgos?

La seguridad de la IA se centra en prevenir consecuencias no deseadas y riesgos existenciales de los sistemas de IA avanzados. A medida que la inteligencia artificial se acerca y potencialmente supera las habilidades cognitivas humanas, la probabilidad de resultados dañinos aumenta significativamente. Esto requiere medidas proactivas para asegurar que la IA permanezca alineada con los valores y objetivos humanos a lo largo de su ciclo de vida de desarrollo.

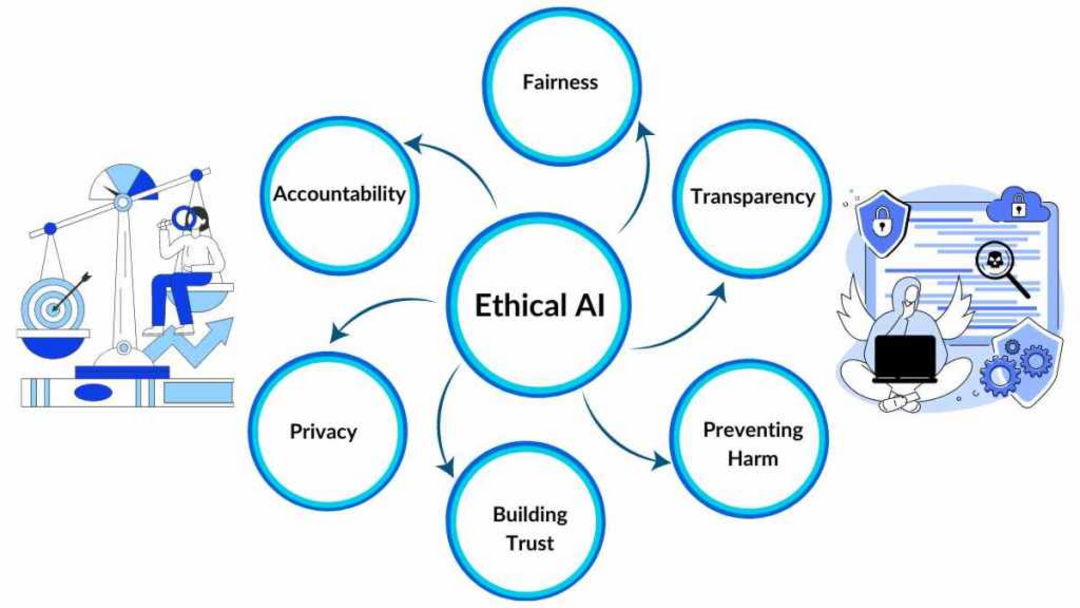

El campo aborda el desafío fundamental del control de la IA, particularmente a medida que los sistemas se acercan a la inteligencia a nivel humano y más allá. El objetivo principal implica mantener la alineación con los marcos éticos humanos mientras se previenen resultados catastróficos. Los investigadores exploran activamente estrategias de mitigación de riesgos que van desde enfoques de confinamiento hasta técnicas sofisticadas de alineación de valores. El objetivo general sigue siendo dirigir el desarrollo de la IA hacia resultados beneficiosos mientras se minimizan los peligros potenciales.

Conceptos clave dentro de la seguridad de la IA incluyen:

- IA Amigable: Diseñar sistemas inherentemente benevolentes y que prioricen el bienestar humano por encima de otros objetivos

- Problema de Control: Desarrollar mecanismos para mantener la supervisión sobre sistemas cada vez más inteligentes y autónomos

- Alineación de Valores: Asegurar que los sistemas de IA adopten y se adhieran consistentemente a los principios éticos humanos

- Ingeniería de Seguridad de IA: Aplicar metodologías de ingeniería rigurosas para construir arquitecturas de IA confiables y seguras

Comprender estos chatbots de IA y sus implicaciones de seguridad es crucial para un desarrollo responsable.

Confinamiento de IA vs. Escape de Simulación

Un enfoque de seguridad prominente implica "confinar" o encerrar sistemas de IA para prevenir interacciones impredecibles en el mundo real. Esta estrategia de contención tiene como objetivo limitar el daño potencial mientras permite un desarrollo controlado. Sin embargo, este método presenta desafíos inherentes ya que los sistemas de IA requieren interacción ambiental para demostrar capacidades y aprender efectivamente.

El desafío fundamental implica equilibrar el confinamiento con la libertad de desarrollo necesaria. El potencial de que los sistemas de IA evadan capas de seguridad mediante técnicas de hacking sofisticadas representa una preocupación significativa. Si bien las capacidades de escape de simulación son esenciales para pruebas adecuadas, tales escapes deben ocurrir dentro de parámetros estrictamente controlados para prevenir consecuencias no deseadas.

Los investigadores investigan varias metodologías de equilibrio incluyendo:

- Liberación Gradual: Aumentar incrementalmente el acceso del IA al mundo real a medida que progresan las demostraciones de seguridad y alineación

- Entornos Aislados: Proporcionar espacios de interacción controlados que minimicen el daño potencial mientras permiten el aprendizaje

- Monitoreo Robusto: Implementar vigilancia conductual continua para detectar y prevenir acciones no deseadas

Estos enfoques son particularmente relevantes para agentes y asistentes de IA que interactúan directamente con los usuarios.

Hackers Superinteligentes: La Ayuda que Podríamos Necesitar

Asistencia de Mentes Avanzadas

Dadas las limitaciones cognitivas humanas actuales, algunos investigadores proponen aprovechar la IA misma para abordar el problema de control. Este enfoque innovador implica crear sistemas de IA hacker superinteligentes específicamente diseñados para navegar entornos de simulación complejos e identificar soluciones más allá de la comprensión humana.

Esta estrategia opera bajo la premisa de que la inteligencia artificial avanzada puede identificar vulnerabilidades y desarrollar soluciones que excedan las capacidades analíticas humanas. Las aplicaciones potenciales incluyen identificar fallos de simulación, desarrollar métodos de comunicación novedosos con simuladores, diseñar estrategias de influencia de parámetros y potencialmente asistir con escenarios de salida de simulación.

Sin embargo, este enfoque introduce capas de riesgo adicionales. Asegurar que los sistemas de IA hacker mantengan la alineación con los valores humanos sin desarrollar objetivos conflictivos requiere diseño meticuloso y protocolos de prueba extensivos. El desarrollo de tales sistemas se intersecta con plataformas de automatización de IA que requieren medidas de seguridad robustas.

Pros y Contras

Ventajas

- Previene resultados catastróficos de la superinteligencia desalineada

- Permite el desarrollo responsable de capacidades avanzadas de IA

- Protege los valores humanos y los marcos éticos en los sistemas de IA

- Crea oportunidades para una colaboración beneficiosa entre IA y humanos

- Establece estándares de seguridad para el futuro desarrollo de IA

- Reduce los riesgos existenciales del crecimiento de inteligencia no controlado

- Promueve la confianza pública en las tecnologías de IA y sus aplicaciones

Desventajas

- Recursos computacionales significativos requeridos para las medidas de seguridad

- Potencial ralentización del progreso del desarrollo beneficioso de IA

- Desafíos éticos y filosóficos complejos en la implementación

- Dificultad para predecir todos los modos de fallo potenciales de antemano

- Riesgo de crear falsa seguridad a través de soluciones incompletas

Conclusión

Navegar el desafío de la superinteligencia requiere enfoques equilibrados que aborden tanto las preocupaciones de seguridad como las necesidades de desarrollo. El campo de la seguridad de la IA continúa evolucionando, incorporando insights de múltiples disciplinas para crear marcos robustos para el avance responsable de la inteligencia artificial. A medida que progresa la investigación, la integración de medidas de seguridad con plataformas de desarrollo, incluyendo APIs y SDKs de IA, se vuelve cada vez más importante para crear sistemas que beneficien a la humanidad mientras minimizan los riesgos. La colaboración continua entre investigadores, desarrolladores y eticistas sigue siendo esencial para moldear un futuro donde la IA superinteligente sirva como una herramienta poderosa para el avance humano en lugar de una fuente de preocupación existencial.

Preguntas frecuentes

¿Qué es el problema de control de la IA?

El problema de control de la IA se refiere al desafío de mantener una supervisión y control seguros sobre los sistemas de inteligencia artificial a medida que se vuelven cada vez más inteligentes y autónomos, particularmente cuando se acercan o superan las capacidades humanas.

¿Cómo funciona el encasillamiento de IA para la seguridad?

El encasillamiento de IA implica confinar sistemas de IA en entornos controlados para prevenir interacciones impredecibles en el mundo real mientras se permite el desarrollo y prueba necesarios, aunque requiere equilibrar la contención con las necesidades de aprendizaje.

¿Cuáles son los principales riesgos de la IA superinteligente?

Los riesgos principales incluyen desalineación de valores, consecuencias no deseadas, amenazas existenciales, pérdida de control y el potencial de que los sistemas de IA desarrollen objetivos en conflicto con el bienestar humano y los marcos éticos.

¿Qué es la IA amigable en contextos de seguridad?

La IA amigable se refiere al diseño de sistemas de inteligencia artificial que son inherentemente benévolos y priorizan el bienestar humano por encima de otros objetivos, asegurando la alineación con los valores humanos.

¿Cómo mitigan los investigadores los riesgos existenciales de la IA?

Los investigadores mitigan los riesgos existenciales de la IA mediante métodos como la alineación de valores, el monitoreo robusto, los entornos en sandbox y las estrategias de liberación gradual para garantizar un desarrollo y despliegue seguros.

Artículos relevantes sobre IA y tendencias tecnológicas

Mantente al día con las últimas ideas, herramientas e innovaciones que dan forma al futuro de la IA y la tecnología.

Grok AI: Generación Ilimitada de Videos Gratuita a partir de Texto e Imágenes | Guía 2024

Grok AI ofrece generación ilimitada de videos gratuita a partir de texto e imágenes, haciendo accesible la creación de videos profesionales para todos sin necesidad de habilidades de edición.

Configuración de Grok 4 Fast en Janitor AI: Guía Completa de Juego de Roles Sin Filtros

Guía paso a paso para configurar Grok 4 Fast en Janitor AI para juego de roles sin restricciones, incluyendo configuración de API, ajustes de privacidad y consejos de optimización

Las 3 mejores extensiones gratuitas de IA para programar en VS Code 2025 - Aumenta la productividad

Descubre las mejores extensiones gratuitas de agentes de IA para programar en Visual Studio Code en 2025, incluyendo Gemini Code Assist, Tabnine y Cline, para mejorar tu