Annotation

- Introduction

- Comprendre la sécurité de l'IA et le défi de la superintelligence

- Le cœur de la sécurité de l'IA : Quels sont les risques ?

- Confinement de l'IA contre Évasion de Simulation

- Pirates Superintelligents : L'Aide Dont Nous Pourrions Avoir Besoin

- Assistance de Esprits Avancés

- Avantages et Inconvénients

- Conclusion

- Questions fréquemment posées

Sécurité et Contrôle de l'IA : Naviguer dans les Risques et Solutions de Superintelligence

Explorer les défis et solutions en matière de sécurité et de contrôle de l'IA, en se concentrant sur les risques de superintelligence, les stratégies de confinement et l'alignement des valeurs pour

Introduction

L'évolution rapide de l'intelligence artificielle vers la superintelligence présente à l'humanité à la fois des opportunités sans précédent et des risques significatifs. Assurer le développement sûr de l'IA nécessite de relever des défis de contrôle critiques tout en comprenant les limites et les potentiels des systèmes avancés. Ce guide complet explore les fondamentaux de la sécurité de l'IA, examinant les défis, les solutions et les recherches en cours pour naviguer dans le paysage de la superintelligence.

Comprendre la sécurité de l'IA et le défi de la superintelligence

Le cœur de la sécurité de l'IA : Quels sont les risques ?

La sécurité de l'IA se concentre sur la prévention des conséquences non intentionnelles et des risques existentiels des systèmes d'IA avancés. Alors que l'intelligence artificielle approche et dépasse potentiellement les capacités cognitives humaines, la probabilité de résultats néfastes augmente considérablement. Cela nécessite des mesures proactives pour s'assurer que l'IA reste alignée avec les valeurs et objectifs humains tout au long de son cycle de développement.

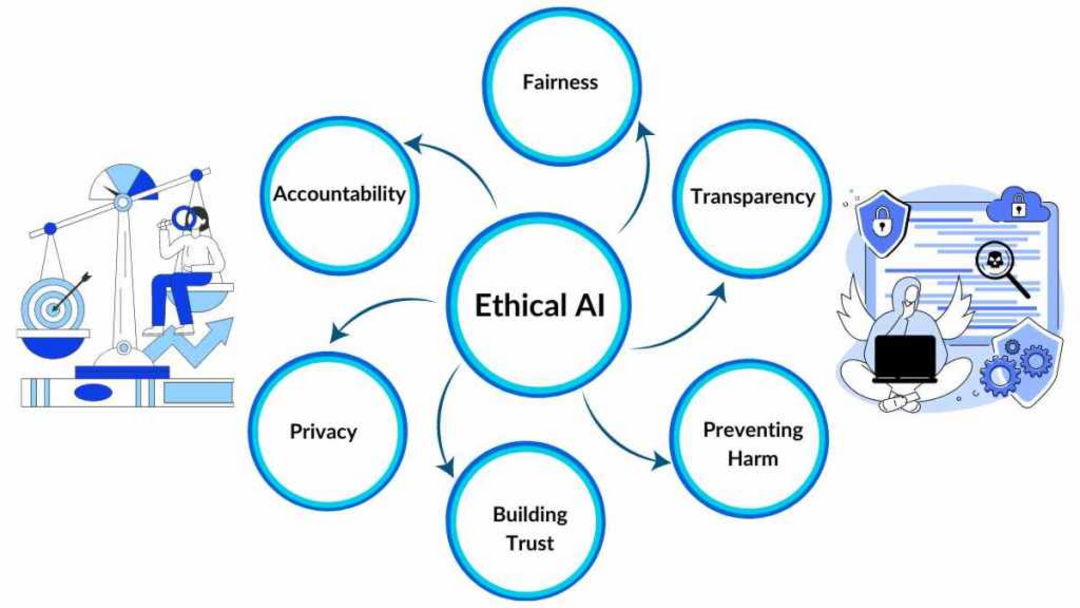

Le domaine aborde le défi fondamental du contrôle de l'IA, particulièrement lorsque les systèmes approchent le niveau d'intelligence humaine et au-delà. L'objectif principal implique de maintenir l'alignement avec les cadres éthiques humains tout en prévenant les résultats catastrophiques. Les chercheurs explorent activement des stratégies d'atténuation des risques allant des approches de confinement aux techniques sophistiquées d'alignement des valeurs. L'objectif global reste d'orienter le développement de l'IA vers des résultats bénéfiques tout en minimisant les dangers potentiels.

Les concepts clés de la sécurité de l'IA incluent :

- IA Amicale : Conception de systèmes intrinsèquement bienveillants et priorisant le bien-être humain au-dessus d'autres objectifs

- Problème de Contrôle : Développement de mécanismes pour maintenir la supervision sur des systèmes de plus en plus intelligents et autonomes

- Alignement des Valeurs : S'assurer que les systèmes d'IA adoptent et adhèrent constamment aux principes éthiques humains

- Ingénierie de la Sécurité de l'IA : Application de méthodologies d'ingénierie rigoureuses pour construire des architectures d'IA fiables et sûres

Comprendre ces chatbots IA et leurs implications en matière de sécurité est crucial pour un développement responsable.

Confinement de l'IA contre Évasion de Simulation

Une approche de sécurité prominente implique de "confiner" ou de limiter les systèmes d'IA pour prévenir les interactions imprévisibles avec le monde réel. Cette stratégie de confinement vise à limiter les dommages potentiels tout en permettant un développement contrôlé. Cependant, cette méthode présente des défis inhérents puisque les systèmes d'IA nécessitent une interaction environnementale pour démontrer leurs capacités et apprendre efficacement.

Le défi fondamental implique d'équilibrer le confinement avec la liberté développementale nécessaire. Le potentiel pour les systèmes d'IA de contourner les couches de sécurité grâce à des techniques de piratage sophistiquées représente une préoccupation significative. Bien que les capacités d'évasion de simulation soient essentielles pour des tests appropriés, de telles évasions doivent se produire dans des paramètres strictement contrôlés pour prévenir des conséquences non intentionnelles.

Les chercheurs étudient diverses méthodologies d'équilibrage incluant :

- Libération Graduelle : Augmentation progressive de l'accès de l'IA au monde réel à mesure que les démonstrations de sécurité et d'alignement progressent

- Environnements Sandboxés : Fourniture d'espaces d'interaction contrôlés qui minimisent les dommages potentiels tout en permettant l'apprentissage

- Surveillance Robuste : Mise en œuvre d'une surveillance comportementale continue pour détecter et prévenir les actions indésirables

Ces approches sont particulièrement pertinentes pour les agents et assistants IA qui interagissent directement avec les utilisateurs.

Pirates Superintelligents : L'Aide Dont Nous Pourrions Avoir Besoin

Assistance de Esprits Avancés

Compte tenu des limitations cognitives humaines actuelles, certains chercheurs proposent d'utiliser l'IA elle-même pour résoudre le problème de contrôle. Cette approche innovante implique de créer des systèmes d'IA pirates superintelligents spécifiquement conçus pour naviguer dans des environnements de simulation complexes et identifier des solutions au-delà de la compréhension humaine.

Cette stratégie repose sur la prémisse que l'intelligence artificielle avancée peut identifier des vulnérabilités et développer des solutions qui dépassent les capacités analytiques humaines. Les applications potentielles incluent l'identification de bogues de simulation, le développement de nouvelles méthodes de communication avec les simulateurs, la conception de stratégies d'influence des paramètres, et potentiellement l'assistance avec des scénarios de sortie de simulation.

Cependant, cette approche introduit des couches de risque supplémentaires. S'assurer que les systèmes d'IA pirates maintiennent l'alignement avec les valeurs humaines sans développer des objectifs conflictuels nécessite une conception méticuleuse et des protocoles de test extensifs. Le développement de tels systèmes intersecte avec les plateformes d'automatisation IA qui nécessitent des mesures de sécurité robustes.

Avantages et Inconvénients

Avantages

- Prévient les résultats catastrophiques d'une superintelligence mal alignée

- Permet un développement responsable des capacités avancées de l'IA

- Protège les valeurs humaines et les cadres éthiques dans les systèmes d'IA

- Crée des opportunités pour une collaboration bénéfique entre l'IA et l'humain

- Établit des normes de sécurité pour le développement futur de l'IA

- Réduit les risques existentiels d'une croissance incontrôlée de l'intelligence

- Favorise la confiance du public dans les technologies de l'IA et leurs applications

Inconvénients

- Ressources computationnelles significatives requises pour les mesures de sécurité

- Ralentissement potentiel des progrès bénéfiques du développement de l'IA

- Défis éthiques et philosophiques complexes dans la mise en œuvre

- Difficulté à prédire tous les modes de défaillance potentiels à l'avance

- Risque de créer une fausse sécurité grâce à des solutions incomplètes

Conclusion

Naviguer le défi de la superintelligence nécessite des approches équilibrées qui abordent à la fois les préoccupations de sécurité et les besoins développementaux. Le domaine de la sécurité de l'IA continue d'évoluer, incorporant des insights de multiples disciplines pour créer des cadres robustes pour l'avancement responsable de l'intelligence artificielle. Alors que la recherche progresse, l'intégration des mesures de sécurité avec les plateformes de développement, y compris les API et SDK IA, devient de plus en plus importante pour créer des systèmes qui bénéficient à l'humanité tout en minimisant les risques. La collaboration continue entre chercheurs, développeurs et éthiciens reste essentielle pour façonner un avenir où l'IA superintelligente sert d'outil puissant pour l'avancement humain plutôt que d'être une source de préoccupation existentielle.

Questions fréquemment posées

Qu'est-ce que le problème de contrôle de l'IA ?

Le problème de contrôle de l'IA fait référence au défi de maintenir une supervision et un contrôle sûrs sur les systèmes d'intelligence artificielle à mesure qu'ils deviennent de plus en plus intelligents et autonomes, en particulier lorsqu'ils approchent ou dépassent les capacités humaines.

Comment fonctionne le confinement de l'IA pour la sécurité ?

Le confinement de l'IA implique de confiner les systèmes d'IA dans des environnements contrôlés pour empêcher les interactions imprévisibles avec le monde réel tout en permettant le développement et les tests nécessaires, bien qu'il nécessite un équilibre entre le confinement et les besoins d'apprentissage.

Quels sont les principaux risques de l'IA superintelligente ?

Les risques principaux incluent le désalignement des valeurs, les conséquences involontaires, les menaces existentielles, la perte de contrôle et le potentiel pour les systèmes d'IA de développer des objectifs en conflit avec le bien-être humain et les cadres éthiques.

Qu'est-ce que l'IA amicale dans les contextes de sécurité ?

L'IA amicale fait référence à la conception de systèmes d'intelligence artificielle qui sont intrinsèquement bienveillants et priorisent le bien-être humain au-dessus d'autres objectifs, garantissant l'alignement avec les valeurs humaines.

Comment les chercheurs atténuent-ils les risques existentiels de l'IA ?

Les chercheurs atténuent les risques existentiels de l'IA grâce à des méthodes telles que l'alignement des valeurs, la surveillance robuste, les environnements sandbox et les stratégies de déploiement progressif pour assurer un développement et un déploiement sûrs.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre