Annotation

- Introduction

- Histoire et fondamentaux de l'IA

- Étapes du workflow d'IA

- Outils de développement d'IA

- Avantages et inconvénients

- Conclusion

- Questions fréquemment posées

Guide du flux de travail IA : de la préparation des données aux stratégies de déploiement de modèles

Un guide complet des flux de travail IA couvrant la préparation des données, l'entraînement des modèles, l'optimisation et les stratégies de déploiement en utilisant des outils comme PyTorch.

Introduction

L'intelligence artificielle est passée d'un concept théorique à un outil pratique dans tous les secteurs. Comprendre les workflows d'IA – les processus systématiques qui guident le développement de l'IA des données brutes au déploiement en production – est essentiel pour construire des solutions d'IA efficaces. Ce guide complet explore chaque étape du cycle de vie de l'IA, fournissant des insights sur les outils, les techniques et les bonnes pratiques qui assurent une mise en œuvre réussie des projets d'apprentissage automatique et d'apprentissage profond.

Histoire et fondamentaux de l'IA

L'intelligence artificielle représente le vaste domaine de l'informatique axé sur la création de systèmes capables d'effectuer des tâches qui nécessitent généralement l'intelligence humaine. Cela englobe l'apprentissage, le raisonnement, la résolution de problèmes, la perception et la compréhension du langage. Le voyage a commencé dans les années 1950 avec des systèmes basés sur des règles qui suivaient des instructions de programmation explicites, mais l'IA moderne a évolué bien au-delà de ces limitations initiales.

La progression de l'IA symbolique aux systèmes avancés d'aujourd'hui représente des décennies de recherche et d'avancées technologiques. Les premiers systèmes d'IA luttaient avec la complexité du monde réel, mais l'émergence de l'apprentissage automatique a marqué un changement pivot vers des approches axées sur les données qui pouvaient s'adapter et s'améliorer avec le temps. Le paysage actuel de l'IA inclut des plateformes d'automatisation d'IA spécialisées qui rationalisent les processus de développement.

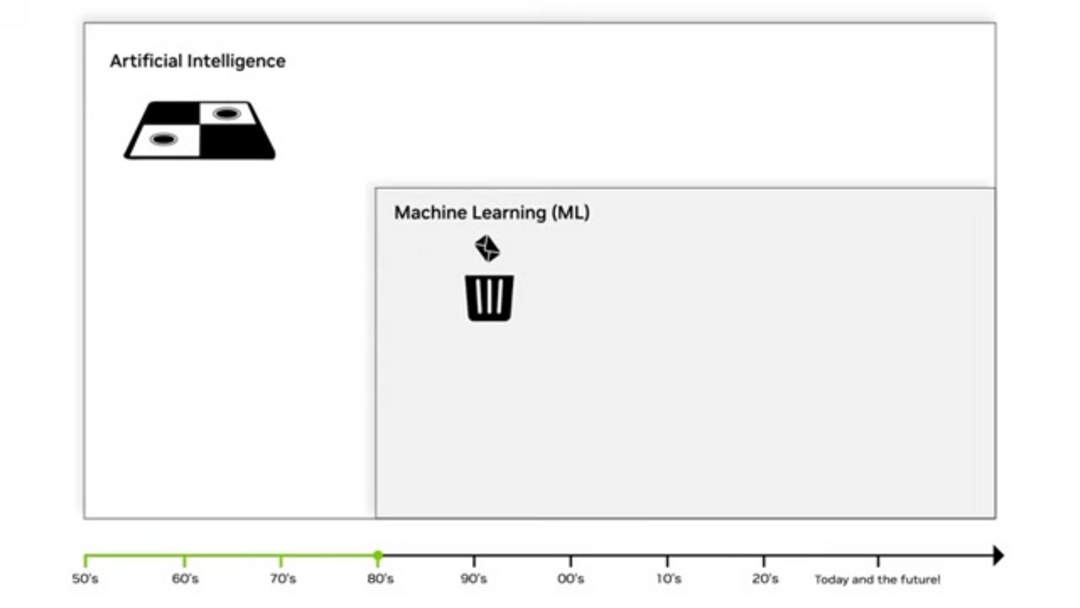

Apprentissage automatique : La révolution statistique

L'apprentissage automatique a émergé dans les années 1980 comme une approche transformative utilisant des méthodes statistiques pour permettre aux ordinateurs d'apprendre à partir de données sans programmation explicite. Contrairement aux logiciels traditionnels qui suivent des règles fixes, les algorithmes d'AM identifient des modèles et des relations dans les données pour faire des prédictions ou des décisions. Cette fondation statistique permet aux modèles d'améliorer leurs performances au fur et à mesure qu'ils traitent plus d'informations.

Les techniques clés de l'AM incluent la régression linéaire pour prédire des valeurs continues et les algorithmes de classification comme les arbres de décision pour des résultats catégoriels. L'approche du « sac de mots » a révolutionné l'analyse de texte en traitant les documents comme des collections non ordonnées de mots, permettant des applications comme le filtrage du spam et l'analyse des sentiments. Ces méthodes forment l'épine dorsale de nombreux outils d'écriture d'IA et systèmes de génération de contenu.

Apprentissage profond et réseaux de neurones

L'apprentissage profond représente une avancée significative dans l'apprentissage automatique, utilisant des réseaux de neurones multicouches pour apprendre automatiquement des caractéristiques à partir de données brutes. Le « profond » dans l'apprentissage profond fait référence aux multiples couches à travers lesquelles les données sont transformées, permettant au système d'apprendre des représentations de plus en plus abstraites. Cette approche élimine le besoin d'ingénierie manuelle des caractéristiques, qui était un goulot d'étranglement majeur dans l'apprentissage automatique traditionnel.

Trois facteurs clés ont conduit la révolution de l'apprentissage profond : le matériel GPU avancé qui a accéléré le calcul, les ensembles de données massifs provenant de sources numériques et les algorithmes d'entraînement améliorés. Les réseaux neuronaux profonds excellent dans des tâches complexes comme la reconnaissance d'images, le traitement du langage naturel et la reconnaissance vocale, alimentant les chatbots d'IA modernes et les assistants virtuels.

IA générative et applications modernes

L'IA générative représente la frontière actuelle, permettant aux systèmes de créer du contenu original plutôt que simplement analyser ou classer des données existantes. Les grands modèles de langage (LLM) comme GPT-4 démontrent des capacités remarquables dans la génération de texte semblable à celui d'un humain, tandis que les modèles de diffusion produisent des images de haute qualité à partir de descriptions textuelles. Cette capacité générative ouvre de nouvelles possibilités pour les applications créatives et la production de contenu.

Les applications modernes d'IA générative couvrent de multiples domaines, incluant la création de contenu automatisée, le marketing personnalisé, la génération de code et l'expression artistique. Ces systèmes apprennent les modèles et structures sous-jacents de leurs données d'entraînement, puis génèrent de nouveaux exemples qui suivent des modèles similaires. L'essor des générateurs d'images d'IA démontre l'impact pratique de ces technologies.

Étapes du workflow d'IA

Un workflow d'IA fournit un cadre structuré pour développer, déployer et maintenir des systèmes d'intelligence artificielle. Cette approche systématique assure la cohérence, la reproductibilité et l'efficacité tout au long du cycle de vie du projet. Un workflow bien défini inclut généralement des étapes de préparation des données, de développement de modèles, d'optimisation, de déploiement et de surveillance, chacune avec des tâches et des livrables spécifiques.

Suivre un workflow standardisé aide les équipes à gérer la complexité, suivre les progrès et maintenir la qualité tout au long du processus de développement. Cette approche structurée est particulièrement importante lorsqu'on travaille avec des environnements complexes d'hébergement de modèles d'IA et des pipelines de déploiement.

Préparation des données : Fondation du succès

La préparation des données transforme les données brutes et non structurées en un format propre et organisé adapté à l'entraînement des modèles. Cette phase critique consomme généralement 60 à 80 % du temps total du projet mais impacte directement les performances du modèle. Le principe « garbage in, garbage out » souligne que même des algorithmes sophistiqués ne peuvent compenser des données de mauvaise qualité.

Les étapes clés de préparation des données incluent la collecte de sources de données diverses, la gestion des valeurs manquantes via des techniques d'imputation, l'identification et le traitement des valeurs aberrantes, la standardisation des formats entre les ensembles de données et la suppression des enregistrements en double. L'ingénierie des caractéristiques crée de nouvelles variables à partir des données existantes, tandis que la normalisation assure une mise à l'échelle cohérente. Une préparation adéquate des données jette les bases d'une intégration efficace des API et SDK d'IA.

Entraînement des modèles et sélection d'algorithmes

L'entraînement des modèles implique d'enseigner aux algorithmes à reconnaître des modèles et des relations dans les ensembles de données préparés. Ce processus utilise l'optimisation mathématique pour ajuster les paramètres du modèle, minimisant la différence entre les prédictions et les résultats réels. Le choix de l'algorithme dépend du type de problème, des caractéristiques des données et des exigences de performance.

L'apprentissage supervisé utilise des exemples étiquetés pour entraîner des modèles de classification et de régression, tandis que l'apprentissage non supervisé identifie des modèles dans des données non étiquetées via le clustering et la réduction de dimensionnalité. L'apprentissage par renforcement entraîne des agents par des interactions essai-erreur avec des environnements. Chaque approche nécessite différentes stratégies d'entraînement et métriques d'évaluation pour assurer des performances robustes.

Techniques d'optimisation des modèles

L'optimisation des modèles affine les modèles entraînés pour améliorer les performances, l'efficacité et l'adéquation au déploiement. Ce processus itératif aborde des problèmes comme le surajustement, où les modèles performent bien sur les données d'entraînement mais mal sur de nouveaux exemples. L'optimisation équilibre la complexité du modèle avec la capacité de généralisation pour obtenir les meilleurs résultats pratiques.

Les techniques d'optimisation courantes incluent le réglage des hyperparamètres pour trouver des taux d'apprentissage et des architectures de réseau optimaux, l'élagage des modèles pour supprimer des paramètres inutiles, la quantification pour réduire la précision pour une inférence plus rapide et la distillation des connaissances pour transférer l'apprentissage de grands modèles à des versions plus petites et plus efficaces. Ces techniques sont essentielles pour préparer les modèles aux environnements de production et aux applications d'agents et assistants d'IA.

Stratégies de déploiement et d'inférence

Le déploiement déplace les modèles entraînés des environnements de développement vers des systèmes de production où ils peuvent générer des prédictions sur de nouvelles données. Cette phase nécessite une considération attentive de la latence d'inférence (temps de réponse), du débit (requêtes traitées par seconde) et de l'évolutivité (gestion de la charge accrue). Un déploiement réussi assure que les modèles délivrent de la valeur dans des applications réelles.

Les stratégies de déploiement vont des simples API REST aux architectures de microservices complexes avec mise à l'échelle automatique. Les systèmes de surveillance suivent les performances des modèles, la dérive des données et la dérive des concepts pour maintenir la précision dans le temps. Les pipelines d'intégration et de déploiement continus automatisent les mises à jour et assurent la cohérence entre les environnements.

Outils de développement d'IA

Les outils essentiels rationalisent le développement de l'IA, du traitement des données au déploiement. Les plateformes clés incluent RAPIDS pour la science des données accélérée, PyTorch et TensorFlow pour l'apprentissage profond, et les solutions NVIDIA pour l'inférence optimisée.

RAPIDS pour le traitement accéléré des données

RAPIDS fournit des bibliothèques de science des données accélérées par GPU qui accélèrent considérablement la préparation et l'analyse des données. Construit sur Apache Arrow, RAPIDS offre des interfaces Python familières tout en exploitant les capacités de traitement parallèle des GPU modernes. La bibliothèque cuDF fournit une fonctionnalité de type pandas pour la manipulation des données, tandis que cuML accélère les algorithmes d'apprentissage automatique.

Frameworks PyTorch et TensorFlow

PyTorch et TensorFlow dominent le paysage de l'apprentissage profond avec des forces complémentaires. PyTorch met l'accent sur la flexibilité et le débogage intuitif grâce à des graphes de calcul dynamiques, le rendant populaire pour la recherche et le prototypage. TensorFlow offre des capacités de déploiement prêtes pour la production avec des outils robustes et un support communautaire étendu.

NVIDIA TensorRT pour l'optimisation de l'inférence

TensorRT optimise les modèles entraînés pour une inférence haute performance sur le matériel NVIDIA. Grâce à des techniques comme la fusion de couches, la calibration de précision et l'auto-réglage des noyaux, TensorRT peut réaliser des améliorations de vitesse significatives sans sacrifier la précision. La plateforme prend en charge les modèles de multiples frameworks via l'interopérabilité ONNX.

Serveur d'inférence NVIDIA Triton

Le serveur d'inférence Triton fournit une plateforme unifiée pour déployer des modèles de multiples frameworks simultanément. Son architecture flexible prend en charge divers types de modèles, configurations de traitement par lots et modèles d'ensemble. Triton simplifie la complexité du déploiement tout en maximisant l'utilisation du matériel grâce à une planification intelligente et une exécution concurrente.

Avantages et inconvénients

Avantages

- Automatise efficacement les processus de prise de décision complexes

- Améliore la précision et la cohérence par rapport aux opérateurs humains

- Évolue pour gérer des ensembles de données massifs et des exigences de calcul

- Fournit des insights basés sur les données et des capacités prédictives

- Permet des expériences et recommandations personnalisées

- Réduit les coûts opérationnels grâce à l'automatisation

- Accélère les cycles d'innovation et de développement de produits

Inconvénients

- Nécessite des ressources informatiques et une infrastructure significatives

- Dépend de données d'entraînement de haute qualité et représentatives

- Complexe à implémenter, maintenir et mettre à jour correctement

- Potentiel de résultats biaisés basés sur les données d'entraînement

- La nature de boîte noire peut rendre les décisions difficiles à interpréter

Conclusion

Maîtriser les workflows d'IA fournit la base pour une mise en œuvre réussie de l'intelligence artificielle dans tous les secteurs. De la préparation minutieuse des données au déploiement optimisé, chaque étape contribue à construire des systèmes d'IA fiables et efficaces. L'écosystème d'outils en évolution – incluant RAPIDS, PyTorch, TensorFlow, TensorRT et Triton – continue d'abaisser les barrières tout en augmentant les capacités. Alors que les technologies d'IA avancent, comprendre ces workflows devient de plus en plus essentiel pour les organisations cherchant à tirer parti de l'intelligence artificielle pour un avantage concurrentiel et l'innovation.

Questions fréquemment posées

Quelle est l'étape la plus critique dans les flux de travail IA ?

La préparation des données est souvent considérée comme l'étape la plus critique car la performance du modèle dépend directement de la qualité, de l'exhaustivité et de la pertinence des données. Des données médiocres conduisent à des modèles peu fiables, quelle que soit la sophistication de l'algorithme.

Comment RAPIDS améliore-t-il les flux de travail IA ?

RAPIDS accélère la préparation et le traitement des données en utilisant le parallélisme GPU, réduisant le temps de traitement de plusieurs heures à quelques minutes tout en conservant des interfaces Python familières pour les scientifiques des données.

Quelle est la différence entre PyTorch et TensorFlow ?

PyTorch utilise des graphes de calcul dynamiques pour la flexibilité et le débogage, tandis que TensorFlow met l'accent sur le déploiement en production avec des graphes statiques et une vaste gamme d'outils. Les deux sont des cadres puissants avec des forces différentes.

Pourquoi l'optimisation des modèles est-elle importante ?

L'optimisation améliore l'efficacité du modèle, réduit les besoins en calcul et améliore la vitesse d'inférence tout en maintenant la précision – crucial pour le déploiement en production et l'expérience utilisateur.

Que fournit Triton Inference Server ?

Triton fournit un déploiement unifié pour plusieurs modèles de frameworks, prenant en charge l'exécution concurrente, le traitement par lots dynamique et les modèles d'ensemble tout en maximisant l'utilisation du matériel grâce à une planification intelligente.

Articles pertinents sur l'IA et les tendances technologiques

Restez à jour avec les dernières informations, outils et innovations qui façonnent l'avenir de l'IA et de la technologie.

Grok AI : Génération Illimitée de Vidéos Gratuite à partir de Texte et d'Images | Guide 2024

Grok AI propose une génération illimitée de vidéos gratuite à partir de texte et d'images, rendant la création de vidéos professionnelles accessible à tous sans compétences en montage.

Configuration de Grok 4 Fast sur Janitor AI : Guide Complet de Jeu de Rôle Sans Filtre

Guide étape par étape pour configurer Grok 4 Fast sur Janitor AI pour un jeu de rôle sans restriction, incluant la configuration de l'API, les paramètres de confidentialité et les conseils d'optimisation

Top 3 des extensions de codage IA gratuites pour VS Code 2025 - Boostez votre productivité

Découvrez les meilleures extensions d'agents de codage IA gratuites pour Visual Studio Code en 2025, y compris Gemini Code Assist, Tabnine et Cline, pour améliorer votre