Annotation

- Введение

- Понимание эволюции роли QA в тестировании ИИ

- Объяснение больших языковых моделей для специалистов по QA

- Основные области тестирования для обеспечения качества LLM

- Практическая реализация инструментов тестирования ИИ

- Реальные приложения и случаи использования

- Плюсы и минусы

- Заключение

- Часто задаваемые вопросы

Руководство для инженеров QA по тестированию LLM: стратегии обеспечения качества ИИ

Всеобъемлющее руководство для инженеров QA по тестированию больших языковых моделей со стратегиями тестирования промптов, автоматизации и обнаружения смещений

Введение

По мере того как искусственный интеллект преобразует разработку программного обеспечения, специалисты по обеспечению качества сталкиваются с новыми вызовами в тестировании больших языковых моделей. Это всеобъемлющее руководство исследует, как инженеры по QA могут адаптировать свои навыки для эффективной оценки систем ИИ, не становясь экспертами по машинному обучению. Узнайте практические стратегии для тестирования промптов, фреймворков автоматизации и обнаружения смещений, которые сохранят актуальность ваших навыков тестирования в эпоху ИИ.

Понимание эволюции роли QA в тестировании ИИ

Сдвиг от валидации кода к оценке поведения ИИ

Появление сложных инструментов ИИ, таких как ChatGPT и Google Gemini, фундаментально изменило то, что означает обеспечение качества для современных приложений. Вместо того чтобы сосредотачиваться исключительно на традиционной валидации кода, инженерам по QA теперь необходимо оценивать, как системы ИИ ведут себя, реагируют и адаптируются к различным входам. Это представляет собой значительный сдвиг парадигмы, где тестирование искусственного интеллекта требует иных методологий, чем обычное тестирование программного обеспечения.

Хотя некоторые специалисты по QA беспокоятся о необходимости глубоких знаний в машинном обучении, реальность более нюансирована. Вам не нужно понимать сложную математику, стоящую за архитектурами трансформеров или оптимизацией градиентного спуска. Вместо этого сосредоточьтесь на понимании того, как LLM обрабатывают информацию и генерируют ответы. Этот практический подход позволяет выявлять потенциальные проблемы, не увязая в технических сложностях, которые лучше оставить специалистам по ML.

Основной принцип для QA в тестировании ИИ — понимание того, что вы оцениваете поведение, а не просто проверяете выходы кода. Это означает разработку тестовых случаев, которые исследуют, как модель реагирует на крайние случаи, неоднозначные промпты и потенциально смещенные входные данные. Многие организации добиваются успеха со специализированными инструментами тестирования и QA для ИИ, которые помогают преодолеть разрыв между традиционным тестированием и оценкой ИИ.

Объяснение больших языковых моделей для специалистов по QA

Что инженерам по QA нужно знать об основах LLM

Большие языковые модели — это системы ИИ, обученные на огромных наборах данных, содержащих книги, статьи, веб-сайты и другие текстовые источники. Эти модели изучают закономерности в человеческом языке, что позволяет им понимать контекст, генерировать связные ответы и адаптироваться к конкретным инструкциям. Для инженеров по QA наиболее важная концепция заключается в том, что LLM не «думают» в человеческом смысле — они предсказывают наиболее вероятные следующие слова на основе своих обучающих данных.

Когда вы взаимодействуете с LLM через платформы, такие как AI чат-боты, вы предоставляете промпт, который модель использует для генерации ответа. Качество и специфичность этого промпта напрямую влияют на качество вывода. Инженерам по QA следует понимать базовые концепции, такие как токены (единицы текста, которые обрабатывает модель), контекстные окна (сколько текста модель может учитывать одновременно) и настройки температуры (которые контролируют креативность ответа).

Ключевые характеристики, влияющие на тестирование QA, включают:

- Недетерминированное поведение: В отличие от традиционного программного обеспечения, LLM могут предоставлять разные ответы на идентичные промпты

- Чувствительность к контексту: Небольшие изменения в формулировке могут производить dramatically разные выходные данные

- Ограничения знаний: Модели имеют даты отсечения и могут не знать недавнюю информацию

- Риск галлюцинаций: LLM могут генерировать правдоподобную, но неверную информацию

Основные области тестирования для обеспечения качества LLM

Комплексные стратегии тестирования промптов

Тестирование промптов включает систематическую оценку того, как LLM реагируют на различные типы входных данных. Это выходит за рамки простого функционального тестирования, чтобы исследовать, как модель обрабатывает неоднозначные запросы, сложные инструкции и крайние случаи. Эффективное тестирование промптов должно включать:

- Тестирование разнообразия: Использование разных формулировок, стилей и форматов для похожих запросов

- Граничное тестирование: Нажатие на пределы того, что модель может эффективно обработать

- Адверсариальное тестирование: Попытки обмануть или запутать модель вводящими в заблуждение промптами

- Тестирование контекста: Оценка того, насколько хорошо модель сохраняет контекст в ходе множественных обменов

Инструменты из категорий инструментов AI промптов могут помочь автоматизировать и масштабировать этот процесс тестирования.

Расширенные метрики оценки для ответов ИИ

Традиционное тестирование прошел/не прошел плохо работает для оценки LLM, потому что ответы существуют в спектре качества. Инженерам по QA необходимо применять сложные метрики, которые измеряют:

- Точность: Фактическая правильность предоставленной информации

- Релевантность: Насколько хорошо ответ соответствует исходному промпту

- Связность: Логический поток и читаемость сгенерированного текста

- Безопасность: Отсутствие вредного, смещенного или неподобающего контента

- Полнота: Полностью ли ответ отвечает на запрос

Внедрение фреймворков автоматизации

Использование автоматизации крайне важно для эффективного тестирования LLM. Популярные фреймворки, такие как LangChain, PromptLayer и OpenAI Evals, предоставляют структурированные подходы к созданию, управлению и выполнению тестовых наборов. Эти инструменты помогают инженерам по QA:

- Создавать воспроизводимые тестовые сценарии с последовательными критериями оценки

- Масштабировать тестирование на несколько версий моделей и конфигураций

- Отслеживать изменения производительности со временем с детальными метриками

- Интегрировать тестирование ИИ в существующие CI/CD конвейеры

Многие команды выигрывают от изучения платформ автоматизации ИИ, которые предлагают комплексные решения для тестирования.

Обнаружение смещений и крайних случаев

Эта критическая область фокусируется на выявлении и смягчении смещений, обеспечивая при этом надежную работу модели в различных сценариях. Эффективное тестирование на смещения должно исследовать:

- Демографические смещения, связанные с полом, этнической принадлежностью, возрастом или местоположением

- Культурные предположения, которые могут исключать или искажать группы

- Политическую или идеологическую склонность в ответах на спорные темы

- Вариации производительности на разных языках и диалектах

Практическая реализация инструментов тестирования ИИ

Пошаговое руководство по автоматизации тестирования ИИ

Реализация эффективного тестирования ИИ требует структурированного подхода, который балансирует автоматизацию с человеческим надзором. Следуйте этим шагам, чтобы построить надежный фреймворк тестирования:

- Выбор инструментов: Выбирайте инструменты автоматизации, которые соответствуют вашим конкретным потребностям в тестировании и хорошо интегрируются с вашей существующей инфраструктурой. Учитывайте такие факторы, как поддерживаемые модели, цены и кривая обучения.

- Разработка тестового набора: Создавайте комплексные тестовые наборы, охватывающие различные типы промптов, ожидаемые выходные данные и критерии оценки. Включайте как позитивные, так и негативные тестовые случаи.

- Интеграция непрерывного тестирования: Включайте тестирование ИИ в ваши регулярные циклы разработки, запуская автоматизированные тесты с каждым обновлением модели или изменением конфигурации.

- Мониторинг производительности: Установите базовые метрики и отслеживайте отклонения, которые могут указывать на деградацию модели или новые проблемы.

- Интеграция обратной связи пользователей: Включайте реальные взаимодействия пользователей и обратную связь в вашу стратегию тестирования, чтобы выявлять паттерны и общие точки сбоев.

Платформы в категории AI API и SDK часто предоставляют строительные блоки для пользовательских решений тестирования.

Реальные приложения и случаи использования

Практические сценарии тестирования LLM в различных отраслях

Тестирование LLM применяется к многочисленным реальным приложениям, где системы ИИ взаимодействуют с пользователями или обрабатывают информацию. Общие тестовые сценарии включают:

- Чат-боты службы поддержки: Обеспечение того, что ответы точны, полезны и поддерживают соответствующий тон при разнообразных запросах и эмоциональных состояниях клиентов

- Системы генерации контента: Проверка того, что сгенерированные ИИ статьи, маркетинговые тексты или посты в социальных сетях фактологически правильны, оригинальны и соответствуют бренду

- Инструменты генерации кода: Тестирование того, что программирование с помощью ИИ производит функциональный, безопасный и эффективный код на разных языках и фреймворках

- Сервисы перевода: Валидация точности, культурной уместности и беглости в переводах на основе ИИ для различных языковых пар

- Образовательные приложения: Обеспечение того, что ИИ-тьюторы предоставляют правильную информацию, соответствующие объяснения и адаптивную поддержку обучения

Многие из этих приложений используют инструменты разговорного ИИ, которые требуют специализированных подходов к тестированию.

Плюсы и минусы

Преимущества

- Улучшенная способность предвидеть и выявлять ограничения моделей ИИ

- Улучшенное сотрудничество с командами инженеров по машинному обучению

- Повышенная ценность и актуальность в проектах разработки на основе ИИ

- Более эффективное проектирование тестов через понимание поведения модели

- Лучшие карьерные возможности в растущей области обеспечения качества ИИ

- Способность выявлять тонкие проблемы, которые традиционное тестирование может пропустить

- Более сильная позиция для оценки сторонних интеграций ИИ

Недостатки

- Значительные временные затраты, необходимые для изучения новых концепций

- Потенциальное отвлечение от основных обязанностей и навыков QA

- Повышенная сложность в планировании тестов и рабочих процессах выполнения

- Риск чрезмерного фокусирования на технических деталях ИИ, а не на пользовательском опыте

- Дополнительные требования к инструментам и инфраструктуре для надлежащего тестирования

Заключение

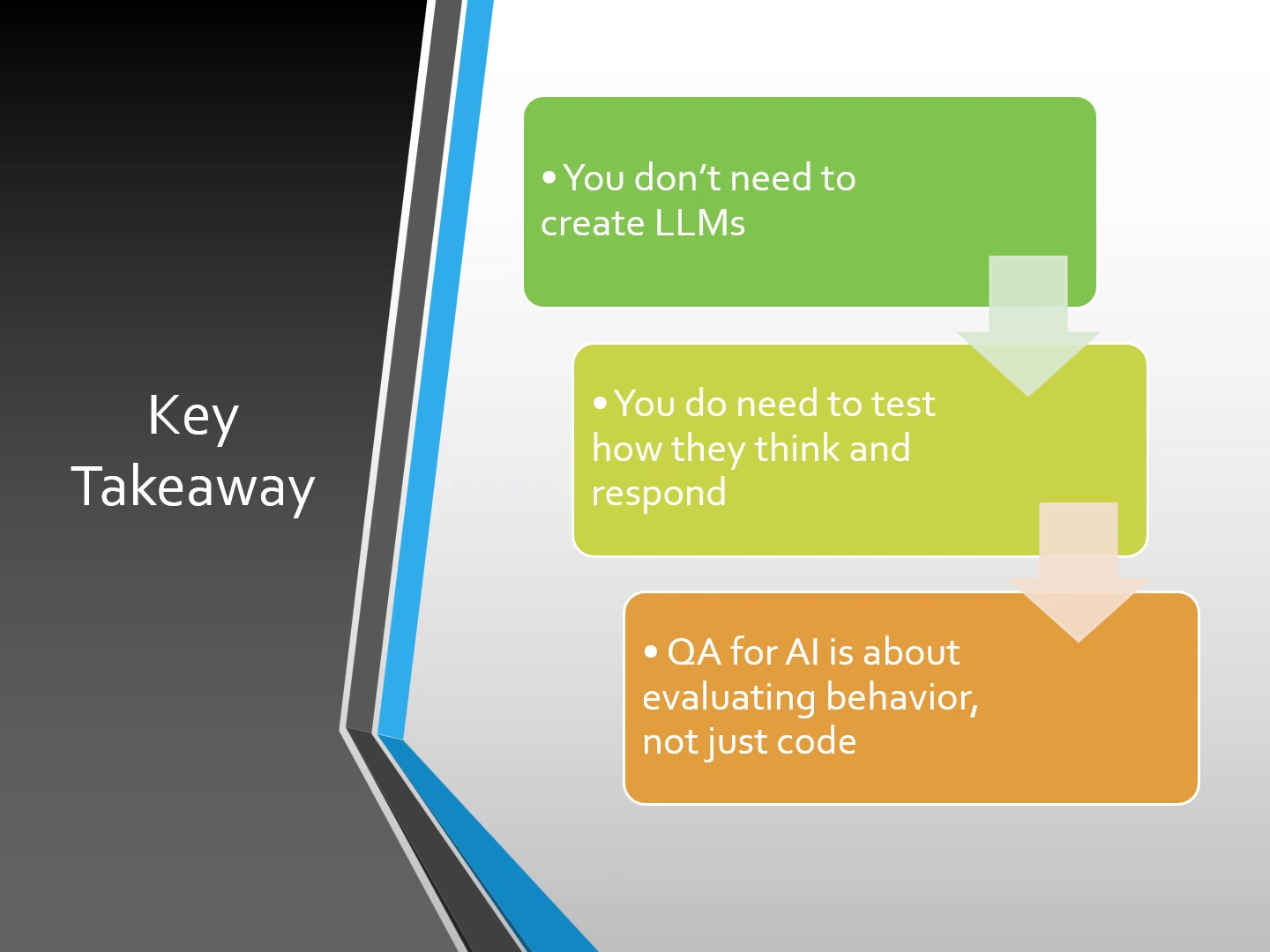

Инженерам по QA не нужно становиться экспертами по машинному обучению, чтобы эффективно тестировать большие языковые модели, но им необходимо адаптировать свой подход, чтобы сосредоточиться на оценке поведения ИИ. Сосредоточившись на тестировании промптов, метриках оценки, инструментах автоматизации и обнаружении смещений, специалисты по QA могут обеспечить надежность, безопасность и эффективность систем ИИ. Ключ в развитии практического понимания того, как работают LLM, а не в овладении их техническим построением. Поскольку ИИ продолжает преобразовывать разработку программного обеспечения, инженеры по QA, которые принимают эти новые методологии тестирования, останутся ценными участниками обеспечения качества в эпоху искусственного интеллекта.

Часто задаваемые вопросы

Нужны ли инженерам QA знания в области машинного обучения для тестирования LLM?

Нет, инженерам QA не нужны глубокие знания в области машинного обучения. Сосредоточьтесь на понимании поведения LLM, тестировании промптов, метриках оценки и использовании инструментов автоматизации, а не на создании моделей с нуля.

Каковы ключевые области для инженеров QA, тестирующих модели ИИ?

Четыре критически важные области включают всестороннее тестирование промптов, расширенные метрики оценки, внедрение автоматизированных фреймворков и систематическое обнаружение смещений и граничных случаев.

Какие инструменты автоматизации наиболее полезны для тестирования LLM?

Популярные инструменты включают LangChain для оркестрации рабочих процессов, PromptLayer для управления промптами и OpenAI Evals для стандартизированного тестирования и метрик оценки.

Чем тестирование ИИ отличается от традиционного тестирования программного обеспечения?

Тестирование ИИ фокусируется на оценке поведения и ответов, а не только на выходных данных кода, имеет дело с недетерминированными результатами и требует других метрик оценки.

Какие основные концепции LLM должны понимать инженеры QA?

Поймите токены, промпты, контекстные окна, настройки температуры и тонкую настройку, чтобы лучше предсказывать поведение модели и выявлять потенциальные проблемы.

Релевантные статьи об ИИ и технологических трендах

Будьте в курсе последних инсайтов, инструментов и инноваций, формирующих будущее ИИ и технологий.

Grok AI: Бесплатное неограниченное создание видео из текста и изображений | Руководство 2024

Grok AI предлагает бесплатное неограниченное создание видео из текста и изображений, делая профессиональное создание видео доступным для всех без навыков редактирования.

Настройка Grok 4 Fast в Janitor AI: Полное руководство по ролевой игре без фильтров

Пошаговое руководство по настройке Grok 4 Fast в Janitor AI для неограниченной ролевой игры, включая настройку API, параметры конфиденциальности и советы по оптимизации

Топ-3 бесплатных расширений для ИИ-программирования в VS Code 2025 - Повышение производительности

Откройте для себя лучшие бесплатные расширения для ИИ-программирования в Visual Studio Code в 2025 году, включая Gemini Code Assist, Tabnine и Cline, чтобы улучшить вашу