Annotation

- Введение

- История и основы ИИ

- Этапы рабочего процесса ИИ

- Инструменты разработки ИИ

- Плюсы и минусы

- Заключение

- Часто задаваемые вопросы

Руководство по рабочим процессам ИИ: от подготовки данных до стратегий развертывания моделей

Полное руководство по рабочим процессам ИИ, охватывающее подготовку данных, обучение моделей, оптимизацию и стратегии развертывания с использованием таких инструментов, как PyTorch.

Введение

Искусственный интеллект превратился из теоретической концепции в практический инструмент во всех отраслях. Понимание рабочих процессов ИИ – систематических процессов, которые направляют разработку ИИ от сырых данных до развертывания в производстве – необходимо для создания эффективных решений ИИ. Это всеобъемлющее руководство исследует каждый этап жизненного цикла ИИ, предоставляя информацию о инструментах, методах и лучших практиках, которые обеспечивают успешную реализацию проектов машинного обучения и глубокого обучения.

История и основы ИИ

Искусственный интеллект представляет собой широкую область компьютерных наук, ориентированную на создание систем, способных выполнять задачи, которые обычно требуют человеческого интеллекта. Это включает обучение, рассуждение, решение проблем, восприятие и понимание языка. Путешествие началось в 1950-х годах с систем на основе правил, которые следовали явным программным инструкциям, но современный ИИ значительно эволюционировал за этими ранними ограничениями.

Прогресс от символического ИИ до современных передовых систем представляет десятилетия исследований и технологического прогресса. Ранние системы ИИ боролись со сложностью реального мира, но появление машинного обучения ознаменовало ключевой сдвиг в сторону подходов, основанных на данных, которые могли адаптироваться и улучшаться со временем. Современный ландшафт ИИ включает специализированные платформы автоматизации ИИ, которые упрощают процессы разработки.

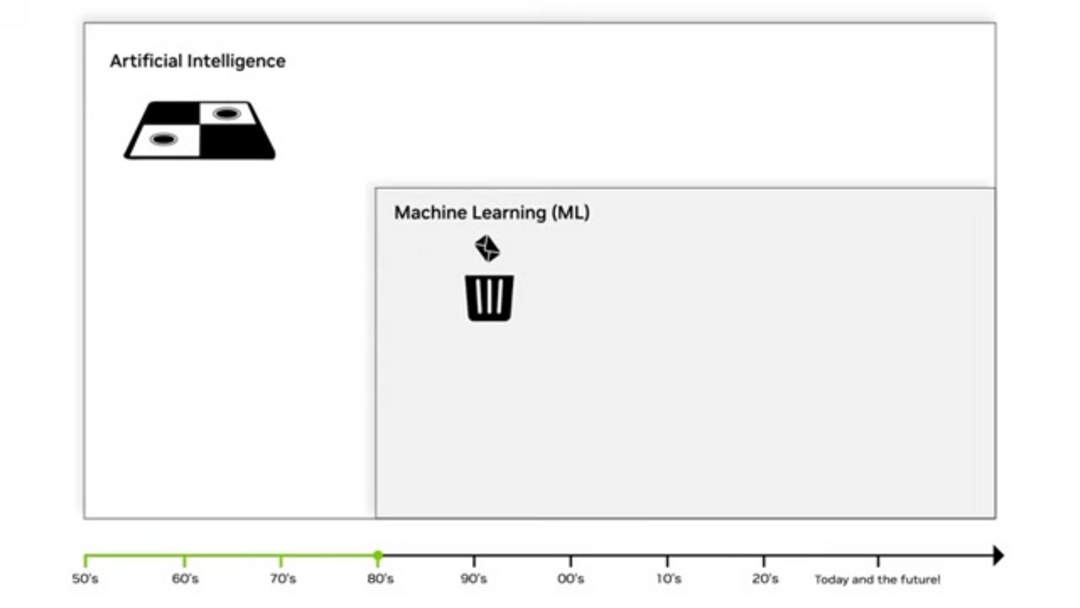

Машинное обучение: Статистическая революция

Машинное обучение появилось в 1980-х годах как преобразующий подход, который использует статистические методы, чтобы позволить компьютерам обучаться на данных без явного программирования. В отличие от традиционного программного обеспечения, которое следует фиксированным правилам, алгоритмы МО идентифицируют паттерны и отношения в данных, чтобы делать прогнозы или решения. Эта статистическая основа позволяет моделям улучшать свою производительность по мере обработки большего количества информации.

Ключевые техники МО включают линейную регрессию для прогнозирования непрерывных значений и алгоритмы классификации, такие как деревья решений, для категориальных исходов. Подход "мешок слов" революционизировал анализ текста, рассматривая документы как неупорядоченные коллекции слов, позволяя приложениям, такие как фильтрация спама и анализ настроений. Эти методы формируют основу многих инструментов написания ИИ и систем генерации контента.

Глубокое обучение и нейронные сети

Глубокое обучение представляет значительное продвижение в машинном обучении, используя многослойные нейронные сети для автоматического обучения признакам из сырых данных. "Глубокое" в глубоком обучении относится к множественным слоям, через которые данные преобразуются, позволяя системе изучать все более абстрактные представления. Этот подход устраняет необходимость ручного инжиниринга признаков, который был основным узким местом в традиционном машинном обучении.

Три ключевых фактора двигали революцию глубокого обучения: продвинутое GPU-оборудование, которое ускорило вычисления, массивные наборы данных из цифровых источников и улучшенные алгоритмы обучения. Глубокие нейронные сети преуспевают в сложных задачах, таких как распознавание изображений, обработка естественного языка и распознавание речи, питая современные чат-боты ИИ и виртуальные помощники.

Генеративный ИИ и современные приложения

Генеративный ИИ представляет текущий фронт, позволяя системам создавать оригинальный контент, а не просто анализировать или классифицировать существующие данные. Большие языковые модели (LLM), такие как GPT-4, демонстрируют замечательные возможности в генерации текста, похожего на человеческий, в то время как диффузионные модели производят высококачественные изображения из текстовых описаний. Эта генеративная способность открывает новые возможности для творческих приложений и производства контента.

Современные генеративные приложения ИИ охватывают несколько доменов, включая автоматизированное создание контента, персонализированный маркетинг, генерацию кода и художественное выражение. Эти системы изучают основные паттерны и структуры своих обучающих данных, затем генерируют новые примеры, которые следуют похожим паттернам. Подъем генераторов изображений ИИ демонстрирует практическое воздействие этих технологий.

Этапы рабочего процесса ИИ

Рабочий процесс ИИ предоставляет структурированную рамку для разработки, развертывания и поддержки систем искусственного интеллекта. Этот систематический подход обеспечивает согласованность, воспроизводимость и эффективность на протяжении всего жизненного цикла проекта. Хорошо определенный рабочий процесс типично включает этапы подготовки данных, разработки модели, оптимизации, развертывания и мониторинга, каждый с конкретными задачами и результатами.

Следование стандартизированному рабочему процессу помогает командам управлять сложностью, отслеживать прогресс и поддерживать качество на протяжении всего процесса разработки. Этот структурированный подход особенно важен при работе со сложными средами хостинга моделей ИИ и конвейерами развертывания.

Подготовка данных: Фонд для успеха

Подготовка данных преобразует сырые, неструктурированные данные в чистый, организованный формат, подходящий для обучения модели. Эта критическая фаза типично потребляет 60-80% общего времени проекта, но напрямую влияет на производительность модели. Принцип "мусор на входе, мусор на выходе" подчеркивает, что даже сложные алгоритмы не могут компенсировать данные низкого качества.

Ключевые шаги подготовки данных включают сбор разнообразных источников данных, обработку пропущенных значений через техники импутации, идентификацию и устранение выбросов, стандартизацию форматов across наборов данных и удаление дублирующих записей. Инжиниринг признаков создает новые переменные из существующих данных, в то время как нормализация обеспечивает consistent scaling. Правильная подготовка данных закладывает основу для эффективной интеграции API и SDK ИИ.

Обучение модели и выбор алгоритма

Обучение модели включает обучение алгоритмов распознавать паттерны и отношения в подготовленных наборах данных. Этот процесс использует математическую оптимизацию для настройки параметров модели, минимизируя разницу между прогнозами и фактическими исходами. Выбор алгоритма зависит от типа проблемы, характеристик данных и требований к производительности.

Обучение с учителем использует размеченные примеры для обучения моделей классификации и регрессии, в то время как обучение без учителя идентифицирует паттерны в неразмеченных данных через кластеризацию и уменьшение размерности. Обучение с подкреплением тренирует агентов через пробные и ошибочные взаимодействия с окружениями. Каждый подход требует различных стратегий обучения и метрик оценки, чтобы обеспечить robust производительность.

Техники оптимизации модели

Оптимизация модели тонко настраивает обученные модели, чтобы улучшить производительность, эффективность и пригодность для развертывания. Этот итеративный процесс решает проблемы, такие как переобучение, где модели хорошо работают на обучающих данных, но плохо на новых примерах. Оптимизация балансирует сложность модели с обобщающей способностью, чтобы достичь лучших практических результатов.

Общие техники оптимизации включают настройку гиперпараметров для нахождения оптимальных скоростей обучения и архитектур сети, обрезку модели для удаления ненужных параметров, квантование для уменьшения точности для более быстрого вывода и дистилляцию знаний для передачи обучения от больших моделей к меньшим, более эффективным версиям. Эти техники необходимы для подготовки моделей для производственных сред и приложений агентов и помощников ИИ.

Стратегии развертывания и вывода

Развертывание перемещает обученные модели из сред разработки в производственные системы, где они могут генерировать прогнозы на новых данных. Эта фаза требует тщательного рассмотрения задержки вывода (время ответа), пропускной способности (запросов, обработанных в секунду) и масштабируемости (обработка увеличенной нагрузки). Успешное развертывание обеспечивает, что модели доставляют ценность в реальных приложениях.

Стратегии развертывания варьируются от простых REST API до сложных архитектур микросервисов с автоматическим масштабированием. Системы мониторинга отслеживают производительность модели, дрейф данных и концептуальный дрейф, чтобы поддерживать точность со временем. Конвейеры непрерывной интеграции и развертывания автоматизируют обновления и обеспечивают согласованность across сред.

Инструменты разработки ИИ

Основные инструменты упрощают разработку ИИ, от обработки данных до развертывания. Ключевые платформы включают RAPIDS для ускоренной науки о данных, PyTorch и TensorFlow для глубокого обучения и решения NVIDIA для оптимизированного вывода.

RAPIDS для ускоренной обработки данных

RAPIDS предоставляет GPU-ускоренные библиотеки для науки о данных, которые значительно ускоряют подготовку и анализ данных. Построенные на Apache Arrow, RAPIDS предлагает знакомые интерфейсы Python, используя возможности параллельной обработки современных GPU. Библиотека cuDF предоставляет функциональность, похожую на pandas, для манипуляции данными, в то время как cuML ускоряет алгоритмы машинного обучения.

Фреймворки PyTorch и TensorFlow

PyTorch и TensorFlow доминируют в ландшафте глубокого обучения с дополнительными сильными сторонами. PyTorch подчеркивает гибкость и интуитивную отладку через динамические графы вычислений, делая его популярным для исследований и прототипирования. TensorFlow предлагает готовые к производству возможности развертывания с robust инструментарием и обширной поддержкой сообщества.

NVIDIA TensorRT для оптимизации вывода

TensorRT оптимизирует обученные модели для высокопроизводительного вывода на оборудовании NVIDIA. Через техники, такие как слияние слоев, калибровка точности и авто-настройка ядер, TensorRT может достигать значительных улучшений скорости без жертвования точностью. Платформа поддерживает модели из multiple фреймворков через ONNX interoperability.

Сервер вывода NVIDIA Triton

Сервер вывода Triton предоставляет унифицированную платформу для развертывания моделей из multiple фреймворков одновременно. Его гибкая архитектура поддерживает разнообразные типы моделей, конфигурации пакетной обработки и ансамблевые модели. Triton упрощает сложность развертывания, максимизируя использование оборудования через интеллектуальное планирование и параллельное выполнение.

Плюсы и минусы

Преимущества

- Эффективно автоматизирует сложные процессы принятия решений

- Улучшает точность и согласованность по сравнению с человеческими операторами

- Масштабируется для обработки массивных наборов данных и требований вычислений

- Предоставляет данные-ориентированные инсайты и прогностические возможности

- Позволяет персонализированные опыты и рекомендации

- Снижает операционные затраты через автоматизацию

- Ускоряет инновации и циклы разработки продукта

Недостатки

- Требует значительных вычислительных ресурсов и инфраструктуры

- Зависит от высококачественных, репрезентативных обучающих данных

- Сложно реализовать, поддерживать и обновлять properly

- Потенциал для предвзятых исходов на основе обучающих данных

- Природа черного ящика может делать решения трудными для интерпретации

Заключение

Освоение рабочих процессов ИИ предоставляет основу для успешной реализации искусственного интеллекта во всех отраслях. От тщательной подготовки данных через оптимизированное развертывание, каждый этап способствует построению надежных, эффективных систем ИИ. Эволюционирующая экосистема инструментов – включая RAPIDS, PyTorch, TensorFlow, TensorRT и Triton – продолжает снижать барьеры, увеличивая возможности. Поскольку технологии ИИ продвигаются, понимание этих рабочих процессов становится все более essential для организаций, стремящихся использовать искусственный интеллект для конкурентного преимущества и инноваций.

Часто задаваемые вопросы

Какой самый критический шаг в рабочих процессах ИИ?

Подготовка данных часто считается самым критическим шагом, потому что производительность модели напрямую зависит от качества, полноты и релевантности данных. Плохие данные приводят к ненадежным моделям независимо от сложности алгоритма.

Как RAPIDS улучшает рабочие процессы ИИ?

RAPIDS ускоряет подготовку и обработку данных, используя параллелизм GPU, сокращая время обработки с часов до минут, сохраняя при этом знакомые интерфейсы Python для специалистов по данным.

В чем разница между PyTorch и TensorFlow?

PyTorch использует динамические графы вычислений для гибкости и отладки, в то время как TensorFlow делает акцент на производственном развертывании со статическими графами и обширными инструментами. Оба являются мощными фреймворками с разными преимуществами.

Почему важна оптимизация моделей?

Оптимизация повышает эффективность модели, снижает вычислительные требования и увеличивает скорость вывода, сохраняя точность – что критически важно для производственного развертывания и пользовательского опыта.

Что предоставляет Triton Inference Server?

Triton обеспечивает унифицированное развертывание для моделей нескольких фреймворков, поддерживая параллельное выполнение, динамическое пакетирование и ансамблевые модели, одновременно максимизируя использование оборудования за счет интеллектуального планирования.

Релевантные статьи об ИИ и технологических трендах

Будьте в курсе последних инсайтов, инструментов и инноваций, формирующих будущее ИИ и технологий.

Grok AI: Бесплатное неограниченное создание видео из текста и изображений | Руководство 2024

Grok AI предлагает бесплатное неограниченное создание видео из текста и изображений, делая профессиональное создание видео доступным для всех без навыков редактирования.

Настройка Grok 4 Fast в Janitor AI: Полное руководство по ролевой игре без фильтров

Пошаговое руководство по настройке Grok 4 Fast в Janitor AI для неограниченной ролевой игры, включая настройку API, параметры конфиденциальности и советы по оптимизации

Топ-3 бесплатных расширений для ИИ-программирования в VS Code 2025 - Повышение производительности

Откройте для себя лучшие бесплатные расширения для ИИ-программирования в Visual Studio Code в 2025 году, включая Gemini Code Assist, Tabnine и Cline, чтобы улучшить вашу