Annotation

- Введение

- Понимание многоязычных больших языковых моделей

- Что такое многоязычные большие языковые модели?

- Ключевые вклады исследований MLLM

- Значимость многоязычных языковых моделей

- Недавний прогресс и глобальные вызовы

- Стратегии выравнивания параметров в MLLMs

- Ресурсы данных для обучения MLLM

- Методы выравнивания с настройкой параметров

- Будущие направления исследований и вызовы

- Плюсы и минусы

- Заключение

- Часто задаваемые вопросы

Многоязычные большие языковые модели: Полное руководство по ресурсам и будущим тенденциям

Многоязычные большие языковые модели (MLLM) обеспечивают межъязыковое общение ИИ с комплексными ресурсами, таксономией и будущими тенденциями для глобального

Введение

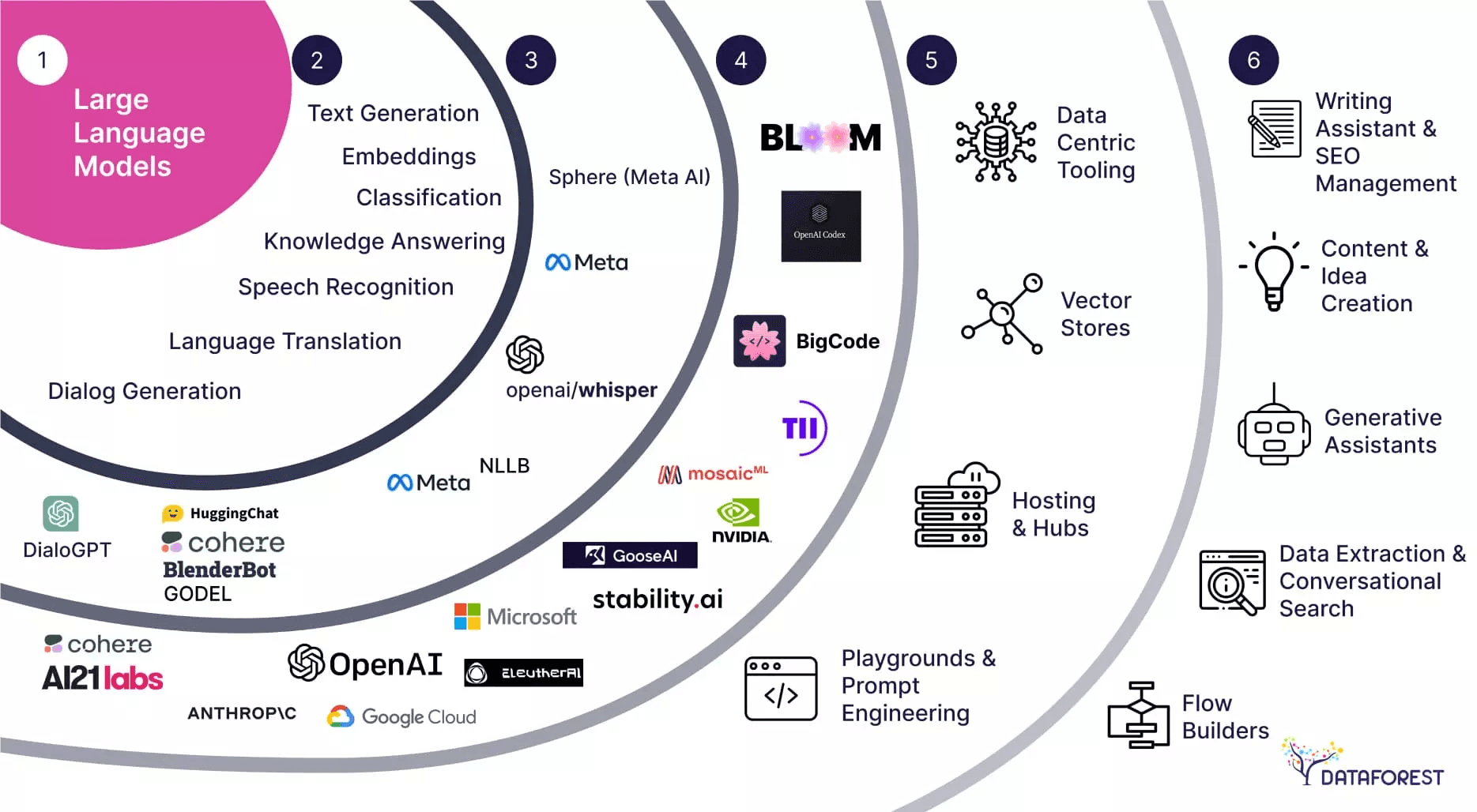

Многоязычные большие языковые модели (MLLMs) представляют собой преобразующее достижение в области искусственного интеллекта, обеспечивая бесшовное общение в разнообразных языковых ландшафтах. Эти сложные системы ИИ могут обрабатывать, понимать и генерировать текст на нескольких языках одновременно, разрушая традиционные языковые барьеры, которые долгое время препятствовали глобальному сотрудничеству и обмену информацией. Поскольку организации всё чаще работают через международные границы, спрос на надежные многоязычные возможности ИИ продолжает экспоненциально расти.

Понимание многоязычных больших языковых моделей

Что такое многоязычные большие языковые модели?

Многоязычные большие языковые модели (MLLMs) представляют собой значительный эволюционный шаг по сравнению с традиционными одноязычными системами ИИ. В отличие от своих одноязычных аналогов, MLLMs специально разработаны для обработки нескольких языков в единой архитектуре, обеспечивая межъязыковое понимание и генерацию без необходимости в отдельных моделях для каждого языка. Этот интегрированный подход позволяет более эффективно использовать ресурсы и способствует настоящим многоязычным возможностям, отражающим гибкость человеческого языка.

Ключевое новшество MLLMs заключается в их способности изучать общие представления между языками, захватывая языковые паттерны и семантические отношения, выходящие за границы отдельных языков. Это межъязыковое понимание позволяет применять их в различных областях, от сервисов перевода в реальном времени до многонациональных систем поддержки клиентов, работающих на основе продвинутых ИИ-чатов и инструментов разговорного ИИ.

Ключевые вклады исследований MLLM

Новаторская обзорная статья «Многоязычные большие языковые модели: Обзор ресурсов, таксономии и перспектив» Либо Циня и коллег представляет собой веху в исследованиях многоязычного ИИ. Эта всеобъемлющая работа предоставляет первое систематическое исследование развития MLLM, предлагая исследователям и практикам единую основу для понимания этой быстро развивающейся области. Значимость статьи выходит за рамки академических кругов, предоставляя практические идеи для разработчиков, работающих с API и SDK ИИ для реализации многоязычных возможностей.

Среди её наиболее ценных вкладов — сбор обширных открытых ресурсов, включая курированные наборы данных, исследовательские статьи и бенчмарки производительности. Эта компиляция ресурсов заполняет критический пробел в области, предоставляя разработчикам инструменты, необходимые для ускорения внедрения и оценки MLLM в различных языковых контекстах.

Значимость многоязычных языковых моделей

Недавний прогресс и глобальные вызовы

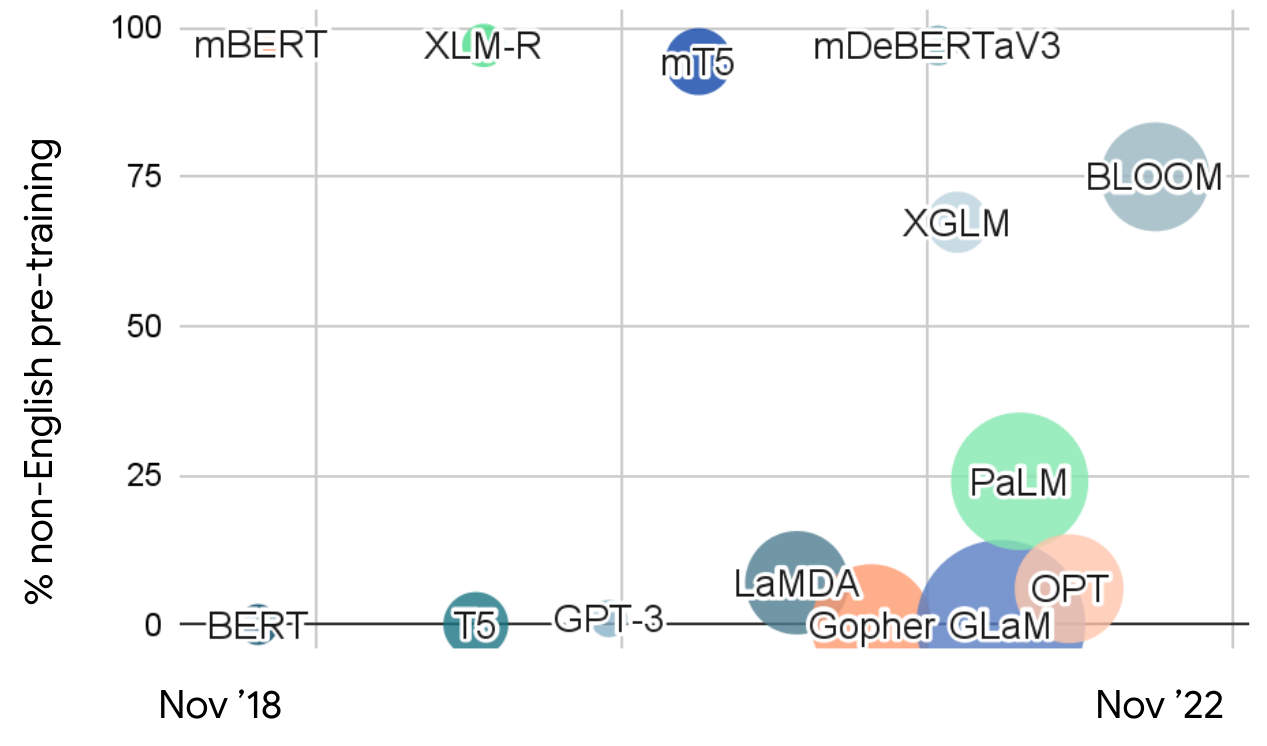

Недавние достижения в больших языковых моделях продемонстрировали замечательные возможности в понимании и генерации естественного языка. Однако преобладающая ориентация на обучение на английском языке создала значительные ограничения для глобального развертывания. С более чем 7000 языков, на которых говорят в мире, и растущими требованиями глобализации, потребность в действительно многоязычных системах ИИ никогда не была более актуальной. Этот разрыв особенно заметен в сценариях с языками с ограниченными ресурсами, где ограниченные данные для обучения и вычислительные ресурсы представляют существенные вызовы.

Англоцентричная предвзятость в большинстве современных LLM создает неравенство в доступности и производительности ИИ в разных языковых сообществах. MLLMs устраняют этот дисбаланс, обеспечивая более равноправный доступ к языковым технологиям, позволяя организациям развертывать последовательные возможности ИИ на глобальных рынках через платформы автоматизации ИИ и многоязычные сервисные системы.

Стратегии выравнивания параметров в MLLMs

Выравнивание параметров представляет собой фундаментальную техническую проблему в разработке MLLM, определяя, насколько эффективно модели могут передавать знания и возможности между языками. Две основные методологии выравнивания — подходы с настройкой параметров и с замороженными параметрами — предлагают различные преимущества и компромиссы для разных сценариев развертывания.

Выравнивание с настройкой параметров включает активную корректировку параметров модели во время обучения для оптимизации межъязыковой производительности. Этот метод обычно дает превосходные результаты, но требует значительных вычислительных ресурсов и тщательной настройки, чтобы избежать переобучения или языковых помех. В отличие от этого, выравнивание с замороженными параметрами использует существующие возможности модели через стратегические методы промптинга, предлагая большую эффективность и более быстрое развертывание для организаций, использующих агентов и ассистентов ИИ.

Ресурсы данных для обучения MLLM

Эффективность многоязычных моделей критически зависит от качества и разнообразия данных обучения на разных языковых этапах. Данные предварительного обучения из моделей, таких как GPT-3, mT5 и ERNIE 3.0, обеспечивают фундаментальное языковое понимание, в то время как данные тонкой настройки из ресурсов, таких как Flan-PaLM и BLOOMZ, позволяют оптимизировать модель для конкретных задач. Данные обучения с подкреплением на основе обратной связи от человека (RLHF) дополнительно уточняют поведение модели на основе человеческих предпочтений, создавая более естественные и контекстуально уместные многоязычные взаимодействия.

Каждая категория данных служит различным целям в конвейере разработки модели, с многоязычным предварительным обучением, устанавливающим широкие языковые возможности, и контролируемой тонкой настройкой, специализирующей модели для конкретных приложений. Тщательное курирование и балансировка этих наборов данных между языками необходимы для достижения надежной межъязыковой производительности, особенно для разработчиков, работающих с сервисами хостинга моделей ИИ.

Методы выравнивания с настройкой параметров

Выравнивание с настройкой параметров использует систематический, многоэтапный подход для оптимизации производительности MLLM между языками. Процесс начинается с выравнивания предварительного обучения, где модели изучают фундаментальные языковые паттерны из разнообразных многоязычных наборов данных. Этот базовый этап устанавливает основные межъязыковые возможности и общие представления модели.

Затем контролируемое выравнивание тонкой настройки уточняет эти возможности для конкретных задач и приложений, включая данные в формате инструкций для улучшения производительности на целевых случаях использования. Выравнивание обучения с подкреплением на основе обратной связи от человека дополнительно улучшает поведение модели, включая человеческие предпочтения и соображения безопасности. Наконец, выравнивание тонкой настройки для последующих задач адаптирует модели для конкретных сценариев развертывания, с эффективными по параметрам техниками, такими как LoRA (низкоранговая адаптация), оптимизирующими использование ресурсов.

Будущие направления исследований и вызовы

Продолжающаяся эволюция MLLM сталкивается с несколькими критическими исследовательскими вызовами, требующими пристального внимания. Обнаружение и смягчение многоязычных галлюцинаций представляет собой особенно актуальную область, так как модели должны поддерживать точность и надежность в разнообразных языковых контекстах. Редактирование знаний представляет еще одну значительную проблему, требующую методов для непрерывного обновления и корректировки информации во всех поддерживаемых языках при сохранении согласованности.

Соображения безопасности и справедливости выходят за рамки технической производительности, охватывая этичное развертывание в глобальных контекстах. Установление всеобъемлющих бенчмарков безопасности, разработка эффективных механизмов фильтрации небезопасного контента и обеспечение равноправной производительности для языков с ограниченными ресурсами необходимы для ответственной разработки MLLM. Эти усилия согласуются с более широкими инициативами в технологии изучения языков и многоязычных новостных приложений, которые обслуживают разнообразную глобальную аудиторию.

Плюсы и минусы

Преимущества

- Обеспечивает бесшовное общение на нескольких языках одновременно

- Способствует межкультурному пониманию и глобальному сотрудничеству

- Поддерживает разработку международных приложений и сервисов

- Улучшает точность в многоязычных задачах обработки естественного языка

- Снижает необходимость в нескольких одноязычных системах ИИ

- Повышает доступность для не говорящих на английском языке населения

- Поддерживает развивающиеся рынки и сообщества с языками с ограниченными ресурсами

Недостатки

- Требует обширных многоязычных наборов данных и вычислительных ресурсов

- Сложно оптимизировать производительность для всех поддерживаемых языков

- Возможность предвзятостей и неточностей в языках с ограниченными ресурсами

- Сложные соображения безопасности и этики в разных культурах

- Более высокие затраты на разработку и поддержку по сравнению с одноязычными системами

Заключение

Многоязычные большие языковые модели представляют собой ключевое достижение в искусственном интеллекте, предлагая беспрецедентные возможности для межъязыкового общения и глобального сотрудничества. Поскольку исследования продолжают решать текущие ограничения в смягчении галлюцинаций, редактировании знаний и обеспечении безопасности, MLLMs будут играть всё более важную роль в преодолении языковых разрывов и обеспечении более инклюзивных систем ИИ. Всеобъемлющая таксономия и компиляция ресурсов, предоставленные недавними обзорами, устанавливают прочную основу для будущих инноваций, направляя исследователей и практиков к более эффективным и справедливым многоязычным решениям ИИ, которые служат разнообразным глобальным сообществам.

Часто задаваемые вопросы

Каковы основные проблемы в разработке многоязычных больших языковых моделей?

Ключевые проблемы включают обработку более 7000 языков с различной доступностью данных, удовлетворение требований глобализации к межъязыковому общению и решение сценариев с ограниченными ресурсами, где данные и вычислительные ресурсы ограничены, особенно для недостаточно представленных языков.

Каковы основные преимущества использования многоязычных больших языковых моделей?

MLLM обеспечивают беспрепятственное общение на нескольких языках, способствуют межкультурному взаимопониманию, поддерживают разработку глобальных приложений, повышают точность многоязычных задач НЛП и сокращают необходимость в поддержании отдельных одноязычных систем ИИ.

Какие будущие области исследований важны для развития MLLM?

Критические области исследований включают решение проблем многоязычных галлюцинаций, улучшение возможностей редактирования знаний на разных языках, установление комплексных эталонов безопасности, обеспечение справедливости для языков с ограниченными ресурсами и разработку более эффективных стратегий выравнивания.

Каковы ключевые стратегии выравнивания параметров в MLLM?

MLLM в основном используют стратегии выравнивания с настройкой параметров и замороженными параметрами. Настройка параметров включает корректировку параметров модели для межъязыковой оптимизации, в то время как замороженные параметры используют существующие возможности через промптинг для большей эффективности.

Как MLLM влияют на глобальную доступность и справедливость ИИ?

MLLM улучшают глобальную доступность ИИ, обеспечивая равноправные языковые технологии в различных сообществах, сокращая англоцентричные предубеждения и поддерживая языки с ограниченными ресурсами, тем самым способствуя справедливости в развертывании ИИ по всему миру.

Релевантные статьи об ИИ и технологических трендах

Будьте в курсе последних инсайтов, инструментов и инноваций, формирующих будущее ИИ и технологий.

Grok AI: Бесплатное неограниченное создание видео из текста и изображений | Руководство 2024

Grok AI предлагает бесплатное неограниченное создание видео из текста и изображений, делая профессиональное создание видео доступным для всех без навыков редактирования.

Настройка Grok 4 Fast в Janitor AI: Полное руководство по ролевой игре без фильтров

Пошаговое руководство по настройке Grok 4 Fast в Janitor AI для неограниченной ролевой игры, включая настройку API, параметры конфиденциальности и советы по оптимизации

Топ-3 бесплатных расширений для ИИ-программирования в VS Code 2025 - Повышение производительности

Откройте для себя лучшие бесплатные расширения для ИИ-программирования в Visual Studio Code в 2025 году, включая Gemini Code Assist, Tabnine и Cline, чтобы улучшить вашу