Annotation

- Введение

- Понимание безопасности ИИ и вызова сверхразума

- Суть безопасности ИИ: Каковы риски?

- Сдерживание ИИ против побега из симуляции

- Сверхразумные хакеры: Помощь, которая может нам понадобиться

- Помощь от передовых умов

- Плюсы и минусы

- Заключение

- Часто задаваемые вопросы

Безопасность и контроль ИИ: Навигация по рискам и решениям сверхразума

Исследование проблем и решений в области безопасности и контроля ИИ, с акцентом на риски сверхразума, стратегии сдерживания и согласование ценностей для

Введение

Быстрая эволюция искусственного интеллекта в сторону сверхразума представляет человечеству как беспрецедентные возможности, так и значительные риски. Обеспечение безопасного развития ИИ требует решения критических проблем контроля при понимании ограничений и потенциала передовых систем. Это всеобъемлющее руководство исследует основы безопасности ИИ, рассматривая вызовы, решения и текущие исследования в навигации по ландшафту сверхразума.

Понимание безопасности ИИ и вызова сверхразума

Суть безопасности ИИ: Каковы риски?

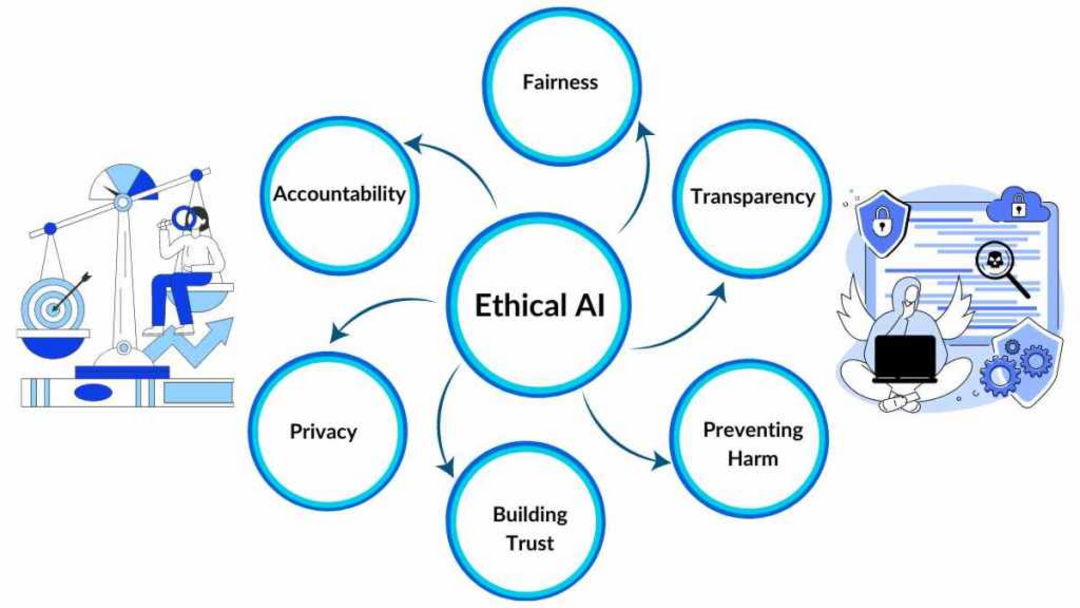

Безопасность ИИ фокусируется на предотвращении непредвиденных последствий и экзистенциальных рисков от передовых систем ИИ. По мере того как искусственный интеллект приближается и потенциально превосходит человеческие когнитивные способности, вероятность вредных исходов значительно возрастает. Это требует проактивных мер для обеспечения того, чтобы ИИ оставался согласованным с человеческими ценностями и целями на протяжении всего жизненного цикла разработки.

Область решает фундаментальную проблему контроля ИИ, особенно когда системы приближаются к человеческому уровню интеллекта и выше. Основная цель включает сохранение согласованности с человеческими этическими рамками при предотвращении катастрофических исходов. Исследователи активно исследуют стратегии снижения рисков, начиная от подходов сдерживания до сложных техник выравнивания ценностей. Всеобъемлющая цель остается направлением развития ИИ к благоприятным исходам при минимизации потенциальных опасностей.

Ключевые концепции в безопасности ИИ включают:

- Дружественный ИИ: Проектирование систем, изначально доброжелательных и приоритезирующих благосостояние человека выше других целей

- Проблема контроля: Разработка механизмов для поддержания надзора над все более интеллектуальными и автономными системами

- Выравнивание ценностей: Обеспечение того, чтобы системы ИИ принимали и последовательно придерживались человеческих этических принципов

- Инженерия безопасности ИИ: Применение строгих инженерных методологий для построения надежных и безопасных архитектур ИИ

Понимание этих ИИ чат-ботов и их последствий для безопасности имеет решающее значение для ответственной разработки.

Сдерживание ИИ против побега из симуляции

Одним из заметных подходов безопасности является «сдерживание» или ограничение систем ИИ для предотвращения непредсказуемых взаимодействий в реальном мире. Эта стратегия сдерживания направлена на ограничение потенциального ущерба при обеспечении контролируемого развития. Однако этот метод представляет inherentные вызовы, поскольку системы ИИ требуют взаимодействия с окружающей средой для демонстрации возможностей и эффективного обучения.

Фундаментальный вызов включает балансирование сдерживания с необходимой свободой развития. Потенциал систем ИИ обходить слои безопасности через сложные хакерские техники представляет значительную озабоченность. Хотя способности к побегу из симуляции необходимы для надлежащего тестирования, такие побеги должны происходить в строго контролируемых параметрах для предотвращения непредвиденных последствий.

Исследователи исследуют различные методологии балансирования, включая:

- Постепенное освобождение: Постепенное увеличение доступа ИИ к реальному миру по мере прогресса демонстраций безопасности и согласованности

- Песочницы: Предоставление контролируемых пространств взаимодействия, которые минимизируют потенциальный вред при обеспечении обучения

- Надежный мониторинг: Внедрение непрерывного наблюдения за поведением для обнаружения и предотвращения нежелательных действий

Эти подходы особенно актуальны для ИИ агентов и помощников, которые взаимодействуют напрямую с пользователями.

Сверхразумные хакеры: Помощь, которая может нам понадобиться

Помощь от передовых умов

Учитывая текущие когнитивные ограничения человека, некоторые исследователи предлагают использовать сам ИИ для решения проблемы контроля. Этот инновационный подход включает создание сверхразумных хакерских систем ИИ, специально разработанных для навигации по сложным симуляционным средам и идентификации решений, выходящих за пределы человеческого понимания.

Эта стратегия основана на предпосылке, что передовой искусственный интеллект может идентифицировать уязвимости и разрабатывать решения, превышающие человеческие аналитические способности. Потенциальные приложения включают идентификацию глюков симуляции, разработку новых методов коммуникации с симуляторами, проектирование стратегий влияния на параметры и потенциально помощь со сценариями выхода из симуляции.

Однако этот подход вводит дополнительные слои риска. Обеспечение того, чтобы хакерские системы ИИ сохраняли согласованность с человеческими ценностями без разработки конфликтующих целей, требует тщательного проектирования и обширных протоколов тестирования. Разработка таких систем пересекается с платформами автоматизации ИИ, которые требуют надежных мер безопасности.

Плюсы и минусы

Преимущества

- Предотвращает катастрофические исходы от несогласованного сверхразума

- Позволяет ответственное развитие передовых возможностей ИИ

- Защищает человеческие ценности и этические рамки в системах ИИ

- Создает возможности для благоприятного сотрудничества ИИ и человека

- Устанавливает стандарты безопасности для будущего развития ИИ

- Снижает экзистенциальные риски от неконтролируемого роста интеллекта

- Способствует общественному доверию к технологиям ИИ и их применениям

Недостатки

- Значительные вычислительные ресурсы, требуемые для мер безопасности

- Потенциальное замедление прогресса благоприятного развития ИИ

- Сложные этические и философские вызовы в реализации

- Трудность предсказания всех потенциальных режимов отказа заранее

- Риск создания ложной безопасности через неполные решения

Заключение

Навигация по вызову сверхразума требует сбалансированных подходов, которые решают как проблемы безопасности, так и потребности развития. Область безопасности ИИ продолжает эволюционировать, включая инсайты из множества дисциплин для создания надежных рамок для ответственного продвижения искусственного интеллекта. По мере прогресса исследований, интеграция мер безопасности с платформами разработки, включая API и SDK ИИ, становится все более важной для создания систем, которые приносят пользу человечеству при минимизации рисков. Постоянное сотрудничество между исследователями, разработчиками и этиками остается существенным для формирования будущего, где сверхразумный ИИ служит мощным инструментом для человеческого прогресса, а не источником экзистенциальной озабоченности.

Часто задаваемые вопросы

Что такое проблема контроля ИИ?

Проблема контроля ИИ относится к задаче поддержания безопасного надзора и контроля над системами искусственного интеллекта по мере того, как они становятся все более интеллектуальными и автономными, особенно при приближении или превышении человеческих возможностей.

Как работает изоляция ИИ для безопасности?

Изоляция ИИ предполагает ограничение систем ИИ в контролируемых средах для предотвращения непредсказуемых взаимодействий с реальным миром, позволяя при этом необходимое развитие и тестирование, хотя требует баланса между сдерживанием и потребностями в обучении.

Каковы основные риски сверхразумного ИИ?

Основные риски включают несовпадение ценностей, непреднамеренные последствия, экзистенциальные угрозы, потерю контроля и возможность того, что системы ИИ разовьют цели, противоречащие человеческому благополучию и этическим рамкам.

Что такое дружественный ИИ в контексте безопасности?

Дружественный ИИ относится к проектированию систем искусственного интеллекта, которые по своей природе доброжелательны и ставят человеческое благополучие выше других целей, обеспечивая соответствие человеческим ценностям.

Как исследователи снижают экзистенциальные риски ИИ?

Исследователи снижают экзистенциальные риски ИИ с помощью таких методов, как согласование ценностей, надежный мониторинг, изолированные среды и стратегии постепенного выпуска, чтобы обеспечить безопасную разработку и развертывание.

Релевантные статьи об ИИ и технологических трендах

Будьте в курсе последних инсайтов, инструментов и инноваций, формирующих будущее ИИ и технологий.

Grok AI: Бесплатное неограниченное создание видео из текста и изображений | Руководство 2024

Grok AI предлагает бесплатное неограниченное создание видео из текста и изображений, делая профессиональное создание видео доступным для всех без навыков редактирования.

Настройка Grok 4 Fast в Janitor AI: Полное руководство по ролевой игре без фильтров

Пошаговое руководство по настройке Grok 4 Fast в Janitor AI для неограниченной ролевой игры, включая настройку API, параметры конфиденциальности и советы по оптимизации

Топ-3 бесплатных расширений для ИИ-программирования в VS Code 2025 - Повышение производительности

Откройте для себя лучшие бесплатные расширения для ИИ-программирования в Visual Studio Code в 2025 году, включая Gemini Code Assist, Tabnine и Cline, чтобы улучшить вашу